Как сделать страницу доступной оффлайн

5 способов читать ваши любимые веб-сайты оффлайн.

Как со стационарного компьютера, лэптопа, планшета или мобильного телефона получить доступ к веб-страницам в оффлайновом режиме? В нашем кратком обзоре мы познакомим вас с пятью способами сделать это.

1. Read It – читайте сейчас, читайте позже

Read it – это Chrome-расширение, позволяющее сохранить нужный контент сайта в облако и в последствии пользоваться им с планшета или мобильного телефона. Самый большой плюс Read it в том, что вы сохраняете только контент сайта, исключая рекламу и другой ненужный материал, не имеющий отношения к основному содержанию. Таким образом, в итоге вы получаете только чистую информацию.

Read It сохраняет только контент, а не весь веб-сайт полностью. Поэтому, открывая сайты с большим количеством статей в рамках одной страницы (например, блог), существует вероятность того, что вам не удастся сохранить нужную вам статью. Тем не менее, вы можете это сделать – выделите мышью интересующий ваш материал, включая изображения, и нажмите кнопку «Klip Me».

Read It для сети

Теперь, когда вы захотите познакомиться с ранее сохраненным контентом, откройте новую вкладку в Chrome и нажмите иконку «Klip Me». Вы увидите все сохраненные вами статьи для дальнейшего изучения в оффлайновом режиме. Для того чтобы получить доступ к данному материалу на мобильном устройстве, нужно интегрировать Read It с вашим аккаунтом на Google, сохранив интересующий вас контент в облаке. В правой колонке кликните по кнопке «Sign In» и разрешите доступ к Google.

Когда вы разрешите доступ к Google, ваши файлы будут синхронизированы в облако, и вы сможете пользоваться ими в любое время и в любом месте, зайдя на веб-сайт Klip.me (учтите, что для синхронизации вам потребуется интернет-соединение).

2. Spool – сохраняйте видео и веб-страницы

Spool – новое расширение, предлагающее альтернативные способы получения доступа к файлам в оффлайн режиме. У Spool есть не только веб-приложения и расширения для браузеров Chrome и Firefox, но и приложения для Android и iOS, а также закладурки. Так что вы можете пользоваться данным сервисом на всех браузерах и мобильных устройствах. Spool также дает пользователям возможность интегрировать их аккаунт c Dropbox, и они могут сохранять не только веб-страницы, но и другие типы файлов.

Получаем доступ в Spoon в оффлайн режиме

После сохранения страницы она по умолчанию становится доступной через сеть или мобильные приложения с интернет-соединением. Чтобы получить доступ к своим файлам, будучи оффлайн, откройте свои Spool приложения>перейдите в Настройки>проверьте функцию «Автоматическая загрузка». Синхронизированные файлы будут автоматически сохранятся в вашем мобильном телефоне, так что вы в любое время можете воспользоваться ими вне сети. Если вас беспокоит вопрос с местом, то вы всегда можете удалить эти файлы после прочтения.

3. Read It Later

Read It Later – это еще один способ находиться оффлайн и читать контент сайтов. Что выделяет Read It Later из множества других доступных приложений, в том числе Pulse и Flipboard? Вы с легкостью можете сохранять любой материал с другого приложения прямо на Read It Later, и позже знакомиться с ним оффлайн. Вы также можете извлекать информацию с Instapaper и Delicious. Что делает его более интересным? Участие пользователей в улучшении качества Read It Later – ими создаются многие внешние приложения.

4. Readability

Readability – замечательное приложение, которое доступно в качестве расширения для Chrome. Оно также включает собственное приложение для Android и iOS.

Чтобы приступить к работе, зайдите на веб-сайт Readability и создайте свой аккаунт. Затем перейдите на страницу приложений и скачайте расширение для Chrome, iOS и Android. Существует также множество приложений, которые интегрируются с Readability и доступны для скачивания. Это приложение, как и другие, синхронизирует сохраненные веб-страницы с вашим мобильным телефоном, чтобы впоследствии вы могли читать контент в оффлайне.

Вот и все. Теперь после каждой синхронизации на Evernote выбранные вами статьи будут доступны для чтения в оффлановом режиме.

Заключение

Теперь, благодаря этим пяти способам, тепрь вы можете сохранять содержимое сайтов и читать его на рыбалке или во время полета без доступа в интернет. Конечно, существует и множество других вариантов, в том числе платных (Instapaper, например) или подходящих только для компьютера. Однако я убежден, что большинство из нас заинтересовано в минимально-бесплатных альтернативах с мобильным доступом и всеми необходимыми инструментами.

Как сделать сайт доступным оффлайн.

Как сделать так, чтобы пользователь смог использовать ваш сайт, даже если пропало интернет подключение или его вообще нет? Сегодня мы об этом и поговорим.

Для чего это нужно?

Ваши пользователи больше не используют свои десктопные компьютеры, подключенные по проводам к интернету. Они посещают ваш сайт с телефона в лифте, с планшета в метро или с ноутбука, пока тесно сидят на месте 25E.

Именно по этому современные браузеры поддерживают ServiceWorkers, новую технологию, которая позволяет вам предоставлять пользователям доступ к вашему сайту, даже если они не в сети.

UpUp.start( <

‘content-url’: ‘offline.html’ // покажет эту страницу пользователям не в сети

>);

Несмотря на то, что использовать эту технологию просто, она достаточно мощная, чтобы поддерживать все, что угодно, от показа простых сообщений до создания полностью функциональной одиночной страницы приложения, доступной оффлайн с кастомизацией данных для каждого пользователя.

Как это работает?

Когда пользователь посещает ваш сайт в первый раз, UpUp регистрирует ServiceWorker с вашим браузером и дает ему список файлов, которые нужно закэшировать.

Следующий раз, когда пользователь посещает ваш сайт, ServiceWorker слушает сеть на наличие ошибок. Если соединение потеряно, и ServiceWorker найдет нужные файлы в кеше, то он вернет их также, как если бы они пришли из сети.

Итак, сегодня мы рассмотрели очень интересную технологию, которой, думаю, вы сможете найти применение. Спасибо за внимание!

Копирование материалов разрешается только с указанием автора (Михаил Русаков) и индексируемой прямой ссылкой на сайт (http://myrusakov.ru)!

Добавляйтесь ко мне в друзья ВКонтакте: http://vk.com/myrusakov.

Если Вы хотите дать оценку мне и моей работе, то напишите её в моей группе: http://vk.com/rusakovmy.

Если Вы не хотите пропустить новые материалы на сайте,

то Вы можете подписаться на обновления: Подписаться на обновления

Если у Вас остались какие-либо вопросы, либо у Вас есть желание высказаться по поводу этой статьи, то Вы можете оставить свой комментарий внизу страницы.

Порекомендуйте эту статью друзьям:

Если Вам понравился сайт, то разместите ссылку на него (у себя на сайте, на форуме, в контакте):

Комментарии ( 3 ):

Полезная статья ребята

Здравствуйте Михаил не могли бы вы написать статью на тему WebRTC видео конференции т.д думаю многим будет интерестно спасибо

Возьмём на заметку! Спасибо!

Для добавления комментариев надо войти в систему.

Если Вы ещё не зарегистрированы на сайте, то сначала зарегистрируйтесь.

Copyright © 2010-2021 Русаков Михаил Юрьевич. Все права защищены.

7 утилит для скачивания сайта в офлайн

Порой бывает, что нам необходимо изучить какой-либо ресурс в режиме офлайн. Ситуации могут быть разные: отсутствие подключения к интернету, сайт либо его домен переезжает, ведутся ремонтные работы. Или конкретный ресурс вам очень привлекателен своим содержанием, но нет гарантий его долговременного существования в сети. Но, как известно, выход есть всегда. Представляем вашему вниманию лучшие сервисы для загрузки любого сайта и дальнейшего его изучения в офлайн-режиме.

HTTrack

Этот сервис относится к бесплатным. В его функцию входит загрузка любого сайта для работы с последним без подключения к интернету. Технология основана на перекачке всех данных на ваш винчестер. В указанном вами месте будут сохранены все html-странички, изображения, видео (то есть весь полезный контент).

Программа HTTrack скопирует структурное расположение составляющих сайта. По окончании процедуры вам необходимо через свой браузер открыть файлы, скопированные на жёсткий диск. Также через некоторое время вы можете обновить состояние сайта при подключении к интернету, если знаете, что за это время на ресурсе что-то изменилось. Следует отметить, что загрузки, прерванные в момент копирования, догружаются автоматически. Программу можно настроить на свой лад, следуя встроенным инструкциям.

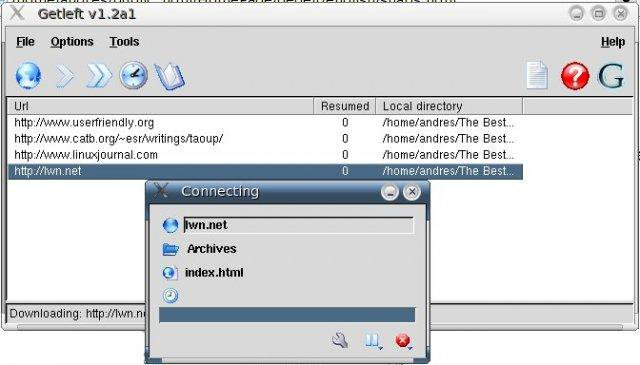

GetLeft

Данный софт удобен тем, что начинает скачивание сайта с определёнными вами настройками при указании его адреса. Во время перекачки данных GetLeft автоматически произведёт коррекцию страниц и замену ссылок на относительные. Вы сможете на закачанном сайте переходить по ссылкам, как при подключении к интернету. Кроме того, изучив структуру сайта и его карту распределения страниц, вы можете отказаться от загрузки некоторых файлов либо разделов. Эта программа отлично работает со средними либо с многостраничными ресурсами при условии исключения больших файлов. Также тут имеется поддержка 14 языков.

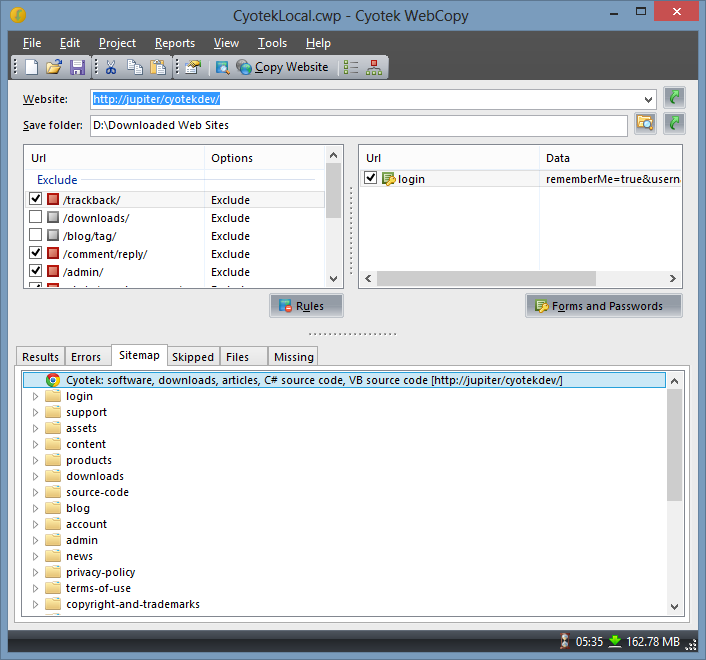

Cyotek Webcopy

Данная программа подходит для полной и раздельной закачки сайта, чтобы в последующем пользоваться им без подключения к сети. Весь процесс перекачки начинается со сканирования, после чего ссылки изображений, медиафайлов, статей и прочего переназначаются для сохранности структуры на жёстком диске. Программа, изучив код сайта и расположение ссылок в его строении, такую же структуру сохраняет на ваш винчестер. Cyotek Webcopy полностью бесплатен, обладает понятным и удобным интерфейсом.

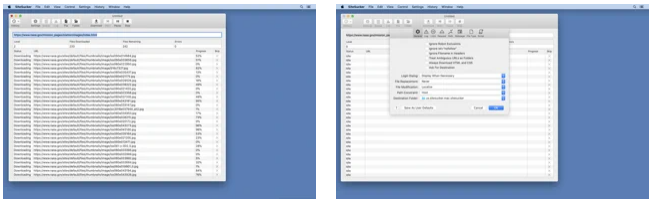

SiteSucker

Данное приложение функционирует только на системе Mac. Его назначением является копирование структуры и контента сайта в автоматическом режиме. После ввода и подтверждения интересующего вас URL в точности копируется всё, что касается рабочего ресурса. Все данные сохраняются в определённом документе, доступном для сопутствующих программ в любое время.

Стоит также отметить, что при закачке ресурса можно определить конечный язык его отображения. Перекачанный таким образом сайт будет уже на удобном для вас языке без изменения структуры, расположения мультимедиа файлов и без привязки к интернет-соединению. В арсенале программы имеются следующие языки: английский, французский, немецкий, итальянский, португальский и испанский.

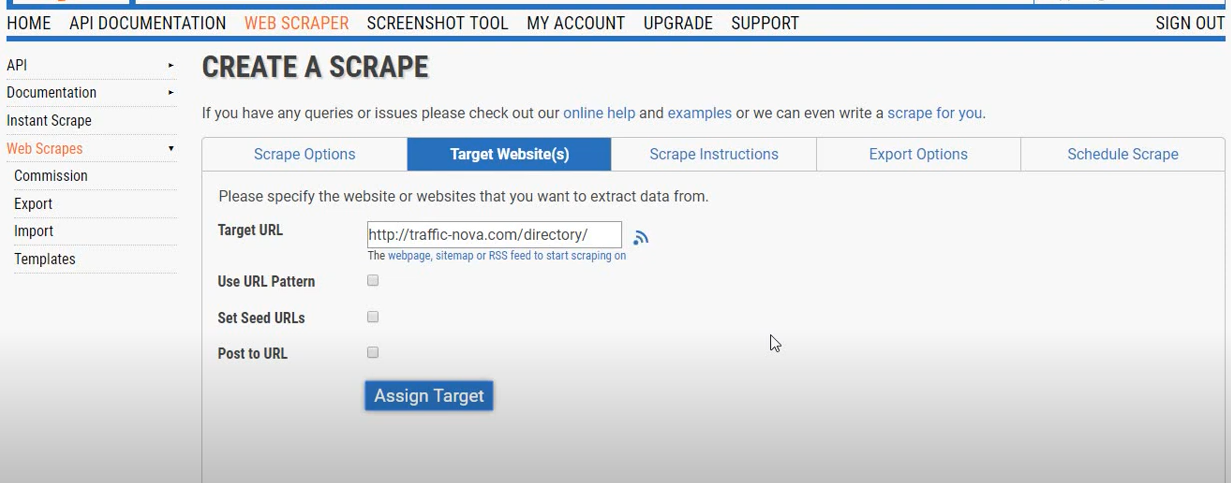

GrabzIt

Программа отличается от остальных своей возможностью извлечения информации (работает даже с документами PDF). Всё начинается с определения закачиваемого сайта либо нужных разделов, данных, а также места их распаковки на компьютере. Потом следует обозначить способ упаковки. В программе имеется свой специальный браузер, который позволяет скопировать абсолютно все данные (как динамические, так и статические) без нарушения какой-либо их составляющей. Преимуществом данной программы является то, что после распаковки страниц и файлов мультимедиа вы сможете пользоваться всем функционалом сайта, будто он открыт в интернете.

Teleport Pro

Этот инструмент позиционируется как сборщик данных из сети. Его прямым назначением является проникновение на запароленные сайты. Он способен фильтровать файлы по типу и производить поиск по ключевым фразам. Teleport без труда осилит сайт любого размера. Посредством многостороннего сканирования он поэтапно обрабатывает все данные. Это позволяет снизить время обработки конкретного сайта.

К функциям программы также относится поиск файлов по ключевикам на заданном ресурсе. Перекачка возможна полностью либо частями с сохранением всех работающих ссылок, файлов любого размера и типа, с любым способом взаимодействия программного кода и элементов дизайна.

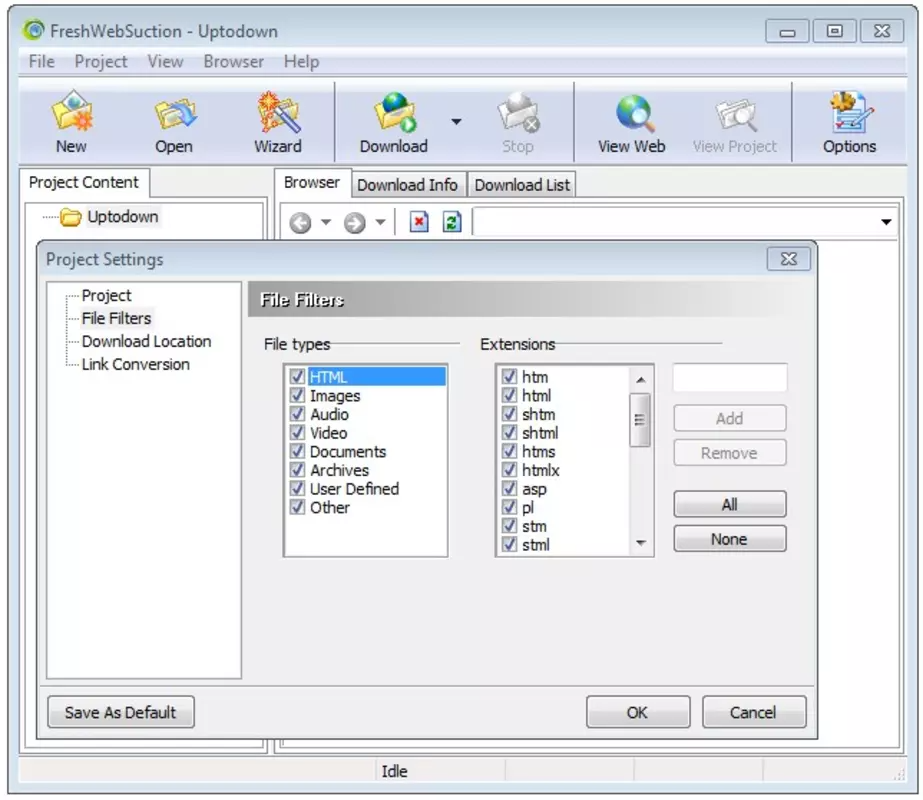

Fresh WebSuction

Программа разработана как браузер для Windows. Но в её функцию входит не только просмотр интернет-порталов. Это также загрузчик последних вариантов страниц сайта для просмотра их в офлайн-режиме. Располагаться они будут на диске компьютера. Выбор элементов загрузки неограничен. Весь контент частично либо полностью будет доступен в автономном режиме.

Создаём офлайн-страницу для своего сайта

Можно долго убеждать себя, что ваш хостинг-провайдер самый лучший и ваш сайт всегда онлайн. Но всё равно вы не убережёте себя от вездесущего «закона подлости» или правила Мёрфи, которое гласит:

Всё, что может пойти не так, пойдёт не так.

Об этом помнят, когда красиво оформляют страницу 404. У разработчиков нет цели показать её пользователям намеренно. Просто они понимают, что, несмотря ни на что, кто-нибудь когда-нибудь на неё попадёт.

Но бывает так, что ваша красиво свёрстанная страница 404 бесполезна. Что, если случатся перебои в работе сервера? А что, если у пользователя пропадёт сеть? Всё это может произойти и обязательно произойдёт. Почему бы не позабавить пользователя во время этих событий?

Для этого можно использовать технологию Service Worker, которая поможет пойти против закона Мёрфи в случае сбоя сети или сервера. После установки worker сможет перехватывать любые запросы к вашему домену. Если что-то пойдёт не так с запросом (что неизбежно), то можно предоставить браузеру инструкции на этот случай. Service Worker — это возможность обернуть серверный негатив в небольшой браузерный позитив. Если у вас страница 404 уже красиво оформлена, то почему бы не добавить к ней не менее привлекательную офлайн-страницу?

Перейдите наконец на HTTPS

Сначала переведите свой сайт на HTTPS, если до сих пор не сделали этого. В противном случае вы не сможете использовать Service Worker. Хотя есть небольшая оговорка — локально worker’ы будут работать нормально и без HTTPS, но в продакшене этот протокол обязателен.

Сделайте офлайн-страницу

Предположим, что ваш сайт уже использует HTTPS, в таком случае можем перейти к созданию офлайн-страницы. Сделайте её настолько серьёзной или причудливой, насколько это вписывается в рамки бренда. Если, предположим, ваш сайт посвящён ресторанному бизнесу, вы могли бы добавить номер и адрес заведения. Для вдохновения посмотрите на офлайн-страницу прошлогодней конференции «Амперсанд».

Также не забудьте поместить офлайн-страницу на подходящий URL, например, /offline.html

Позаботьтесь о предварительном кешировании офлайн-страницы

Убедитесь, что ваша офлайн-страница сохраняется в кеше. Можете использовать Cache API для сохранения. Можете сохранить сколько угодно страниц и назвать их как захочется. В этом примере назовём закешированную страницу Johny, так в коде на неё можно ссылаться используя JohnyCache :

Скорее всего ваша офлайн-страница связана с CSS-файлом, а также, вероятно, с парой картинок или даже с JavaScript-файлами. Это всё можно закешировать.

Убедитесь, что все URL-адреса верны. Если хотя бы один из URL’ов не будет получен, то все остальные элементы не закешируются.

Перехват запросов

Напишем довольно консервативный скрипт со следующей логикой:

Вот как это выглядит в JavaScript:

Подключение сценария service worker’а

Это сообщает браузеру о начале установки service worker’а, но предварительно убедившись, что браузер понимает, о чём идёт речь. Не забывайте отлавливать исключения.

Что дальше?

Отлично, теперь вы можете быть уверены, что если пользователи не могут подключиться к сайту, то они увидят не банальное сообщение об ошибке, а крутую офлайн-страницу. Вы сделали небольшой шаг против закона Мёрфи.

Вы можете сделать многое другое с worker’ами. Что, если каждый раз, когда вызывается страница, она могла бы потом сохраняться копией в кеше? Затем, когда пользователь перейдёт на неё, находясь не в сети, вы сможете ему её показать.

Или что, если вместо того, чтобы обратиться к серверу, вы проверили бы наличие файла в кеше. Можно выводить кешированную версию, которая явно быстрее и при этом обновлять её в фоновом режиме. Это может быть хорошим вариантом для сайта с изображениями.

Вариантов много, поэтому сложность заключается не в написании кода, а в определении алгоритма. Когда вы проработаете алгоритм, то можете спокойно переводить его в код на JavaScript.

Четыре способа загружать и читать сайты оффлайн

Если вам нужно скачать сайт или отдельные страницы, рекомендуем несколько проверенных и надежных способов.

1. Загружать отдельные веб-страницы

На ПК

В системах Windows, Mac и Linux просто нажмите Ctrl+S на клавиатуре во время работы в браузере, чтобы появилось окно “Save page”, из которого сохраните страницу в выбранном подкаталоге. Будет сохранен HTML-файл и папка, содержащая всю информацию. Вы можете открыть HTML-файл, чтобы получить сохраненную веб-страницу в вашем браузере без необходимости в интернет-соединении.

На смартфонах

Чтение вебсайта в оффлайне возможно как в мобильном приложении Chrome для Андроида, так и в мобильном приложении Chrome для iOS.

В Chrome для Андроида откройте страницу, которую вы хотите сохранить для просмотра в оффлайн и нажмите на кнопку главного меню в верхнем правом углу. Здесь нажмите значок “Загрузка” и страница будет загружена на устройство. Вы можете открыть ее, чтобы посмотреть веб-страницу в вашем стандартном браузере.

В Chrome для iOS функция “Список для чтения” позволяет сохранять веб-страницы, которые можно прочитать позже. Для этого надо в браузере перейти в меню “Поделиться” и выбрать вариант “Читать позже”. Все сохраненные статьи можно легко получить через пункт меню “Список для чтения” в меню настроек Chrome.

Пользователи iOS могут также использовать функцию “Список для чтения” в Safari, чтобы сохранить содержимое веб-страницы для чтения позже, а также для синхронизации этой страницы на других устройствах.

2. Использование HTTracks (для Windows, Linux и Android)

Httrack.com – популярный инструмент для загрузки всех данных сайта и доступа к нему в оффлайне. Это инструмент с открытым исходным кодом, который можно использовать на платформах Windows, Linux и Android. Он будет загружать весь сайт, переходя от ссылки к ссылке, т. е. он может представить архив в таком виде, как будто вы просматриваете сайт в онлайне.

Хотя HTTracks имеет множество настроек, в нем также есть и простой помощник, который дает возможность новичкам легко скачивать данные веб-сайтов. Вот как им пользоваться:

Установите и запустите HTTracks и нажмите кнопку “Next” (далее), чтобы запустить помощника. Вас попросят дать название проекту, который вы хотите создать. Это название в дальнейшем поможет вам идентифицировать данные, когда вам позже понадобится получить к ним доступ, поэтому выберите его таким, чтобы оно имело смысл.

На следующей странице нажмите кнопку “Add URL” (добавить ссылку) и введите ссылку на сайт, который вы хотите загрузить. Вы можете добавлять несколько сайтов, если нужно загрузить данные более чем одного вебсайта.

Также здесь есть кнопка “Set options” (настройки), где можно найти очень удобные опции для настройки под свои требования. Однако, предварительно надо прочитать руководство по HTTtracks, прежде чем менять что-либо в настройках.

После этого просто нажмите “Next” (далее) и нажмите “Finish” (готово), чтобы начать загружать данные сайта.

Этот процесс может занять много времени, в зависимости от того, насколько большой был ресурс. Может потребоваться даже несколько дней для загрузки массивных сайтов.

К тому же эти данные могут легко занять несколько гигабайт пространства вашего жесткого диска, поэтому перед началом надо обеспечить достаточно свободного места. После загрузки вы можете открыть проект и начать просматривать сайт в вашем стандартном браузере.

Совет: HTTtracks начинает загружать данные, начиная с последних обновлений, и продолжает движение назад. Если вам нужны только последние данные, а не весь сайт, можно остановить процесс загрузки, когда вы будете уверены, что требуемые данные закачаны. Даже если остановить процесс загрузки, все равно можно получить доступ к данным, которые уже были скачаны.

3. Использование SiteSucker (для Mac OS X и iOS)

SiteSucker – отличная альтернатива HTTracks для пользователей Mac OS X и iOS. Он работает схожим образом с HTTracks и скачивает сайты полностью, перепрыгивая со ссылки на ссылку. Вы можете также приостановить загрузку посреди процесса, чтобы просмотреть загруженные веб-страницы и продолжить в любое время.

4. Расширения браузеров для чтения оффлайн

Существует несколько расширения для браузера, с помощью которых можно скачать данные вебсайта и просмотреть его оффлайн.

PageArchiver (для Chrome) позволяет сохранять множество веб-страниц и получать к ним доступ из своего интерфейса. Можно загрузить все веб-страницы, которые открыты в браузере в текущий момент. Просто откройте страницы, которые вам нужны, и загрузите их с помощью PageArchiver.

ScrapBook (для Firefox) позволяет загружать одиночные страницы или сразу весь сайт. Также это расширение упорядочивает загруженный контент в своем интерфейсе, а наличие удобной строки поиска облегчает поиск нужного содержимого.

Mozilla Archive Format (для Firefox). Это расширение, по существу, является улучшенной версией встроенного инструмента для сохранения страниц. Оно гарантирует, что страница будет загружена в точности так, какая она есть, и сжимает файл для уменьшения занимаемого дискового пространства. В дополнение к этому, оно загружает все аудио- и видеофайлы на страницах.