запрет индексации сайта wordpress

Как запретить поисковым системам индексировать сайт на WordPress

Опубликовано: ADv Дата 19.02.2015 в рубрике WP для начинающих Комментировать

Недавно один из наших пользователей спросил, как можно запретить поисковым системам обходить сайт на WordPress и индексировать его. Существует множество ситуаций, когда необходимо закрыть сайт от индексации и появления его в результатах выдачи. В сегодняшней статье мы покажем вам как запретить поисковым системам индексировать сайт на WordPress.

Зачем и кому может понадобиться запрещать поисковые системы на сайте

Для большинства сайтов, поисковые системы являются основным источником трафика. Поэтому возникает вопрос, кто может захотеть блокировать поисковых роботов?

Верите или нет, существует множество пользователей, которые работают над своими сайтами, размещая их на публично доступном домене вместо того, чтобы тестировать его на локальном сервере.

Некоторые люди создают сайты по управлению проектами на WordPress. Также многие используют WordPress для создания личных блогов. Во всех этих ситуациях как раз и понадобится закрыть сайт от индексации поисковыми системами, чтобы вас не нашли раньше, чем вы этого захотите.

Распространенным является заблуждение, что если вы не будете размещать ссылки на свой домен, то поисковые системы никогда не найдут ваш сайт. Это не совсем правда.

Существует множество способов, когда поисковые системы смогут найти сайт, даже если вы нигде его не «засветили». Например:

Множество вещей происходят в сети и ни одна из них не подконтрольна вам. Однако, ваш сайт — в вашей власти, и вы можете заставить поисковые системы не индексировать свой сайт.

Блокируем обход и индексацию своего сайта от поисковых систем

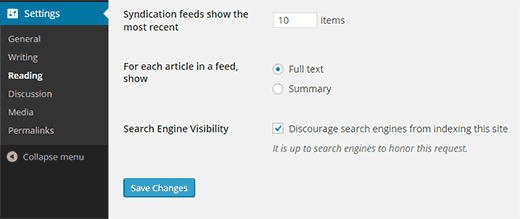

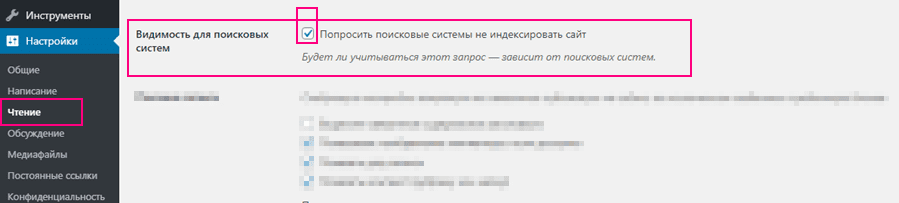

В WordPress есть встроенная функция, которая позволяет вам сообщить поисковым системам о том, что не нужно индексировать ваш сайт. Все, что вам нужно сделать, это перейти в Настройки » Чтение и отметить галочку рядом с «Попросить поисковые системы не индексировать сайт».

Когда галочка отмечена, WordPress добавляет следующую строку в хидер сайта:

Также WordPress изменяет ваш файл robots.txt и добавляет в него:

Эти строки «попросят» робота поисковых систем не индексировать ваши страницы. Однако, тут уже будут решать поисковики, реагировать на эти инструкции или нет. Даже не смотря на то, что эти инструкции воспринимаются, некоторые страницы или случайная картинка может быть проиндексирована.

Как убедиться в том, что ваш сайт не появится в выдаче?

Наиболее эффективным способом заблокировать поисковики — защитить паролем весь сайт на WordPress на уровне сервера. Это означает, что любой, кто попробует получить доступ к сайту, увидит запрос имени пользователя и пароля еще до того, как они увидят сам сайт. К поисковикам это тоже относится. Если вход не удастся, отобразится ошибка 401 и робот уйдет. Защитить весь сайт паролем можно следующим образом.

Защищаем весь сайт паролем с помощью cPanel

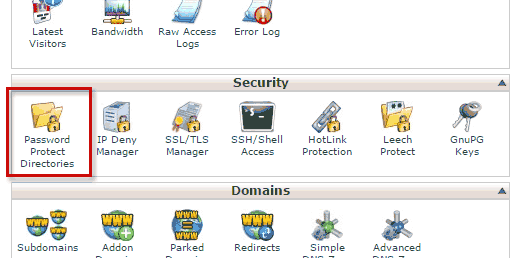

Если ваш хостер предлагает cPanel для управления хостингом, то можно воспользоваться панелью для защиты сайта. Просто логинимся в cPanel и кликаем на меню «password protect directories».

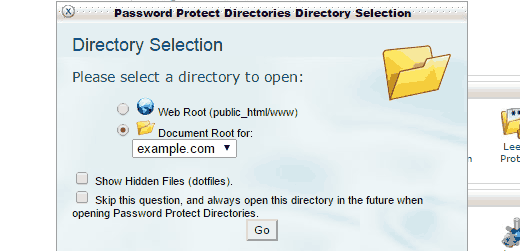

Выскочит всплывающее окно, где нужно будет выбрать корневую директорию.

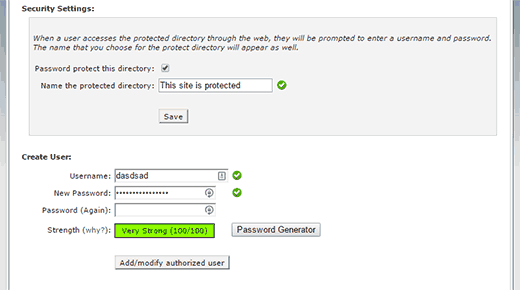

На следующей странице выберите папку, в которой установлен ваш WordPress. Обычно это либо public_html, либо www. После этого отметьте галочку ‘Password protect this directory’. Далее, укажите название для защищенной директории и сохраните изменения.

Далее, вы увидите сообщение о том, что все прошло успешно и ссылку для возврата. Нажмите на эту ссылку, и вы попадете на страницу защиты паролем. Теперь вам нужно указать имя пользователя и пароль, который будет нужен для просмотра вашего сайта.

Вот и все, ваш сайт теперь защищен паролем, и никто, включая поисковые системы, не сможет получить доступ к вашему сайту.

У нас также есть статья о том, как защитить паролем ваш сайт WordPress. Однако, в той статье вам нужно будет использовать плагин. В случае же, если вам придется отключить этот плагин, то сайт станет доступен для поисковиков.

Мы надеемся, что эта статья помогла вам запретить поисковым системам индексировать сайт на WordPress.

Если вы только начинаете разбираться с WordPress, то не забудьте посетить нашу рубрику WordPress для новичков, где мы публикуем материалы специально для новых пользователей WordPress.

По всем вопросам и отзывам просьба писать в комментарии ниже.

Не забывайте, по возможности, оценивать понравившиеся записи количеством звездочек на ваше усмотрение.

Как закрыть сайт WordPress от индексации поисковиков, урок 76

Вступление

Рад вас приветствовать и рад продолжить сотню уроков WordPress. Поисковые боты сканируют в Интернет всё подряд. Однако владельцы и администраторы сайтов могут контролировать этот процесс. Ограничить доступ к своему сайту можно через специальный файл robots.txt. Файл создаётся в рабочем порядке и не входит в коробочную версию CMS. Как закрыть сайт WordPress от индексации в robots.txt в этой статье.

Зачем закрывать сайт от поисковых ботов

Нужно чётко понимать, что закрытие сайта от поисковых роботов, означает запрет на сканирование всего сайта роботами при их обходе.

Есть несколько наиболее распространённых причин по которым нужно закрывать сайт от поисковых ботов.

Во-первых, разумно закрывать сайт на время его создания, то есть сразу после установки CMS WordPress. Во время подготовки сайта создаётся много мусорных файлов, которые не нужно обрабатывать ботам и тем более не нужно, чтобы они попадали в индекс.

Во-вторых, сайт закрывают от сканирования при смене домена;

В-третьих, у вас сайт ограниченного доступа и вам не нужно его попадание в поиск.

Почему роботы исполняют директивы файла robots.txt

С 1 июля 2019 года вступил в действие стандарт Интернет называемый «стандарт исключений для ботов (Robots Exclusion Protocol)». Касается этот стандарт (ранее протокол) именно файла robots.txt и его исполнения.

Поисковики Яндекс и Google этот стандарт поддерживают, а значит их алгоритмы учитывают обработку страниц сайта с учётом директив файла robots.txt.

Кстати, Яндекс и Google по-разному исполняют директивы файла robots.txt:

Приоритет файла robots.txt

Формально нет приоритета файла robots.txt перед мета-тегом noindex. Однако есть последовательность исполнения, которую нужно учитывать.

Если вы закроете раздел сайта в файле robots.txt, то поисковые боты не смогут его проскандировать, чтобы прочитать директивы noindex.

Кроме этого, для ПС Google директива noindex не только закрывает страницу (раздел, каталог) сайта от обработки, но и убирает её из индекса.

Как закрыть сайт WordPress от индексации поисковиков в файле robots.txt

Чтобы закрыть сайт от сканирования, а значит от индексации, необходимо:

В текстовом редакторе в кодировке UTF-8 создать файл с названием robots.txt;

Поместит в этот файл две строки:

Сохранить файл и по FTP залить его в корневую папку вашего сайта.

При составлении файла robots нужно помнить:

Закрыть сайт WordPress от индексации без файла robots.txt

Если у вас нет доступа к каталогу сайта, в административной панели сайта WordPress есть специальный инструмент, который называется «Видимость для поисковых систем». Находится он на вкладке Настройки>>>Чтение. Читать: Базовые настройки wordpress

Это инструмент добавит в head вашего сайта такой мета тег:

Индексация WordPress

Дата публикации: 2016-03-09

От автора: приветствую вас, друзья. В этой коротенькой и простой статье мы затронем один из многочисленных вопросов, связанных с SEO оптимизацией сайта WordPress. В частности, мы рассмотрим такой вопрос, как индексация WordPress.

На самом деле перед тем, как сесть за написание данной статьи, я сомневался, нужна ли она. Однако, как показывает практика, статья все же может дать ответ на вопрос, который нет-нет да и возникает порой у некоторых владельцев сайта WordPress.

Что же это за вопрос, связанный с индексацией WordPress? Как ни странно, но иногда от пользователей звучит он так: Почему мой сайт не появляется в поисковике? Почему поисковики не индексируют мой сайт? Они его не любят?

Чтобы ответить на такие вопросы, нужно посмотреть на сам сайт, а также уточнить, сколько времени сайт «живет» в сети. Давайте начнем с последнего момента, поскольку зачастую выясняется, что владелец сайта просто оказался нетерпелив. Думаю, вы знаете, что после того, как сайт готов и выложен в сеть, он не сразу появится в поисковике. И даже не через день или неделю. Однако, рядовые пользователи интернета этого вполне могут не знать.

Соответственно, если в ответ на вопрос, сколько сайт «живет» в сети, вы услышите что-то вроде «да вот только вчера сделали», тогда можете успокоить собеседника и объяснить ему, что процесс индексации сайта — это не быстрый и, тем более, не одномоментный процесс. В зависимости от поисковой системы сайт может появится в ней в среднем через пару месяцев. И все это при условии, что поисковому роботу сообщили о появлении нового сайта на просторах интернета.

Теперь перейдем к первому моменту, к необходимости взглянуть на сайт. Ведь владелец сайта может сказать, что его детищу уже несколько месяцев, а в результатах поиска его все нет и нет. Здесь уже стоит заглянуть в исходный код сайта, посмотреть файл robots.txt, в общем, необходим хотя бы минимальный аудит сайта.

Бесплатный курс «Основы создания тем WordPress»

Изучите курс и узнайте, как создавать мультиязычные темы с нестандартной структурой страниц

Небольшой казус из моей практики. Когда-то давно знакомый обратился ко мне со своей ситуацией: полдня, говорит, просидел в Гугле и Яндексе, добрался до сотой страницы в каждом из них, а моего сайта там нет. После недолгого общения выяснилось, что сайт он сделал сам, воспользовавшись одним из бесплатных шаблонов. Сделал он его около года назад. Никаких посторонних ссылок на сайте не размещал. В общем, было понятно, что сайт должен быть уже проиндексирован, но в поиске его действительно не оказалось.

Когда я заглянул в исходный код сайта, то практически сразу все стало понятно. В исходном коде красовалась вот такая вот строка:

Robots.txt для wordpress

Robots.txt для wordpress один из главных инструментов настройки индексации. Ранее мы говорили об ускорении и улучшении процесса индексации статей. Причем рассматривали этот вопрос так, как будто поисковый робот ничего не знает и не умеет. А мы ему должны подсказать. Для этого мы использовали карту сайта файл sitemap.xml.

Возможно вы еще не догадывается, как поисковый робот индексирует ваш сайт? По умолчанию индексировать ему разрешено всё. Но делает он это не сразу. Робот, получив сигнал о том, что нужно посетить сайт, ставит его в очередь. Поэтому индексация происходит не мгновенно по нашему требованию, а через какое-то время. Как только очередь доходит до вашего сайта, этот робот-паук тут как тут. Первым делом он ищет файл robots.txt.

Что такое файл robots.txt

Если robots.txt найден, то прочитывает все директивы, а в конце видит адрес файла sitemap.xml. Дальше робот, в соответствии с картой сайта, обходит все материалы предоставленные для индексации. Делает он это в пределах какого-то ограниченного промежутка времени. Именно поэтому, если вы создали сайт на несколько тысяч страниц и выложили его целиком, то робот просто не успеет обойти все страницы за один заход. И в индекс попадут только те, которые он успел просмотреть. А ходит робот по всему сайту и тратит на это свое время. И не факт что в первую очередь он будет просматривать именно те странички, которые вы так ждёте в результатах поиска.

Для WordPress это оказывается очень важный вопрос. Ответ на него затрагивает и ускорение индексации содержимого вашего сайта, и его безопасность. Дело в том, что всю служебную информацию индексировать не надо. А файлы WordPress вообще желательно спрятать от чужих глаз. Это уменьшит вероятность взлома вашего сайта.

WordPress создаёт очень много копий ваших статей с разными адресами, но одним и тем же содержанием. Выглядит это так:

С тегами и архивами вообще караул. К скольким тегам привязана статья, столько копий и создаётся. При редактировании статьи, сколько архивов в разные даты будет создано, столько и новых адресов с практически похожим содержанием появится. А есть ещё копии статей с адресами для каждого комментария. Это вообще просто ужас.

Огромное количество дублей поисковые системы оценивают как плохой сайт. Если все эти копии проиндексировать и предоставить в поиске то вес главной статьи размажется на все копии, что очень плохо. И не факт, что будет показана в результате поиска именно статья с главным адресом. Следовательно надо запретить индексирование всех копий.

WordPress оформляет картинки как отдельные статьи без текста. В таком виде без текста и описания они как статьи выглядят абсолютно некорректно. Следовательно нужно принять меры чтобы эти адреса не попали в индекс поисковиков.

Почему же не надо всё это индексировать?

Пять причин для запрета индексации!

Теперь после всего сказанного возникает резонный вопрос: «А можно ли как то запретить индексировать то что не надо?». Оказывается можно. Хотя бы не в приказном порядке, а в рекомендательном. Ситуация не полного запрета индексации некоторых объектов возникает из-за файла sitemap.xml, который обрабатывается после robots.txt. Получается так: robots.txt запрещает, а sitemap.xml разрешает. И всё же решить эту задачу мы можем. Как это сделать правильно сейчас и рассмотрим.

Файл robots.txt для wordpress по умолчанию динамический и реально в wordpress не существует. А генерируется только в тот момент, когда его кто-то запрашивает, будь это робот или просто посетитель. То есть если через FTP соединение вы зайдете на сайт, то в корневой папке файла robots.txt для wordpress вы там просто не найдете. А если в браузере укажите его конкретный адрес http://название_вашего_сайта/robots.txt, то на экране получите его содержимое, как будто файл существует. Содержимое этого сгенерированного файла robots.txt для wordpress будет такое:

В правилах составления файла robots.txt по умолчанию разрешено индексировать всё. Директива User-agent: * указывает на то, что все последующие команды относятся ко всем поисковым агентам ( * ). Но далее ничего не ограничивается. И как вы понимаете этого не достаточно. Мы с вами уже обсудили папок и записей, имеющих ограниченный доступ, достаточно много.

Чтобы можно было внести изменения в файл robots.txt и они там сохранились, его нужно создать в статичном постоянном виде.

Как создать robots.txt для wordpress

В любом текстовом редакторе (только ни в коем случае не используйте MS Word и ему подобные с элементами автоматического форматирования текста) создайте текстовый файл с примерным содержимым приведенным ниже и отправьте его в корневую папку вашего сайта. Изменения можно делать в зависимости от необходимости.

Только надо учитывать особенности составления файла:

Как проверить robots.txt для wordpress

Проверить robots.txt на наличие лишних пробелов можно следующим образом. В текстовом редакторе выделить весь текст, нажав кнопки Ctrl+A. Если пробелов в конце строк и в пустых строках нет, вы это заметите. А если есть выделенная пустота, то вам надо убрать пробелы и всё будет ОК.

Проверить правильно ли работают прописанные правила можно по следующим ссылкам:

Есть ещё один способ проверить файл robots.txt для сайта wordpress, это загрузить его содержимое в вебмастер яндекса или указать адрес его расположения. Если есть какие-либо ошибки вы тут же узнаете.

Правильный robots.txt для wordpress

Теперь давайте перейдем непосредственно к содержимому файла robots.txt для сайта wordpress. Какие директивы в нем должны присутствовать обязательно. Примерное содержание файла robots.txt для wordpress, учитывая его особенности приведено ниже:

Директивы файла robots.txt для wordpress

Теперь давайте рассмотрим поподробнее:

1 – 16 строки блок настроек для всех роботов

По умолчанию для индексирования разрешено всё. Это равнозначно директиве Allow: /.

В нашем примере с помощью названий папок и масок названий файлов, сделан запрет на все служебные папки вордпресса, такие как admin, themes, plugins, comments, category, tag. Если указать директиву в таком виде Disallow: /, то будет дан запрет индексирования всего сайта.

Маски к директивам файла robots.txt для wordpress

Теперь немного как создавать маски:

Приведенные выше строки вполне можно использовать в качестве рабочего файла robots.txt для wordpress. Только в 36, 38 строках необходимо вписать адрес вашего сайта и ОБЯЗАТЕЛЬНО УБРАТЬ номера строк. И у вас получится рабочий файл robots.txt для wordpress, адаптированный под любую поисковую систему.

Ещё одна маленькая рекомендация.

Если вас абсолютно не интересует Яндекс, то строки 18-35 вам не понадобятся вообще. На этом пожалуй всё. Надеюсь что статья оказалась полезной. Если есть вопросы пишите в комментариях.

Как закрыть сайт от индексации поисковых систем: 5 проверенных способов

Очень часто требуется закрыть сайт от индексации, например при его разработке, чтобы ненужная информация не попала в индекс поисковых систем или по другим причинам. При этом есть множество способов, как это можно сделать, все их мы и рассмотрим в этой статье.

Зачем сайт закрывают для индекса?

Есть несколько причин, которые заставляют вебмастеров скрывать свои проекты от поисковых роботов. Зачастую к такой процедуре они прибегают в двух случаях:

Не думайте, что если ваш ресурс только появился на свет и вы не отправили поисковикам ссылки для его индексации, то они его не заметят. Роботы помимо ссылок учитывают еще и ваши посещения через браузер.

Какие есть способы запрета индексации сайта?

1. Закрытие индексации через WordPress

Если сайт создан на базе WordPress, это ваш вариант. Скрыть проект от ботов таким образом проще и быстрее всего:

Благодаря встроенной функции, движок автоматически изменит robots.txt, откорректировав правила и отключив тем самым индексацию ресурса.

На заметку. Следует отметить, что окончательное решение, включать сайт в индекс или нет, остается за поисковиками, и ниже можно увидеть это предупреждение. Как показывает практика, с Яндексом проблем не возникает, а вот Google может продолжить индексировать документы.

2. Посредством файла robots.txt

Если у вас нет возможности проделать эту операцию в WordPress или у вас стоит другой движок сайта, удалить веб-сайт из поисковиков можно вручную. Это также реализуется несложно. Создайте обычный текстовый документ, разумеется, в формате txt, и назовите его robots.

Затем скиньте его в корневую папку своего портала, чтобы этот файл мог открываться по такому пути site.ru/robots.txt

Но сейчас он у вас пустой, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его элементы. Рассмотрим все варианты, которые вам могут пригодиться.

Закрыть сайта полностью для всех поисковых систем

Укажите в robots.txt команду:

Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt. Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы скинули файл не туда.

Отдельную папку

Так вы скроете все файлы, находящиеся в указанной папке.

Только в Яндексе

Чтобы перепроверить, получилось ли у вас удалить свой блог из Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в соответствующий раздел по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки URL вставьте несколько ссылок на документы ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах будет написано «Запрещено правилом /*?*».

Только для Google

Проверить, получилось ли сделать запрет, или нет, можно аналогичным способом, что и для Яндекса, только вам нужно будет посетить панель вебмастера Google Search Console. Если документ закрыт от поисковика, то напротив ссылки будет написано «Заблокировано по строке», и вы увидите ту самую строку, которая дала команду ботам не индексировать его.

Но с большой вероятностью вы можете увидеть «Разрешено». Здесь два варианта: либо вы что-то сделали неправильно, либо Google продолжает индексировать запрещенные в документе robots страницы. Я уже упоминал об этом выше, что для поисковых машин данный документ несет лишь рекомендационный характер, и окончательное решение по индексированию остается за ними.

Для других поисковиков

Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды. Представляем вашему вниманию самые распространенные (кроме Яндекса и Google):

Список имен всех ботов вы с легкостью найдете в интернете.

Скрыть изображения

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

Закрыть поддомен

Любой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

3. С применением тега name=”robots”

4. В настройках сервера

5. С помощью HTTP заголовка X-Robots-Tag

Мы подробно расписали как этот способ настроить и использовать в нашей статье.

Как проверить индексацию сайта и страниц?

Заключение

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.

Оцените эту статью. Чтобы мы могли делать лучший контент! Напишите в комментариях, что вам понравилось и не понравилось!

Рейтинг статьи: 5 / 5. Кол-во оценок: 10

Пока нет голосов! Будьте первым, кто оценит эту статью.