Дипфейк что это такое

Дипфейк что это такое

Дипфейки и другие поддельные видео – как защитить себя?

Дипфейки: новые технологии обмана

Слово дипфейк (Deepfake) является составным и происходит от deep learning (глубинное обучение) и fake (фейк, подделка). Глубинное обучение – это сложный метод на базе искусственного интеллекта, который использует многоуровневые алгоритмы машинного обучения для извлечения все более сложных характеристик из необработанных входных данных. При этом ИИ способен обучаться на неструктурированных данных – таких как изображения лиц. Например, ИИ может собрать данные о движениях вашего тела.

Затем эти данные могут быть обработаны для создания дипфейк-видео при помощи так называемой генеративно-состязательной сети (Generative Adversarial Network, или GAN). Это еще одна специализированная система машинного обучения. В ней задействовано две нейросети, которые состязаются друг с другом, изучая характеристики учебных наборов данных (например, фотографий лиц) и создавая новые данные на базе этих характеристик (то есть новые «фотографии»).

Поскольку такая сеть постоянно сверяет создаваемые образцы с исходным учебным набором, поддельные изображения выглядят все более и более правдоподобно. Именно поэтому угроза, которую представляют дипфейки, постоянно растет. Кроме того, сети GAN могут создавать и другие поддельные данные помимо фотографий и видео. Например, дипфейк-технологии могут использоваться для имитации голоса.

Примеры дипфейков

Качественные дипфейки с участием знаменитостей найти несложно. Один из примеров – фейковое видео, выложенное актером Джорданом Пилом. Он записал небольшую речь голосом Барака Обамы, которая затем была совмещена с видеосъемкой реального выступления этого политика. Затем Пил продемонстрировал, как выглядят обе составляющие этого видео, и призвал своих зрителей критически относиться ко всему, что они видят.

Видео с руководителем Facebook Марком Цукербергом, в котором тот якобы говорит о том, как Facebook «управляет будущим» с помощью украденных данных пользователей, появилось в Instagram. На оригинальном видео запечатлена его речь в связи со скандалом о «русском следе» в выборах президента США – для создания фейка оказалось достаточно фрагмента длиной всего в 21 секунду. Однако голос Цукерберга был сымитирован не так хорошо, как в пародии Джордана Пила на Обаму, и фальшивку было легко распознать.

Впрочем, даже менее качественные подделки могут вызвать живой отклик. Видео с «пьяной» Нэнси Пелоси, спикером Палаты представителей США, набрало миллионы просмотров на YouTube – а это был всего лишь фейк, сделанный с помощью замедления реального видео, чтобы создать видимость невнятной речи. Кроме того, немало известных женщин внезапно обнаружили себя в роли порнозвезд – их лица были вмонтированы в порнографические ролики и изображения.

Мошенничество и шантаж с использованием дипфейков

Дипфейк-видео неоднократно использовались в политических целях, а также как способ мести. Однако сейчас к этим технологиям все чаще стали прибегать для шантажа и проворачивания крупных афер.

У генерального директора британской энергетической компании мошенники смогли выманить 220 000 евро с помощью дипфейковой имитации голоса руководителя головной компании, якобы запросившего срочно перевести указанную сумму. Подмена была настолько натуралистичной, что обманутый директор не стал перепроверять информацию, хотя средства переводились не в головной офис, а на сторонний счет. Только когда «босс» запросил еще один трансфер, его собеседник заподозрил неладное, но переведенные деньги уже бесследно исчезли.

Во Франции недавно прогремела афера, в которой, правда, технология дипфейков не использовалась, – мошенник по имени Жильбер Шикли выдавал себя за министра иностранных дел Франции Жана-Ива Ле Дриана, с большой точностью воссоздав не только его внешность, но и обстановку рабочего кабинета. Аферист от имени министра обращался к состоятельным частным лицам и руководителям компаний с просьбой выделить средства на выкуп французских граждан, оказавшихся в заложниках террористов в Сирии. Таким образом ему удалось выманить несколько миллионов евро. Сейчас это дело рассматривается в суде.

Авторы дипфейков могут шантажировать руководителей крупных компаний, угрожая опубликовать фейковое видео, способное подорвать их репутацию, если те не заплатят отступные. Также мошенники могут, например, проникнуть в вашу сеть, сымитировав звонок от IT-директора и обманом заставив сотрудников предоставить пароли и привилегии доступа, после чего ваши конфиденциальные данные окажутся в полном распоряжении хакеров.

Фейковые порноролики уже использовались с целью шантажа женщин-репортеров и журналисток, как, например, произошло в Индии с Раной Айюб, которая занималась разоблачением злоупотреблений властью. Технологии производства дипфейков дешевеют, так что можно прогнозировать рост их использования в целях шантажа и мошенничества.

h2>Как защититься от дипфейков?

Проблему дипфейков уже пытаются начать решать на законодательном уровне. Так, в штате Калифорния в прошлом году было принято два закона, ограничивающих использование дипфейков: законопроект AB-602 запретил использование технологий синтеза изображений человека для изготовления порнографического контента без согласия изображаемых, а AB-730 – подделку изображений кандидатов на государственные посты в течение 60 дней перед выборами.

Но окажутся ли эти меры достаточными? К счастью, компании в сфере безопасности постоянно разрабатывают все более совершенные алгоритмы распознавания. Они анализируют видеоизображения и замечают незначительные искажения, возникающие в процессе создания фальшивки. Например, современные генераторы дипфейков моделируют двумерное лицо, а затем искажают его для встраивания в трехмерную перспективу видеоролика. По тому, куда направлен нос, легко распознать подделку.

Пока что технологии создания дипфейков еще недостаточно совершенны, и признаки подделки зачастую видны невооруженным глазом. Обращайте внимание на следующие характерные признаки:

Однако по мере совершенствования технологий ваши глаза все реже будут распознавать обман – а вот хорошее защитное решение обмануть будет куда сложнее.

Уникальные антифейковые технологии

Некоторые развивающиеся технологии уже помогают создателям видеоконтента защищать его аутентичность. С помощью специального шифровального алгоритма в видеопоток с определенными интервалами встраиваются хеши; если видео будет изменено, хеши также изменятся. Создавать цифровые сигнатуры для видео также можно, используя ИИ и блокчейн. Это похоже на защиту документов водяными знаками; в случае с видео, правда, трудности заключаются в том, что хеши должны оставаться неизменными при сжатии видеопотока различными кодеками.

Еще один способ борьбы с дипфейками – использовать программу, вставляющую в видеоконтент специальные цифровые артефакты, маскирующие группы пикселей, по которым ориентируются программы для распознавания лиц. Этот прием замедляет работу дипфейк-алгоритмов, и в результате качество подделки будет более низким, что, в свою очередь, снизит вероятность успешного использования дипфейка.

Лучшая защита – соблюдение правил безопасности

Технологии – не единственный способ защититься от дипфейк-видео. В борьбе с ними весьма эффективны даже базовые правила безопасности.

Так, например, встраивание автоматических проверок во все процессы, связанные с перечислением денежных средств, позволило бы предотвратить множество мошеннических действий, в том числе и с использованием дипфейков. Также вы можете:

Помните, что, если хакеры начнут активно использовать дипфейки для проникновения в домашние и корпоративные сети, соблюдение базовых правил кибербезопасности станет важнейшим фактором в минимизации рисков:

Как будут развиваться дипфейки?

Дипфейки эволюционируют угрожающими темпами. Еще два года назад подделки легко было отличить по низкому качеству передачи движения; кроме того, люди в таких видео практически никогда не моргали. Однако технологии не стоят на месте, и дипфейки последнего поколения выполнены заметно более качественно.

По приблизительным оценкам, сейчас по Сети гуляет более 15 000 дипфейк-видео. Некоторые из них шуточные, но есть и такие, которые создавались для манипуляций общественным сознанием. Сейчас изготовление нового дипфейка занимает от силы пару дней, так что вскоре их может стать намного больше.

6 лучших Deepfake приложений и инструментов

Различные методы манипулирования изображениями были введены в 19 веке и позднее применялись к кинофильмам. Эти методы быстро улучшились с цифровым видео.

В начале 1990-х годов исследователи из академических институтов разработали технологию Deepfake, которая впоследствии была доработана разработчиками в онлайн-сообществах. В последнее время подделки Deepfake привлекают большое внимание за их использование в финансовых махинациях, розыгрышах и фальшивых новостях.

Это заставило правительство и промышленность выявлять и ограничивать их незаконное использование. Тем не менее технология имеет большой потенциал, если ее правильно использовать.

Что такое технология Deepfake?

Deepfakes относятся к манипулируемому визуальному контенту, генерируемому сложным искусственным интеллектом, который дает сфабрикованные изображения и звуки, которые кажутся реальными. В большинстве случаев, человек в существующем видео или изображении заменяется на чье-то подобие.

Хотя трудно создать хороший deepfake на обычном компьютере, есть много инструментов, доступных в интернете, чтобы помочь людям сделать достойные deepfakes. Технология все еще находится в зачаточном состоянии, поэтому не ожидайте идеального результата.

Мы тщательно собрали несколько хороших deepfake приложений и инструментов, которые не требуют высокого класса рабочего стола с мощными графическими картами (за исключением одного или двух). Вы можете использовать их как в исследовательских целях, так и просто для развлечения, но не нарушайте чью-либо частную жизнь.

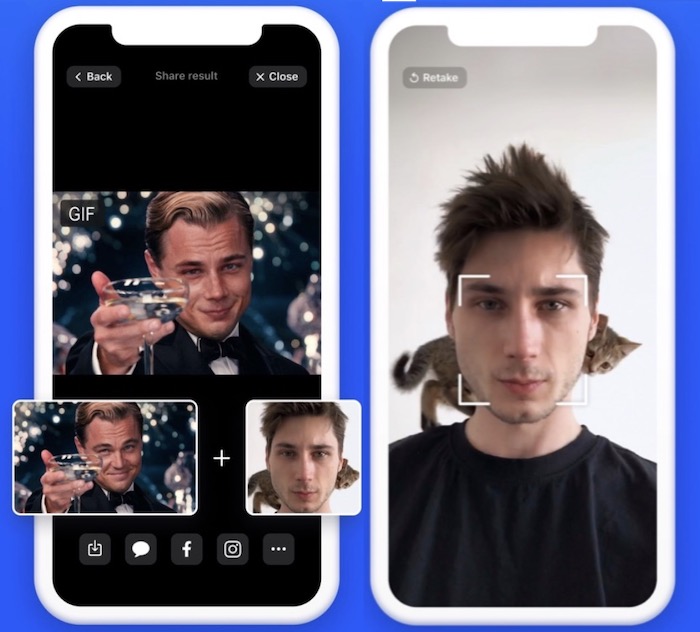

6. Doublicat

Платформа: Android / iOS

Цена: Бесплатно

Doublicat позволяет вам сделать селфи и поместить свое лицо на мем или GIF в своей библиотеке. Это займет около 5 секунд, чтобы ваше лицо было наложено на лицо Брэда Питта, Леонардо Ди Каприо или Тейлора Свифта.

Вы будете удивлены, увидев, насколько хорошо ваше наложенное лицо принимает те же выражения, что и оригинал. Вы можете переслать результаты своей семье и друзьям или опубликовать их в Instagram.

Вывод будет довольно странным, если будет много движений лица, но в целом это интересный эксперимент. По словам разработчиков приложения, само изображение удаляется с серверов сразу после его обработки. Однако при этом сохраняется представление черт лица.

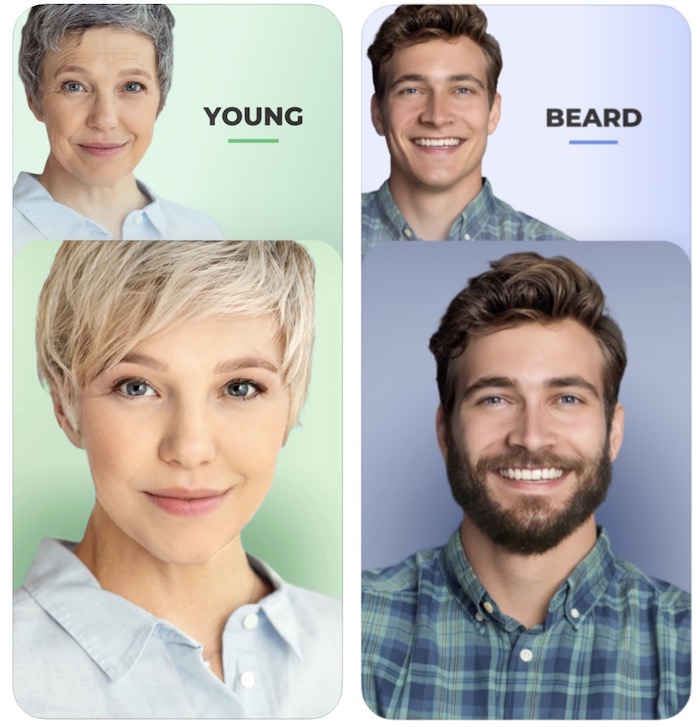

5. FaceApp

Платформа: Android / iOS

Цена: Бесплатно

FaceApp разработан российской компанией Wireless Lab. Он использует нейронные сети для генерации высокореалистичных преобразований лиц на фотографиях.

Приложение может преобразить ваше лицо, чтобы заставить его улыбаться, выглядеть старше, выглядеть моложе или просто смены пола, а также многих других захватывающих преобразований. Татуировки, виньетки, размытие объектива и наложение фона также являются частью FaceApp.

В 2018 году приложение привлекло много внимания со стороны трансгендерных и ЛГБТ-сообществ из-за его реалистичных преобразований гендерных изменений. Он также столкнулся с критикой как в социальных сетях, так и в прессе за конфиденциальность пользовательских данных.

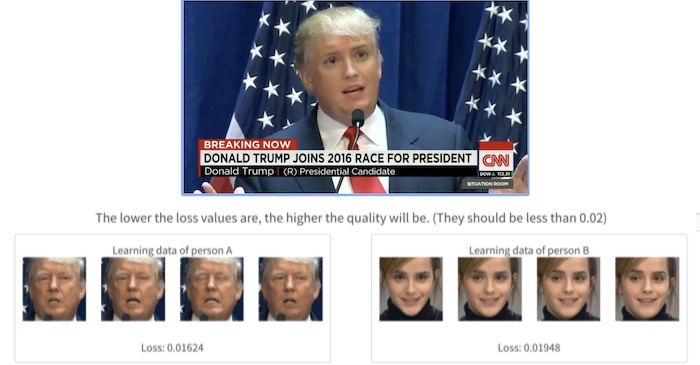

4. Deepfakes web β

С помощью этого инструмента вы можете создавать deepfake видео в интернете. Однако кривая обучения здесь немного больше, чем то, что вы найдете в других приложениях.

Вам нужно зарегистрироваться и загрузить свои видео. Все остальное происходит в облаке, где используются мощные графические процессоры. На изучение видео/изображений и смену лиц уходит почти 4 часа. Вы также можете использовать обученную модель, чтобы менять лица, что занимает около 30 минут.

Качество выходного видео зависит от значений «потерь»: чем ниже значения потерь (при обучении из загруженных видео), тем выше качество. И, конечно, только вы можете получить доступ к своим видео и учебным данным.

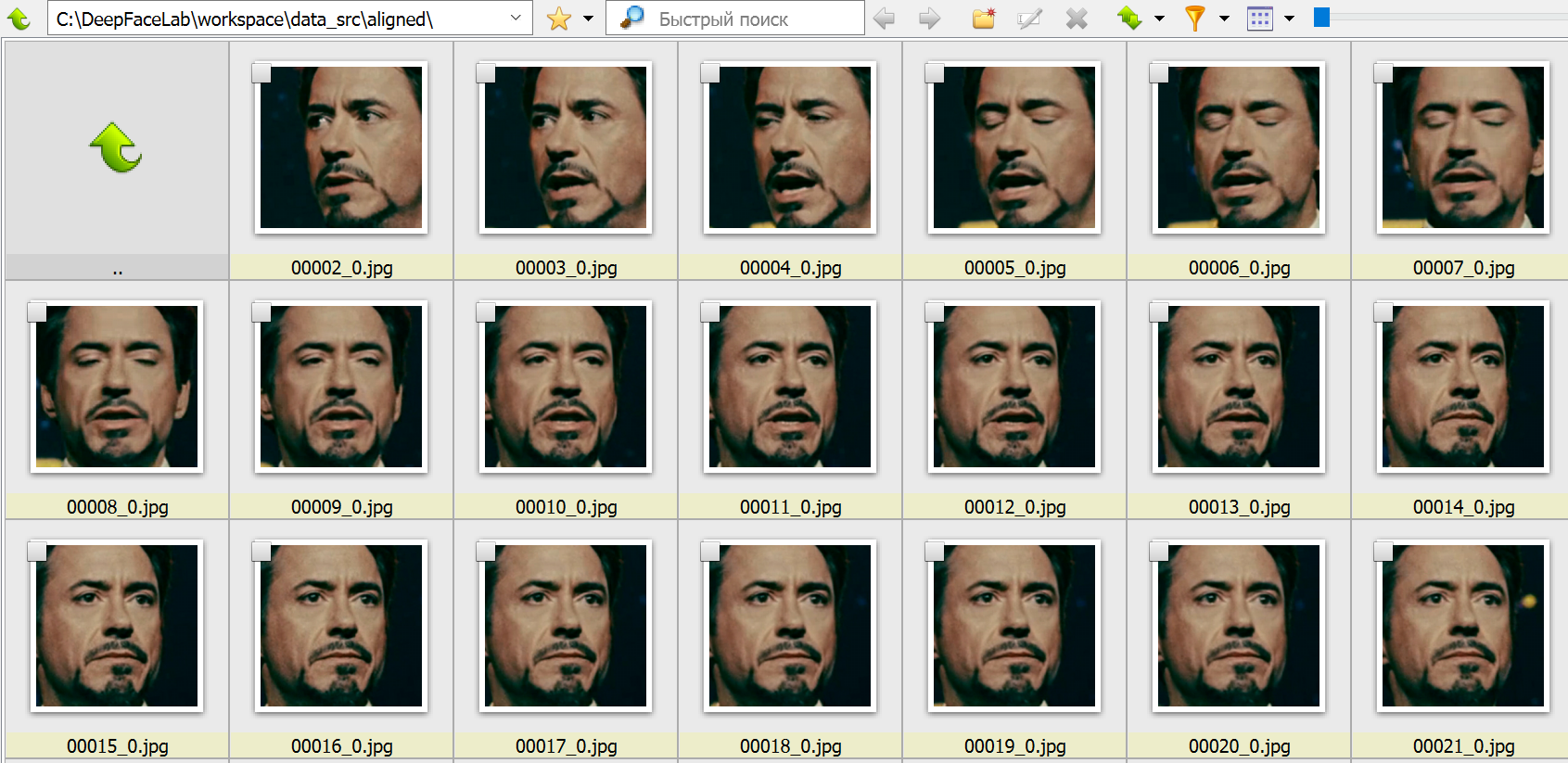

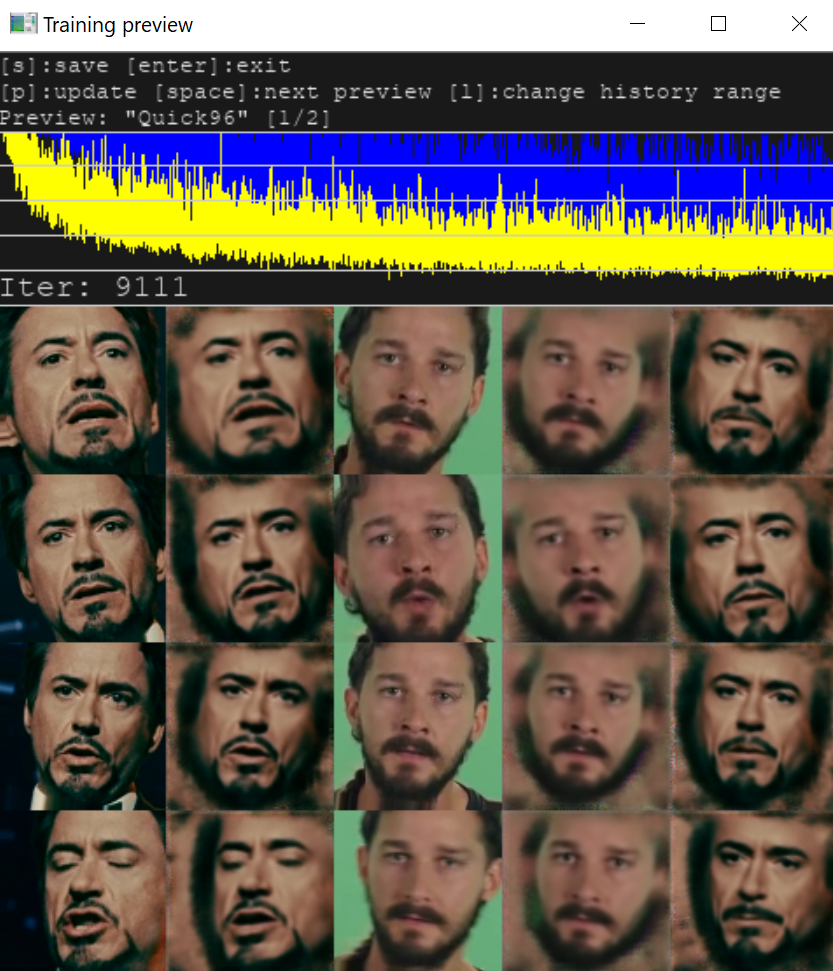

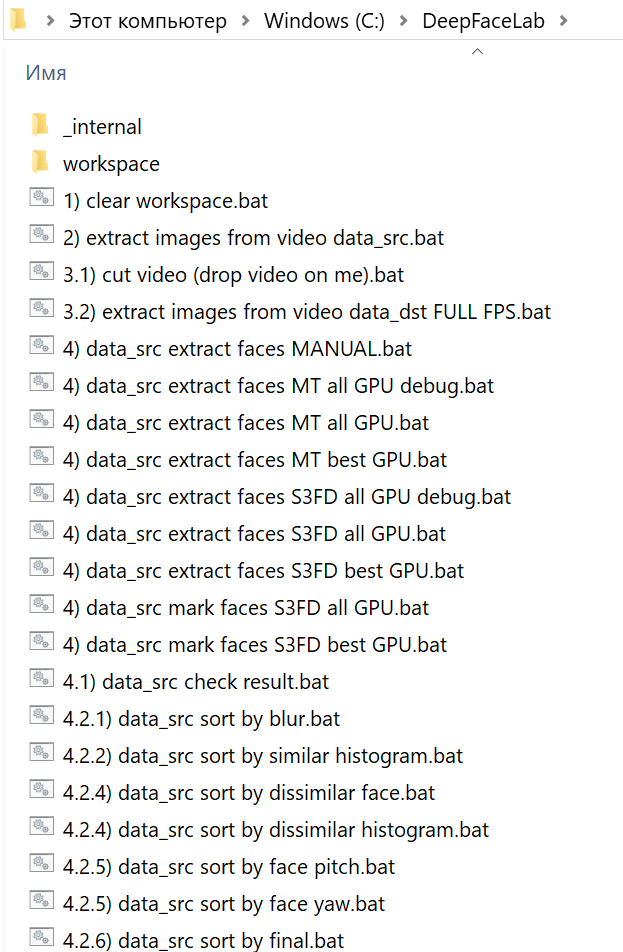

3. DeepFaceLab

Платформа: Windows

Цена: Бесплатный

DeepFaceLab является ведущим программным обеспечением для создания подделок. Она использует новые нейронные сети для замены лиц в видео. Она размещена на GitHub и породила бесчисленное множество видео в интернете.

По словам его разработчиков, более 95% глубоких подделок видео создаются с помощью DeepFaceLab. Его используют несколько популярных каналов YouTube, таких, как Ctrl Shift Face, iFake и Shamook.

DeepFaceLab прекрасно работает, но для его использования необходимы технические знания. Как только вы загрузите и разархивируете инструмент, вы увидите множество папок и ряд командных файлов. Существует папка с именем «workspace», которая содержит все обучающие модели, исходные видео и выходные данные. Инструмент работает с определенными именами и местоположениями файлов, чтобы пакетный файл мог функционировать.

2. FaceSwap

Платформа: Windows | MacOS | Linux

Цена: бесплатно

FaceSwap похож на DeepFaceLab, но предоставляет больше возможностей, лучшую документацию и лучшую онлайн-поддержку. И да, он также доступен на Mac и Linux.

Это инструмент с открытым исходным кодом, наполненный функциональностью для выполнения каждого шага процесса Deepfake, от импорта первоначального видео до создания финального видео Deepfake. Чтобы запустить этот инструмент, вам нужна мощная видеокарта, так как замена лица происходит невероятно медленно.

Работая на Python, Keras и Tensorflow, Faceswap имеет активное сообщество, поддерживающее и разрабатывающее программное обеспечение. Есть много учебников, которые помогут вам начать работу.

1. Zao

Платформа: Android | iOS

Цена: бесплатно

Технология глубокой подделки Zao позволяет вам модулировать голоса знаменитостей и накладывать свое лицо на тело актера в сцене.

Просто нажмите на одну фотографию и попробуйте тысячи модных причесок, одежды и макияжа. Приложение предоставляет вам множество видеоклипов, нарядов и буквально неограниченные возможности для изучения.

В 2019 году Zao за короткое время приобрел значительную популярность, позволив пользователям обмениваться лицами с любимыми актерами в коротких клипах из телепередач и фильмов. За месяц он стал самым загружаемым бесплатным приложением в Китае. С ростом популярности, его разработчики также столкнулись с критикой политики конфиденциальности приложения.

Это займет всего несколько секунд, чтобы поменять ваше лицо, но так как алгоритм в основном обучен на китайских лицах, это может выглядеть не так естественно, как вы ожидаете.

Тем не менее все эти инструменты демонстрируют, как быстро развивался базовый ИИ: то, что раньше требовало тысячи картинок, чтобы сделать достаточно убедительное глубокое поддельное видео, теперь требует только одного изображения и дает лучшие результаты.

Дипфейки: кому и зачем они нужны

Дипфейк (deepfake) – производная от «глубокого обучения» и «подделки»; штука, про которую сегодня большинство говорит с опаской. Само название как бы кричит: «Я зло!». А наша гипотеза в том, что это технология с огромнейшим позитивным потенциалом, которая пока используется в основном как игрушка в руках неразумного человека. Что это и как на самом деле? Давайте разбираться.

Дипфейки используют технологии искусственного интеллекта для синтеза изображений, в результате чего один персонаж как бы накладывается на другого и получается «комбо»: оживает Мона Лиза или Терминатором становится Бред Питт.

Эта технология позволяет легко манипулировать аудио- и видеоконтентом, а по мере того, как она развивается, разобраться, где правда, а где фейк – становится всё сложнее. Так в прогремевшем на весь интернет видео Барак Обама критикует Дональда Трампа, называя его «полным провалом». В США считается, что дипфейки представляют угрозу национальной безопасности. В Калифорнии некоторые виды дипфейков даже запретили законодательно.

Чаще всего дипфейки создаются с помощью генеративно-состязательной сети (GAN), в ней 2 системы: генератор и дискриминатор. Они работают как пара студентов в университетской микрогруппе: один предлагает идеи, другой их критикует. Генератор создаёт изображения, а обученный на реальных фотографиях дискриминатор подсказывает, что нужно исправить.

Заметим, что технология постоянно развивается. Так, например, алгоритм BigGAN от Google и NVIDIA позволяет не просто воссоздавать, а создавать лица несуществующих людей, которые невозможно отличить от настоящих.

Недавно разработчики из Samsung и Сколково представили алгоритм на основе BigGAN, который позволил «оживить» Мону Лизу, то есть для (относительно) хорошего результата нейросети достаточно одного кадра. Нейросеть работает лучше всего, если дать ей несколько изображений человека, снятых под разными углами.

Сейчас на рынке десятки приложений, с помощью которых любой может сделать дипфейк, самые известные – Zao, DeepFaceLab, Deepfakes web β.

Конкурентные преимущества приложений похожи на классический треугольник «цена-качество-скорость»:

– Скорость. Одни выполняют конверсию за секунды, другим нужны часы.

– Необходимое количество исходного материала. Некоторым достаточно одной фотографии.

– Точность итогового результата. Обычно чем больше исходного материала и дольше идёт процесс анализа, тем точнее получается результат.

Год назад NVIDIA представила нейросеть, которая может превращать скетчи в реальные изображения. Технологию назвали GauGAN в честь Поля Гогена. Такую штуку можно использовать в архитектуре, дизайне, создании игр, да где угодно.

Технологию, которая лежит в основе дипфейков, можно использовать и в киноиндустрии, рекламе или при реконструкции исторических событий. Например, с её помощью была сделана социальная реклама, в которой Дэвит Бэкхем рассказывает об опасности малярии на 9и языках.

Музей Сальвадора Дали во Флориде «оживил» художника с помощью всё той же технологии. В результате зрители могли пообщаться с Дали, послушать его истории и даже получить совместное селфи. Для этого потребовалось 6000 фотографий Дали, 1000 часов машинного обучения и 145 видео с актером похожих пропорций, а ещё горы интервью и писем художника, чтобы воспроизвести голос, акцент и манеру речи.

Кстати, алгоритм GAN предлагается использовать и в астрофизике для того, чтобы избавляться от помех и шумов при съёмке космических объектов и получать качественные изображения.

Если вы тоже считаете, что человеческий интеллект создан для творчества, а машинный – для работы, присоединяйтесь к нам на YouTube или в Facebook!

Deepfake: краткая история появления и нюансы работы технологии

Немного истории

Технологии синтезирования видео и аудио нельзя назвать новыми. Они разрабатываются с конца 90-х годов XX века. Конечно, разные попытки делались и до этого, но мы говорим о тех технологиях, которые получили продолжение. Так, в 1997 году компания Video Rewrite представила технологию, которая позволяла сформировать видео, где артикуляция лица совпадала с синтезированной аудиодорожкой. Т.е. моделировалась артикуляционная мимика лица, которая полностью соответствовала синтезированной компьютером аудиодорожкой.

Но это были лишь первые попытки, которые активно развивались в течение двух десятков лет. Сейчас нам доступны технологии обработки голоса, объединения компьютерной графики с реальными видео и многое другое. Не везде применяется ИИ, но все же самые реалистичные системы сформированы на базе машинного обучения.

Появление «настоящих» дипфейков

Технология Deepfake упрощает процесс синтезирования изображения и создания звуковых дорожек с заданными параметрами за счет использования нейронных сетей. Они обучаются на сотнях или даже тысячах примеров лиц и голосов, с ними связанными. После этого ИИ показывает весьма впечатляющие результаты.

Нет сомнения, что с течением времени будут появляться все более реалистичные дипфейки. Уже сейчас они никого не удивляют, а в ближайшем будущем и вовсе станут привычным делом. Но кто отвечает за развитие технологий, где они используются, как работают и чего нам ожидать в будущем?

Современные игроки

Большинство крупнейших технологических игроков и развлекательных компаний активно исследуют отрасль «синтетических медиа». Amazon стремится сделать голос Алексы более реалистичным, Disney изучает, как использовать технологию смены лица в фильмах, а производители оборудования, такие как Nvidia, расширяют границы синтетических аватаров, а также услуг для кинопроизводства и телевидения.

Но есть и организации, которые создают технологии, позволяющие отличить подделку от реальности. В их число входят, например, Microsoft и DARPA.

К слову, у большинства ПО по созданию дипфейков открытый исходный код, что дает возможность работать с дипфейками даже небольшим компаниям. Проектов достаточно много. Это, например, Wombo, Аvatarify, FaceApp, Reface, MyHeritage и многие другие.

Как создаются дипфейки

Классическая компьютерная обработка изображений использует сложные алгоритмы, созданные при помощи традиционного программного обеспечения. Эти алгоритмы чрезвычайно сложны. Как говорилось выше, совсем недавно дипфейки представляли собой контролируемую модель, которой управляют разработчики. Подавляющее большинство элементом артикуляционной мимики жестко прописывалось в алгоритмах.

Правда, для того, чтобы создать убедительный дипфейк, требуются большие объемы видео, статические изображения, голосовые записи, а иногда даже сканирование головы реального актера с последующим анализом в качестве обучающих вводных данных. Например, клиенты Synthesia в течение примерно 40 минут снимают на видео, как они зачитывают заранее подготовленную речь, чтобы потом этот контент использовался для обучения нейронными сетями.

Несмотря на весьма впечатляющие результаты, дипфейки, создаваемые ИИ, не являются идеальными. У дипфейков есть ряд хорошо заметных (не для человека, для специализированного ПО) признаков, которые пока еще позволяют отличить реальность от вымысла. Это, например, нюансы освещения и теней, мигание, артикуляция, выражение и тон голоса. Для создания убедительного дипфейка все это нужно правильно комбинировать.

Изображения и видео

Достаточно часть в этом направлении используется Variational Autoencoder – VAE. Это генеративная модель, которая находит применение во многих областях исследований: от генерации новых человеческих лиц до создания полностью искусственной музыки. Что касается видео, то VAE позволяет достаточно быстро перенести особенности мимики и артикуляции определенного человека на сформированную объемную модель. VAE используется достаточно давно, но дипфейк, созданный при помощи этой технологии, несложно выявить.

А вот с 2017 года развиваются генеративные состязательные сети (GAN). Здесь в единое целое объединены, по сути, две нейронные сети. Одна, «дискриминатор», определяет реалистичность модели, созданной другой нейросетью. На выходе получается модель, которая была «одобрена» и является наиболее реалистичной.

Что дальше?

Дипфейки также поднимают множество вопросов о том, кому какой контент принадлежит, что делать с лицензиями и как наказывать нарушителей. Так, уже сейчас актеры заключают контракты с компаниями, разрешая использовать их образ и голос в рекламе или фильмах. Но, вероятно, некоторые компании будут использовать дипфейки знаменитостей в своих целях без всяких разрешений.

Как делают deepfake-видео и почему лучше говорить «face swap»

Рассказываем о работе технологии face swap, создании известных сегодня deepfake-видео, как трансфер лиц поможет медиарынку и в каком направлении развивается эта область машинного обучения.

Каждый день из многочисленных Telegram-каналов, изданий об ИТ прилетают новости о создании алгоритмов, работающих над преобразованием контента.

Недавно компания Тимура Бекмамбетова и разработчики робота «Вера» придумали технологию синтеза голосов знаменитостей. Учёные из МФТИ научили компьютер воспроизводить изображения, которые видит человек в данный момент, а компания OpenAI создала алгоритм, пишущий почти осмысленный текст на основе минимальных исходных данных.

Нейросети оперируют и видеоконтентом: генерируют движущиеся пейзажи, убирают объекты или же заставляют танцевать людей на фото.

Сложнее обстоят дела с трансфером человеческих лиц или тел на изображениях. Эту сферу начинают осваивать стартапы, которые создают продукты для оптимизации процессов производства контента: Dowell (проект компании Everypixel Group, Россия), Synthesia (Великобритания), а также RefaceAI — создатели приложений Doublicat и Reflect (Украина).

Есть несколько сервисов вроде Reflect, Doublicat или Morhine, которые работают в реальном времени со статичным форматами или GIF. Недавно китайские разработчики зашли на поле видеоформата и выпустили приложение Zao, которое встраивает лица пользователей в известные фильмы.

В остальном широкая аудитория остаётся непричастной к созданию такого контента и потребляет deepfake-видео, которые выпускают известные продакшн-студии или свободные художники на YouTube.

Существуют разные архитектуры алгоритмов, которые переносят лица с видео на видео. Мы расскажем о нескольких самых распространённых.

Метод перемещения лица, в основе которого — кодировщик и декодировщик. Работает это так:

Один из распространённых кодов для переноса лиц таким методом написал российский разработчик-энтузиаст Иван Перов. В его репозитории DeepFaceLab на GitHub есть подробнейшие руководства с комментариями, системные требования к оборудованию и программному обеспечению и даже видеоинструкция.

В подходе с использованием этого метода улучшить результат можно только вручную, корректируя базы данных перед обучением или на постпродакшене.

Поэтому всё чаще в архитектуру с кодировщиком и декодировщиком вплетаются генеративно-состязательные сети. Их суть заключается в соревновании генератора и дискриминатора (отсюда — GAN, Generative Adversarial Network, генеративно-состязательная сеть).

Генераторы учатся создавать наиболее реалистичную картинку, дискриминаторы — определять, какая из них сгенерированная, а какая оригинальная. По мере того как генераторы обучаются обманывать дискриминатор, изображение получается всё более реалистичным.

Таким образом, кодировщик и декодировщик отвечают за перенос изображения, а дискриминатор от генеративных сетей — за улучшение результата. По этой логике работает архитектура Face Swap GAN, созданная японским разработчиком Shaoanlu.

Ещё один подход — архитектуры с использованием нескольких генеративно-состязательных сетей. Каждая сеть отвечает за свою операцию, что сводит к минимуму количество этапов с применением ручного труда.

Чтобы обучить такую нейросеть, требуется несколько суток и мощный кластер видеокарт. Несмотря на это, такой подход является наиболее перспективным, потому что даёт лучший результат.

Одно из решений, созданных по этой технологии, — FSGAN, которое в скором времени обещает опубликовать в открытом доступе его создатель, израильский исследователь Юваль Ниркин.

Здесь одна нейросеть учится подгонять лицо донора под параметры целевого видео (поворот головы, наклон вбок или вперёд), вторая переносит черты лица, а третья делает image blending (слияние изображений), чтобы картинка была более реалистичной, без разрывов или артефактов.

Сегодня перенос лиц, если он выполняется исключительно алгоритмами, всё ещё заметен человеческом глазу: выдают либо визуальные артефакты, например мимика или положение глаз, либо непохожесть нового лица ни на реципиента, ни на донора — в результате получается третья сущность.

Гладкий трансфер лиц всё ещё обеспечивают не нейросети, а навыки в CGI (многие широко известные сегодня создатели deepfake-видео вроде Corridor Crew и Ctrl Shift Face правят работу алгоритмов вручную на постпродакшене или же совершают манипуляции перед самим обучением).

Как правится контент до или после обучения нейросети, нам рассказал моушн-дизайнер студии Clan Андрей Чаушеску, который несколько месяцев назад создал нашумевший в России ролик с актёром Михаилом Ефремовым в трейлере фильма «Ангелы Чарли».

Недавно он опубликовал новую работу, поместив в фильм «Великий Гэтсби» изображение актёра Сергея Бурунова, который обычно озвучивает Леонардо Ди Каприо в русском дубляже. Свои проекты Андрей делает в программе DeepFaceLab, поэтому мы будем говорить о правках, которые требуются для работы именно с этим алгоритмом.

На этапе препродакшена проводится работа с данными перед началом обучения нейросети. Когда два видео разложены на наборы кадров, нужно отсмотреть эти базы и обратить внимание на несколько моментов.

Во-первых, не все люди могут обменяться друг с другом лицами незаметно. Сегодня переносимая алгоритмами область — от бровей до подбородка и от уха до уха (то есть уши, лоб и волосы остаются в целевом видео родными). Поэтому на схожесть результата влияют влияют пол, возраст, цвет кожи и волос, а также комплекция и форма лица.

Некоторые студии, делая поддельные видео с известными артистами, ищут максимально похожих на них людей: ребята из Corridor нашли человека, очень похожего на Тома Круза, а актёр, играющий в ролике с Киану Ривзом, надел чёрный парик, чтобы воссоздать образ актера.

Ctrl Shift Face недавно выпустил три ролика с разными актёрами в одной сцене из фильма «Старикам здесь не место». Лучше всего получился Арнольд Шварценеггер, так как форма его головы больше всего подходит под форму актёра Хавьера Бардема, в отличие от Дефо и Ди Каприо.

Во-вторых, если в донорском видео лицо всегда анфас, а в целевом голова поворачивается и виден профиль, алгоритм не перенесёт лицо корректно, потому что не знает, как выглядит человек в профиль. Так же обстоят дела с положением глаз, движением губ, мимикой и эмоциями (смех или плач): оба человека должны побывать в максимально совпадающем диапазоне ситуаций.

Часто нейросеть некорректно распознаёт глаза. Конечно, больше пользы принесёт подбор фотографий с нужным положением глаз, хорошо считываемой мимикой, но «обман» нейросети тоже может дать хороший результат.

После обучения то, что не углядели в начале, и то, в чём оказался бессилен алгоритм, докрашивается на постпродакшене. В ролике с Сергеем Буруновым Андрею пришлось столкнуться с проблемой разной формы лица двух актеров, которую он решал уже на завершающем этапе.

Самый быстрый способ сделать поддельный ролик — наложить лицо, не выходя за рамки головы человека с целевого видео (в данном случае — Ди Каприо). Лицо Бурунова шире, и, как мне кажется, сходство терялось, поэтому приходилось вручную масками прорисовывать его овал.

Основная программа, которой я пользуюсь на постпродакшене, — Adobe After Effects. Я делаю цветокоррекцию, добавляю размытие для имитации движения камеры и шум для эффекта кинопленки.

Отдельная история — работа с изображениями, в которых перед лицом есть искажающая преграда: скафандр, искривлённое зеркало или очки. Тут единственный выход — ПО вроде After Effects, Cinema 4D.

В них вручную создаётся текстура материала, которая затем ставится перед лицом, чтобы выглядело, как в оригинале. Из-за таких ограничений часто бывает, что очень классные сцены фильмов сложно использовать в deepfake-роликах.

Для YouTube-формата, когда каждый вышедший ролик становится информационным поводом и предполагает вау-реакцию аудитории, такой подход применим. Видео можно долго шлифовать, а потом ещё отдельно описывать процесс, как это часто делают в Corridor Crew.

Очевидно, рынок сервисов для пользователей не предполагает какой-либо постпродакшн: результат нужен сейчас. Того же хочет и профессиональная индустрия (кино и реклама), которая руками переносить лица уже умеет, но сейчас фокусируется на удешевлении и автоматизации процесса.

Монетизируется технология face swap по двум стандартным моделям. Для b2c-аудитории создаются развлекательные приложения вроде Zao или Doublicat. Для b2b-аудитории — продукты, которые используются для оптимизации продакшена, маркетинговых коммуникаций, персонализации брендированного контента или в игровой индустрии.

Среди них Dowell и RefaceAI, создатели которых рассказали, по какой логике работает их продукт и какую нишу на рынке они планируют освоить.

Dowell вырос в офисе компании Everypixel Group, которая занимается производством контента и создаёт продукты на основе искусственного интеллекта. Изучив рынок, создатели стартапа поняли, что развитие продуктов для пользователей и демонстрация deppfake-публикаций на YouTube не их путь, и проработали сценарии использования в киноиндустрии и маркетинге.

Один из кейсов они реализовали с BBDO — рекламный ролик с изображением генерального директора крупного автомобильного бренда, в съёмках которого этот человек не принимал непосредственного участия.

Жизненный цикл сервисов, которые позволяют заменять лица, ограничен: пользователи не будут заходить туда каждый день. Это инструмент, который позволяет «пошуметь», рассказать о себе, оседлать волну хайпа. Но мы решили сосредоточиться на решении бизнес-задач.

Во-первых, это маркетинговая коммуникация брендов с аудиторией. Мы создаём персонализированный контент и с помощью видео помогаем обрести их клиентам пользовательский опыт перед покупкой.

Во-вторых, решаем проблему увеличения доходности агентств, работающих со звёздами, их клиентов. Представьте, что Джордж Клуни одновременно снимается в голливудском фильме, рекламном ролике Nespresso и проводит презентацию нового Mercedes в Штутгарте.

В таком формате доступ к «телу» звёзд появится у тех брендов и организаций (вроде благотворительных фондов), которые никогда не могли себе позволить пригласить звезду живьём.

На старте разработки продукта изучение алгоритмов, находящихся в открытом доступе, помогло нам понять логику работы, увидеть слабые места, но зависеть от чужого кода — тупиковый путь. Это чёрный ящик, содержание которого слабо можно представить, результат будет непредсказуемым.

В процессе собственных разработок мы одновременно проводили несколько исследований. Во-первых, искали влияние одних признаков и черт лица на другие, чтобы ими можно было управлять независимо друг от друга, по отдельности переносить глаза, нос, форму лица и губы.

Во-вторых, мы разделяем персону (черты лица) и контент (условия, в которой лицо появляется: свет, сюжет, эмоции), после чего можем взять персону и поместить её в те условия, которые нам нужны.

Чем страдают все открытые алгоритмы, так это маленьким разрешением переносимой области — 256 на 256 пикселей. Продакшн-студии работают с более качественными изображениями, и здесь мы задались целью увеличить область до стороны в 1024 пикселей.

Проблему можно решить, обучив нейросеть наращивать разрешение с 256 до 1024 пикселей и с помощью дискриминатора оценивать, насколько хорошо это получилось сделать. По такому же принципу можно «деблюрить» изображения, делая из размытых чёткие.

Дипфейки: что это такое, зачем и кому они нужны + 13 кейсов

Том Круз решил «побаловать себя»: ест чупа-чупс, находит в нем жвачку и удивляется. Все это, естественно, практически в прямом эфире. Звезды все ближе к обычным людям! Или нет? Нет, это всего лишь deepfake-версия Тома Круза, но сходство впечатляющее, правда?

В этой статье рассказываем о том, что такое дипфейки, как их создают, чем они опасны, а также делимся кейсами их использования не только в формате шуточных видео, но и в «серьезном» маркетинге.

Что такое дипфейки

В начале 2021 года TikTok-видео с участием Тома Круза и правда набрали популярность. Поражают и внешнее сходство дипфейка с актером, и то, как точно передан его знаменитый смех. Этого «Тома Круза» создал Крис Уме, бельгийский специалист по deepfake-эффектам.

Deepfake (deep learning, «глубокое обучение» + fake «фейк, подделка) — методика синтеза изображения, основанная на искусственном интеллекте. Она используется для соединения и наложения существующих изображений и видео на исходные изображения или видеоролики.

В создании дипфейков участвуют GAN — генеративно-состязательные сети. Генеративная часть алгоритма, обучаясь на существующих фото, создает изображение. А состязательная — буквально «соревнуется» с первой частью алгоритма, стараясь отличить настоящие изображения от ненастоящих. В процессе этого соревнования и создаются дипфейки — изображения и видео, которые действительно трудно отличить от реальных, созданных человеком.

Даниил Охлопков, Data Lead в Runa Capital: «Сгенерированные изображения и видео со временем станут реалистичнее. Будет меньше видимых артефактов — следов того, что изображение было сгенерировано нейронной сетью.

Обратите внимание, на первой картинке слева появился перевернутый рот, на второй смазаны зубы. Аналогичные неточности (артефакты) можно находить и на видео с дипфейками.

Сейчас для создания фотореалистичного deepfake необходима постобработка. Это наглядно показали создатели видео, где актер Том Круз баллотируется в президенты США.»

На мой взгляд, технологию ожидает бумообразный рост в ближайшие несколько лет. Нынешний уровень развития технологии и ее перспективы стимулируют интерес, а значит, все больше разработчиков будут применять и использовать ее для решения своих задач. Решения будут все доступнее, дешевле и при этом качественнее.

На развитие будет сильно влиять то, как эта технология воспримется законодательно.

С одной стороны, все понимают, что мировую эволюцию deepfake не сдержать силами государства в отдельных странах.

С другой, это одна из наиболее опасных технологий в рамках текущей парадигмы безопасности, которая поддерживает мнение о том, что биометрия — отличный способ идентифицировать человека.

Григорий Иванов, основатель группы компаний Neutronix

Опасность технологии

У дипфейков практически безграничные возможности: с их помощью можно «заставить» кого угодно говорить и делать что угодно. В 2018 году режиссер Джордан Пил создал видео, на котором Барак Обама говорит об опасности дипфейков и fake news (фальшивые новости) в целом:

«It may sound basic, but how we move forward in the age of information is going to be the difference between whether we survive or whether we become some kind of fucked-up dystopia».

«Это прозвучит банально, но пока мы на пути к веку информации, главный вопрос для нас — сможем ли мы выжить, или мир превратится в какую-то извращенную антиутопию».

На видео Обама ругает Трампа, не стесняясь выражений, и очень легко поверить в то, что это действительно бывший президент США. Видео было создано, чтобы предупредить пользователей об опасности дипфейков, а также призвать их не верить всему, что они видят.

Кроме того, дипфейки могут «помочь» развитию мошенничества в интернете или даже по телефону. В 2019 году CEO британской энергетической компании заплатил мошенникам 220 тыс. евро, потому что думал, что об этом попросил его босс, голос которого в телефонном разговоре сгенерировали киберпреступники.

В связи с этими проблемами появились программы и гранты для тех, кто создаст лучший детектор дипфейков.

Facebook активно занимается изучением дипфейков и способов им противостоять. В созданном компанией Deepfake Detection Challenge поучаствовали более 2 тыс. специалистов. Благодаря этому челленджу у AI-исследователей появятся новые методы для распознавания дипфейков, которые несут угрозу обществу.

В России на похожее исследование было выделено почти 5 млн р.

Даниил Охлопков, Data Lead в Runa Capital

«Хорошие» кейсы

Дипфейки сами по себе не опасны. Есть и хорошие кейсы использования deepfake-технологий.

Например, дипфейки могут помогать людям. У Microsoft есть приложение Seeing.AI для слепых и слабовидящих людей: cинтезированный голос комментирует все, что происходит вокруг человека с нарушениями зрения, помогая ему ориентироваться в мире

Дипфейки можно применять в образовании. WPP — британский международный холдинг в области коммуникаций, рекламы, связей с общественностью, технологий и торговли. Во время пандемии COVID-19 этой компании понадобилась программа для корпоративного обучения. Это было как раз в разгар локдауна, поэтому сделать видео с реальными спикерами было невозможно.

WPP обратилась к Synthesia, компании, специализирующейся на AI, и те создали для них обучающую программу, где в качестве лекторов выступают deepfake-аватары.

Дипфейки используются и в искусстве. Специалисты из Сколково и Samsung «оживили» Мону Лизу:

Кстати, при создании «Форсаж-7» тоже использовались deepfake-технологии. Получается, в теории они могут помочь решить проблему с дублерами и удешевить производство видеоконтента.

Представьте, как много рекламного и промо-контента можно генерировать даже без участия реальных знаменитостей. Может, в будущем они будут просто продавать свои образы, а студии получат возможность делать невероятный, но очень реалистичный контент. Меньше времени на съемку, возможность участвовать сразу в нескольких проектах одновременно вообще не выходя из дома. Все это — потенциально огромные рекламные контракты.

Юлия Плосконосова, аккаунт-директор Mailfit

Применение в маркетинге и рекламе

Можно ли применять deepfake-технологии в рекламе? Да! Ниже — несколько успешных кейсов, которые могут послужить референсами для ваших рекламных кампаний.

Vivienne Sabo

Бренд косметики — один из российских пионеров применения deepfake-технологий. В 2020 году компания запустила рекламный видеопроект с использованием технологии замены лиц.

На сцене кабаре мог оказаться каждый. Достаточно было загрузить свое фото на специальном лендинге или в приложении на базе Vk Mini Apps и получить видео. Кампания уже завершена, так что сделать видео больше нельзя.

Технология дополненной реальности позволяет покупателю примерить одежду, обувь, бижутерию, попробовать макияж виртуально. Deepfake-технология способна сделать то же самое. В отличие от AR, она показывает не просто то, подходит ли вещь, а как сам человек выглядит с ней со стороны.

Алексей Рыбаков, генеральный директор IT-компании Omega

Clarins

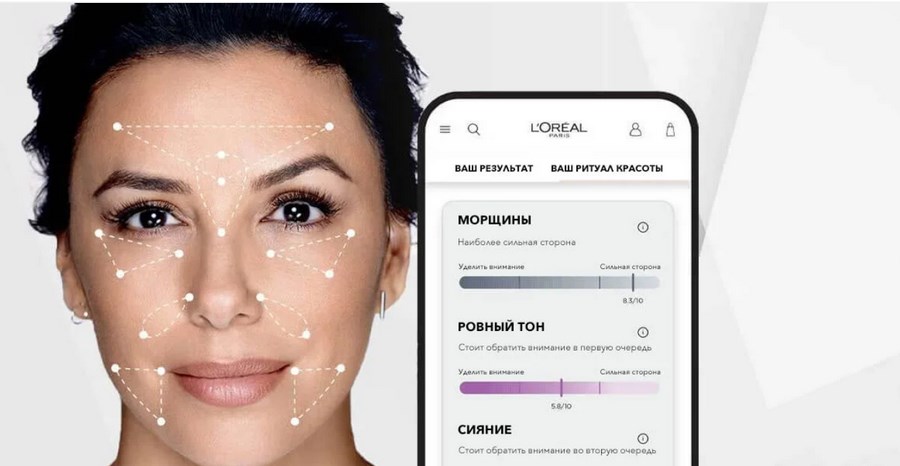

Этот бренд косметики тоже предлагает примерить макияж не выходя из дома. Нужно всего лишь перейти на страницу средства в интернет-магазине и нажать кнопку «Макияж онлайн». Можно загрузить фото из галереи телефона или снять новое. Примерять можно средства для лица, глаз и губ.

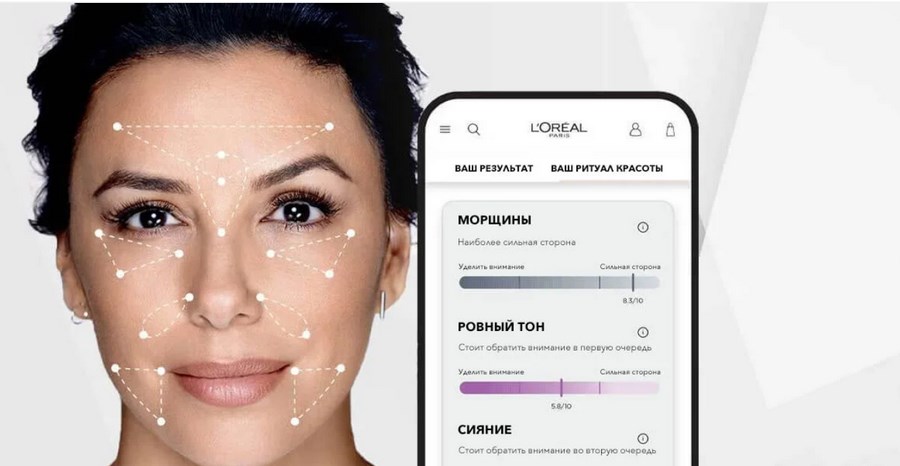

Похожие инициативы есть у Maybelline New York, NYX, Armani, Mary Kay, L’Oreal Paris (там даже можно «примерить» цвет волос и определиться с краской) — в общем, у многих марок косметики.

L’Oreal Paris

Кстати, о L’Oreal. У компании есть не только примерка макияжа онлайн. Skin Genius от L’Oreal — это digital-инструмент, который анализирует качество кожи в реальном времени с помощью AI. Программа сравнивает кожу с 10 000 реальных снимков от экспертов-дерматологов и на основе анализа рекомендует активные ингредиенты и конкретные советы и продукты по уходу за кожей.

С помощью deepfake-технологий «Сбер» «вернул к жизни» Жоржа Милославского, героя фильма «Иван Васильевич меняет профессию».

Герой предновогодней рекламы оказался в 2020 году, прокатился на «Ситимобиле», воспользовался приложением «Сбер.Онлайн», послушал музыку в «Сбер.Звуке», оплатил покупки телефоном, получил доставку из «Сбер.Маркета» и попал на концерт NILETTO.

Для воссоздания голоса героя была использована технология text-to-speech и реальные записи речи актера (Леонида Куравлева) общей длиной около 4-х минут. Несмотря на то, что это очень мало, специалистам «Группы ЦРТ» удалось синтезировать голос Милославского.

ESPN & Netflix

ESPN, американский кабельный канал, запустил рекламу документального сериала о Майкле Джордане («The Last Dance»). В рекламе спортивный ведущий Кенни Мэйн в 1998 году делает предсказания о том, что в 2020 ESPN снимет шоу о звезде баскетбола, а еще что «джинсы будут очень узкими», в целом делая отсылки к тому, каким будет будущее. Конечно, это не настоящий Кенни Мэйн, а его deepfake-версия.

Дипфейки удешевляют производство рекламы и любого видеоконтента. Недавно HBO сняла рекламу своего спортивного канала, в котором должны были принять участие звезды NBA. Из-за карантина путешествия и личные встречи со спортсменами были ограничены, поэтому создатели ролика сняли актеров с похожей внешностью, а потом с помощью технологии наложили лица реальных спортсменов.

Чтобы сделать видео, присутствие знаменитости на съемочной площадке вовсе не обязательно, а значит и гонорар звезды может быть значительно меньше.

Даниил Охлопков, Data Lead в Runa Capital

Malaria No More

Если компания работает на несколько рынков, снимать каждый раз новый ролик для каждого языка нет необходимости. Алгоритмы могут настроить движения лица модели и речь под необходимую языковую аудиторию.

Алексей Рыбаков, генеральный директор IT-компании Omega

Deepfake-технологии могут помочь брендам привлечь клиентов с помощью целенаправленных и персонализированных сообщений. Инфлюенсерам и селебрити дипфейки помогут больше и лучше взаимодействовать с аудиторией. Например, знаменитость может выступить в рамках модной рекламной кампании, даже не приходя на фотосессию.

Deepfake помогает повысить вовлечннность. К примеру, в 2020 году приложение Reface AI позволило пользователям виртуально примерить одежду Gucci.

В ретейле есть перспективы персонализировать обслуживание клиентов, используя deepfake-помощника, который обрабатывает онлайн-запросы, разговаривая с клиентом на одном языке. Так покупатели могут разговаривать с «настоящим» лицом, что повышает доверие к сервису.

Виталий Миняйло, сооснователь и СЕО IT-компании neurotrack.tech

Онлайн-примерочная

Русскоязычный разработчик Алексей Чаплыгин создал технологию, которая позволяет виртуально изменять параметры тела. Автор разрабатывал технологию для виртуальных примерочных, чтобы люди при просмотре одежды в интернет-магазине могли видеть вещи на себе, а не на моделях.

Бизнесу можно и нужно использовать дипфейки, если соблюдены два условия: на это есть колоссальные бюджеты, и остальные способы персонализации взаимодействия с аудиторией уже испробованы.

Сегодня deepfake — все еще дорогая технология, доступная далеко не каждой компании. Компаниям со скромными бюджетами предлагаем вместо одного взрывного ролика разработать грамотную стратегию продвиженияи вложиться в постоянный стабильный рост.

Раньше обращение телевизионной картинки прямо к конкретному зрителю было лишь сюжетом фантастических фильмов. Но теперь один и тот же рекламный ролик может быть настроен, например, под имя конкретного пользователя или сегмент целевой аудитории, которые не смогут понять, что движениями губ управляют алгоритмы, а не человек.

Алексей Рыбаков, генеральный директор IT-компании Omega

Скорее всего, технология станет привычным инструментом типа Photoshop. Ее можно будет использовать как в хороших целях — удешевление стоимости видеопродакшена с дорогими актерами, так и в сомнительных — для создания фейковых видео с известными личностями.

Даниил Охлопков, Data Lead в Runa Capital

Что думаете о развитии дипфейков? Видите в них качественный рекламный инструмент или пока не готовы использовать в работе?

Дипфейки: что это за технология и почему она опасна

Слово deepfake появилось несколько лет назад. Оно объединяет в себе два понятия: глубокое обучение (deep learning), то есть обучение нейросетей, и подделку (fake). Технология дипфейков заключается в синтезе ИИ человеческих изображений: алгоритм объединяет несколько фото, на которых человек изображен с разным выражением лица, и делает из них видео. При этом ИИ анализирует большое количество снимков и учится тому, как может выглядеть и двигаться конкретный человек. Об этом пишет американское издание Forbes.

С распространением дипфейков появились случаи «дискредитации» публичных личностей, чьих изображений много в открытом доступе. Например, весной 2019 года в Сети было опубликовано дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью ИИ изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик пьяна. Ситуация вылилась в громкий скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована ИИ.

Этот дипфейк был сделан достаточно просто. Но есть и сложные алгоритмы. Они не просто меняют тембр голоса или замедляют речь, а генерируют такие видео, на которых человек делает то, чего никогда не совершал, или говорит то, чего никогда не говорил. Со временем дипфейки будут становиться все более реалистичными, пишет американское издание Forbes. Уже сейчас технология претендует на то, чтобы влиять на политику, а в дальнейшем такие видео и вовсе смогут стать угрозой национальной безопасности.

Эйнштейн вместо тренера: что такое дипфейк и почему это тренд в обучении

Британский рекламный холдинг WPP обучает сотрудников при помощи нейросети. 50 000 человек осваивают основы маркетинга по видеокурсам с виртуальным наставником, который ведёт лекции на трёх языках: английском, испанском и китайском. При этом к каждому сотруднику наставник обращается лично по имени.

Видеокурсы на основе дипфейк уже создают компании Великобритании

и США. Рассказываем, что это за технология и чем полезна для бизнеса.

Что такое дипфейк и как работает

Дипфейк — видео, созданное с помощью искусственного интеллекта. Если упрощённо, нейросеть по пикселям собирает ролик на основе готовых изображений. Например, изучает тысячи фотографий Дэвида Бекхэма и выпускает видео, на котором спортсмен призывает людей бороться с малярией.

Дипфейк с Дэвидом Бекхэмом. Футболист на пяти языках призывает подписать петицию против малярии

Другой вариант работы — искусственный интеллект накладывает одного персонажа на другого и получается комбо: Джим Керри в роли злодея из фильма «Сияние» или Бред Питт в образе терминатора.

Нейросеть показала, как выглядел бы Джим Керри в фильме «Сияние». Смотреть пример целиком

Бред Питт в роли терминатора — очередная фантазия дипфейка

От архитектуры до журналистики — где используют дипфейк

Дипфейк изобрел студент Стэнфордского университета Ян Гудфеллоу

в 2014 году для разработчиков искусственного интеллекта. Но технология быстро вышла за пределы узкого круга учёных. Сейчас её используют

в массовой культуре: от архитектуры до журналистики.

С помощью дипфейка GauGAN детские наброски можно превратить в реалистичный пейзаж

У созданного при помощи дипфейка блогера Лил Микела два миллиона подписчиков в «Инстаграм»

Приложение Faceapp покажет, как бы вы выглядели в старости или женском образе

В чём польза дипфейка для корпоративного обучения

68% сотрудников предпочитают учебные видеоролики статьям, инфографике, презентациям и книгам. Это подтверждает международное исследование компании Wyzowl. При работе над видео дипфейк даёт бизнесу ряд преимуществ.

Это позволяет международным компаниям сэкономить деньги на локализации контента, снять языковой барьер и учить сотрудников во всех странах по единым стандартам.

Учебный ролик от стартапа Synthesia. При помощи нейросети тренер читает лекцию на французском, китайском и португальском. Технология меняет не только озвучку, но и движение губ тренера

При помощи технологии дипфейк лекция больше похожа на разговор по душам — тренер обращается к сотруднику по имени и говорит лично с ним

Как получить видеокурс по технологии дипфейк

Есть два способа: заказать у студии или создать самому при помощи специальных программ.

Чтобы сделать видеокурс в Synthesia Create не нужна студия, камера и даже ведущий — только сценарий. Остальное нейросеть делает за вас.

В Synthesia Create вы собираете видеокурс, как конструктор: выбираете персонажа, фон, язык озвучки, добавляете текст и нажимаете «Опубликовать». Курс готов — виртуальный персонаж ведёт тренинг по вашему сценарию

Synthesia Create полностью на английском языке. Есть бесплатная демоверсия. Чтобы её получить, достаточно оставить заявку на сайте.

Видеокурсы на основе нейросети кроме британского WPP уже создают в Reuters, SAP, Accenture и Buzzfeed, пишет издание Wired. Материалы используют для адаптации новичков, обучению технике безопасности и стандартам работы.

Технология дипфейк пока осваивается за рубежом. А позже, возможно, приживётся в и России, как это получилось с виртуальной реальностью.

Быстрый конструктор курсов и тестов

Поможет создать интерактивные курсы и тесты в рекордно короткие сроки. Без дизайнера и программиста.

Редактор iSpring. Пишу статьи по eLearning, помогаю экспертам выпускать материалы для блога iSpring. Если у вас есть интересная тема по дистанционному обучению, напишите мне.

Как играют умершие актеры: что такое дипфейк

В апреле 2022 года на Первом канале вышло продолжение сериала «Диверсант», одну из ролей в котором сыграл актер Владислав Галкин, умерший в 2010 году. Как это возможно? Оказывается, реалистично спародировать любого человека способна технология deepfake. Рассказываем, что это такое и насколько опасны могут быть дипфейки.

Как работает технология deepfake

Технология deepfake при помощи нейронных сетей анализирует большие массивы данных, чтобы имитировать выражение лица, манеры, голос и интонации человека. Процесс включает в себя передачу отснятого материала двух людей в алгоритм глубокого обучения, чтобы научить его менять лица местами.

При выполнении данной технологии компьютерное программное обеспечение выполняет бесшовное наложение какого-либо человеческого лица на убедительное виртуальное факсимиле. Таким образом создаются аудиовизуальные мистификации, бросающие вызов достоверности информации.

Технологические прорывы в области машинного обучения позволили создавать аудиовизуальные подделки с большой реалистичностью и масштабом. В частности, эти прорывы стали возможными благодаря двум достижениям: появлению больших наборов данных и разработке Генеративных состязательных сетей (GAN) — категории моделей машинного обучения, где нейронные сети конкурируют друг с другом без присмотра.

Опасность дипфейков возросла из-за способности GAN создавать очень реалистичные, поддельные медиапродукты в масштабе, используя большие наборы данных. Обученный GAN может делать сотни фотографий в секунду с различной детализацией, включая выражения мимики и разнообразие ракурсов для одного и того же сгенерированного лица.

Технология сама по себе не является злом. Она может приносить пользу, например, при создании видеоигр и улучшении астрономических изображений, на которых часто встречается шум от фона неба.

Чем нам угрожают дипфейки

Манипулятивные процессы, лежащие в основе дипфейков, все чаще вызывают этические вопросы, касающиеся производства медиаконтента. На данный момент дипфейки не способны полностью обмануть глаз, но, как и у любой технологии глубокого обучения, у данной технологии вполне могут возникнуть большие успехи в ближайшем будущем, когда медиаподделки станут неотличимы от настоящих.

Так, продукты технологии deepfake впервые появились на популярной интернет-платформе reddit.com, когда пользователь под ником «deepfakes» опубликовал порнографические видеоролики с лицами известных голливудских актрис, которые наложили поверх лиц оригинальных звезд фильмов для взрослых. Такие случаи прямо нарушают право человека на частную жизнь и могут повлечь за собой разрушение карьеры и семейных отношений людей, ставших объектами дипфейков.

Проблемы кибербезопасности представляют собой еще одну угрозу, создаваемую дипфейками. Эта технология может быть использована для манипулирования рынком и акциями, например, в роликах, в которых показано, как влиятельное лицо произносит расистские или женоненавистнические оскорбления, объявляет о поддельном слиянии, делает ложные заявления о финансовых потерях или банкротстве.

Кроме того, технология deepfake позволяет в режиме реального времени выдавать себя за руководителя в цифровом виде, который может попросить сотрудника выполнить срочный денежный перевод или предоставить конфиденциальную информацию.

Есть ли польза от дипфейков

Многие примеры дипфейков на таких платформах, как YouTube и TikTok, менее неэтичны и предназначены для развлечения, а не для того, чтобы обмануть зрителя. Использование в подобных видеороликах дипфейков предназначено для того, чтобы создавать своего рода юмористическое зрелище, поражающее зрителя своим технологическим мастерством и функционирующее как форма легкого развлечения.

Кроме того, современные видеохудожники часто рассматривают технологию deepfake как новую форму онлайн-юмора, а любительский труд по созданию дипфейков может функционировать и как своего рода портфолио.

Пример такого совмещения хобби и рабочей деятельности можно найти в видеороликах пользователя YouTube с никнеймом Shamook. Многие работы на странице этого пользователя состоят из довольно качественных с технологической точки зрения дипфейков. В видео используется не только полная замена лиц, но и технологии искусственного улучшения и омолаживания облика героев.

Степень, в которой эти дипфейки действительно являются улучшенными версиями оригиналов, довольно спорна. Но, тем не менее, это пример, когда технология deepfake используется не в злонамеренных целях, а в качестве технологического курьеза и профессиональной визитной карточки.

Почему нам не нравится, когда наше лицо используют без спроса

Дипфейки нарушают права собственности субъектов. То есть, независимо от репутационного вреда, использование и распространение изображения или видео человека без разрешения наносит ему дополнительный вред.

Чтобы разобраться в этом вреде, исследователи вводят понятие «плагиата личности». Смысл этой идеи заключается в том, что в то время как автор оригинала не обвиняется в плагиате, контекстные особенности поведения ложно приписываются субъекту, изображенному в дипфейк-видео, а не его создателю.

Наиболее отличительная черта дипфейков в нормативном смысле: они используют украденные цифровые данные, чтобы искусственно приписать человеку определенные действия и слова

Это порождает этическую сложность, при которой фигурирующий на видео человек возражает против того, каким образом он представлен в дипфейк-видео.

Так существование вредоносных дипфейков определяет важность права на цифровое самопредставление, которое становится все более значимым по мере того, как технологии цифрового плагиата становятся все изощреннее.

Основа права на цифровое самопредставление лежит в кантовском понимании важности уважения к людям как к самоцели. Причина, по которой к людям не следует относиться как к простым объектам, заключается в том, что люди способны размышлять о своем существовании, формировать идеи о том, что, по их мнению, является правильным для них, и имеют определенную свободу распоряжаться своими действиями.

Когда мы используем других людей как простое средство для реализации наших собственных целей и желаний, мы тем самым подрываем их внутреннюю ценность как личностей, лишая их шанса преследовать свои собственные цели.

Как в мире решается проблема регулирования технологии deepfake

Относительно правовой стороны вопроса, до сих пор не существует общепринятых тенденций в сфере цифрового законодательства в разных странах. Например, правительство Соединенных Штатов Америки по-настоящему обеспокоилось возможностью изменения политических предпочтений избирателей из-за распространения видеоматериалов с использованием deepfake во время предвыборной кампании 2020 года.

В России законодательная база по регулированию использования технологии deepfake только начинает формироваться. В частности, в 2020 году статья 128.1 Уголовного кодекса Российской Федерации приобрела некоторые изменения: в часть 2 было добавлено важное уточнение о распространении ложной информации в Сети.

Реакцией на необходимость регулирования подобной деятельности также можно считать возникновение в мире негосударственных организаций, разрабатывающих программное обеспечение по предотвращению информационных угроз, возникающих из-за вирусной природы дипфейк-видео.

Одним из примеров является объединение Facebook (запрещенная в России экстремистская организация) и Microsoft с университетами в 2019 году для запуска программы Deepfake Detection Challenge. Также заметна работа Агентства перспективных исследовательских проектов в области обороны (DARPA) по борьбе с дипфейками с помощью семантической криминалистики, которая ищет алгоритмические ошибки, например, несоответствующие предметы гардероба, которые носит человек в фальшивых видео.

Что можем сделать мы, чтобы случайно не поверить вредоносному дипфейку? В первую очередь следует проверять источники и тщательно изучать всю информацию на видео, в том числе и визуальную — совпадает ли цвет кожи на границе между лицом и шеей, оказывается ли правильным ракурс при движении, моргают ли на лице глаза. Кроме того, обращать внимание следует на голос человека на видео и на адекватность ситуации в целом, ведь за сомнения денег не берут. Безопасность куда дороже.

Вооруженный глаз: как распознать дипфейк

Дипфейки — это видеоролики, в которых одно лицо подменяется другим с помощью алгоритмов машинного обучения. Если несколько лет назад подобные имитации были довольно топорными и вызывали большей частью смех, то сегодня технология качественно эволюционировала. И, как это часто бывает с новинками, немедленно была взята на вооружение криминалом. Сгенерированный компьютером голос начальника просит сотрудника перевести крупную сумму, а звезд шоу-бизнеса и политиков терроризируют фальшивыми порнороликами с их участием. Эксперты прогнозируют, что по мере сбора биометрических данных риск мошенничества возрастает. Как распознать дипфейк и какие меры вводятся для борьбы с подобного рода манипуляциями — в материале «Известий».

Кейдж и обнаженка

Считается, что первые дипфейки появились в конце 2017 года, когда пользователь Deepfakes выложил на Reddit порнографические ролики, в которых лица актеров были заменены на лица голливудских звезд. Технология разошлась по Сети и породила массу подобного контента. Чуть позже, наигравшись с роликами для взрослых, пользователи взялись за Николаса Кейджа. С помощью приложения FakeApp, запущенного в январе 2018-го, американский актер был помещен в фильмы, в которых никогда не принимал участия. А несовершенность технологии только прибавила видео веселости.

В дальнейшем опыты стали более разнообразными: Сильвестр Сталлоне «превратился» в мальчика Кевина из фильма «Один дома», Арнольд Шварценеггер «сыграл» всех персонажей во «Властелине колец», а Илон Маск «исполнил» песню «Трава у дома».

Между дипфейками есть свои различия. Наверняка многие встречали видео, на которых пользователи «примеряют маску» знаменитых политиков, дарят им свою артикуляцию и заставляют говорить странные вещи. Данный метод называется Face2Face. Подделка создается в режиме реального времени и в отличие от собственно DeepFake не подменяет одно лицо другим, а искажает мимику исходного объекта.

Однако в последние годы термин deepfake используется в широком смысле — им обозначают все типы имитирующих видео, созданных искусственным интеллектом.

Механизм работы

Дипфейки создаются при помощи метода глубокого обучения, известного как генеративно-состязательная сеть (GAN). Его суть заключается в соревновании двух нейросетей: генератора и дискриминатора. Генератор создает подделку, а дискриминатор пытается понять, настоящее перед ним изображение или нет. Чем лучше обманывает генератор, тем выше конечный результат.

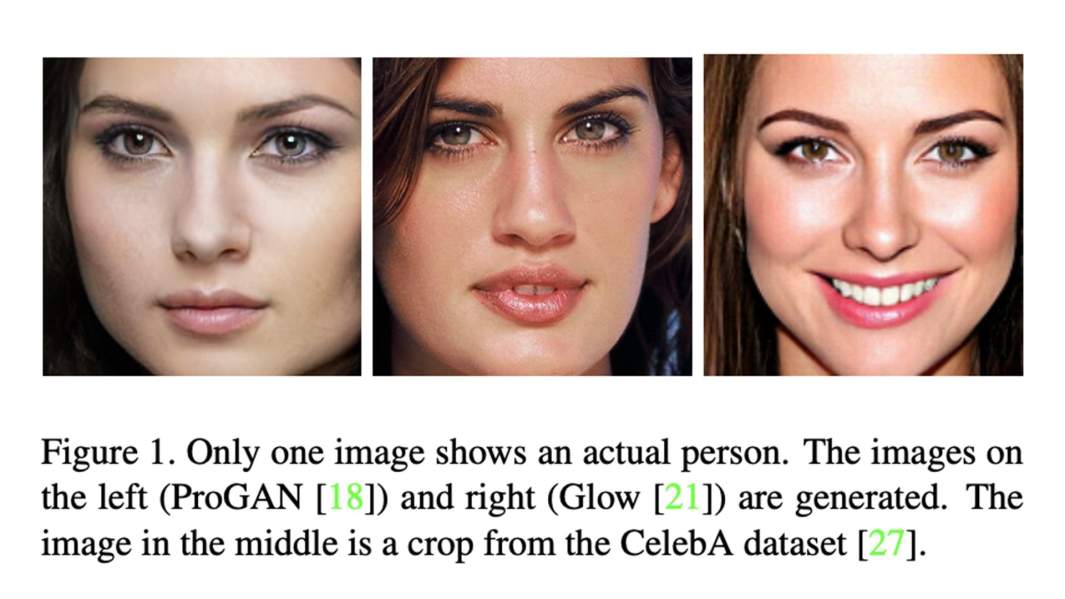

Прежде созданные GAN изображения отличались довольно низким разрешением. По размытости картинки можно было легко идентифицировать запись как сгенерированную. Это ограничение было преодолено в версии ProGAN, благодаря которой разрешение подскочило до 1024×1024 пикселей.

Другая модель — StyleGAN — научилась мастерски создавать лица несуществующих людей. Нейросеть обучилась на библиотеке реальных фотопортретов и стала сама генерировать человеческие образы.

Насколько высоки результаты в генерации новых лиц, можно убедиться на примере картинки ниже. Только на одной из трех фотографий изображена реальная девушка. Она посередине.

Как распознать подделку?

Точность и высокое качество дипфейков вызвали рост недоверия пользователей Сети к видеоконтенту. Однако при более внимательном рассмотрении в некоторых роликах заметны цифровые артефакты — недостатки, которые выдают имитацию. Для обоих поколений дипфейков (ранних недостаточно реалистичных и поздних гиперреалистичных) выявление артефактов происходит по одним и тем же участкам лица. Ученые из Университета Эрлангена–Нюрнберга описали возможные ограничения в своей статье.

Несуществующие лица. Часто у сгенерированных моделей не совпадает цвет левого и правого глаза. В природе явление гетерохромии встречается весьма редко, поэтому смешанные или отличающиеся цвета могут стать сигналом для опознания дипфейка. Также стоит иметь в виду, что расстояние от центра глаза до края радужной оболочки должно быть одинаковым для обоих глаз. Кроме того, ожидается, что оба лимба будут иметь правильный округлый контур. Обнаруженные артефакты проиллюстрированы на картинках ниже.

Face2Face. Для данного метода будут показательны границы лица и кончик носа. Неточное наложение маски приводит к артефактам затемнения, когда, например, одна сторона носа может казаться темнее другой. При этом контуры маски резко отделяются: это хорошо видно внизу лица и над бровями. Элементы, которые частично закрывают части лица (например, пряди волос), моделируются неправильно и могут привести к образованию «дыр».

DeepFake. Для дипфейков наиболее уязвимыми считаются глаза и зубы. Многие образцы имеют неубедительные зеркальные отражения — блики в глазах либо отсутствуют, либо кажутся упрощенными. Этот артефакт делает глаза тусклыми. Другой минус — непрорисованные зубы. Бывает, они вообще не моделируются, а выглядят как отдельное белое пятно.

Дипфейки: что это такое, зачем и кому они нужны + 13 кейсов

Том Круз решил «побаловать себя»: ест чупа-чупс, находит в нем жвачку и удивляется. Все это, естественно, практически в прямом эфире. Звезды все ближе к обычным людям! Или нет? Нет, это всего лишь deepfake-версия Тома Круза, но сходство впечатляющее, правда?

В этой статье рассказываем о том, что такое дипфейки, как их создают, чем они опасны, а также делимся кейсами их использования не только в формате шуточных видео, но и в «серьезном» маркетинге.

Что такое дипфейки

В начале 2021 года TikTok-видео с участием Тома Круза и правда набрали популярность. Поражают и внешнее сходство дипфейка с актером, и то, как точно передан его знаменитый смех. Этого «Тома Круза» создал Крис Уме, бельгийский специалист по deepfake-эффектам.

Основа видео – человек, на лицо которого наложили эффекты, благодаря чему он выглядит как Том Круз

В создании дипфейков участвуют GAN – генеративно-состязательные сети. Генеративная часть алгоритма, обучаясь на существующих фото, создает изображение. А состязательная – буквально «соревнуется» с первой частью алгоритма, стараясь отличить настоящие изображения от ненастоящих. В процессе этого соревнования и создаются дипфейки – изображения и видео, которые действительно трудно отличить от реальных, созданных человеком.

Сгенерированные изображения и видео со временем станут реалистичнее. Будет меньше видимых артефактов – следов того, что изображение было сгенерировано нейронной сетью.

Фотографии с сайта-генератора реалистичных лиц. На самом деле, этих людей не существует, они созданы нейросетью.

Обратите внимание, на первой картинке слева появился перевернутый рот, на второй смазаны зубы. Аналогичные неточности (артефакты) можно находить и на видео с дипфейками.

Сейчас для создания фотореалистичного deepfake необходима постобработка. Это наглядно показали создатели видео, где актер Том Круз баллотируется в президенты США.

На мой взгляд, технологию ожидает бумообразный рост в ближайшие несколько лет. Нынешний уровень развития технологии и ее перспективы стимулируют интерес, а значит, все больше разработчиков будут применять и использовать ее для решения своих задач. Решения будут все доступнее, дешевле и при этом качественнее.

На развитие будет сильно влиять то, как эта технология воспримется законодательно.

С одной стороны, все понимают, что мировую эволюцию deepfake не сдержать силами государства в отдельных странах.

С другой, это одна из наиболее опасных технологий в рамках текущей парадигмы безопасности, которая поддерживает мнение о том, что биометрия – отличный способ идентифицировать человека.

Опасность технологии

У дипфейков практически безграничные возможности: с их помощью можно «заставить» кого угодно говорить и делать что угодно. В 2018 году режиссер Джордан Пил создал видео, на котором Барак Обама говорит об опасности дипфейков и fake news (фальшивые новости) в целом:

Это видео всколыхнуло зарубежный интернет

«It may sound basic, but how we move forward in the age of information is going to be the difference between whether we survive or whether we become some kind of fucked-up dystopia».

«Это прозвучит банально, но пока мы на пути к веку информации, главный вопрос для нас – сможем ли мы выжить, или мир превратится в какую-то извращенную антиутопию».

На видео Обама ругает Трампа, не стесняясь выражений, и очень легко поверить в то, что это действительно бывший президент США. Видео было создано, чтобы предупредить пользователей об опасности дипфейков, а также призвать их не верить всему, что они видят.

Кроме того, дипфейки могут «помочь» развитию мошенничества в интернете или даже по телефону. В 2019 году CEO британской энергетической компании заплатил мошенникам 220 тыс. евро, потому что думал, что об этом попросил его босс, голос которого в телефонном разговоре сгенерировали киберпреступники.

В связи с этими проблемами появились программы и гранты для тех, кто создаст лучший детектор дипфейков.

Facebook активно занимается изучением дипфейков и способов им противостоять. В созданном компанией Deepfake Detection Challenge поучаствовали более 2 тыс. специалистов. Благодаря этому челленджу у AI-исследователей появятся новые методы для распознавания дипфейков, которые несут угрозу обществу.

В России на похожее исследование было выделено почти 5 млн р.

«Хорошие» кейсы

Дипфейки сами по себе не опасны. Есть и хорошие кейсы использования deepfake-технологий.

Например, дипфейки могут помогать людям. У Microsoft есть приложение Seeing.AI для слепых и слабовидящих людей:

Синтезированный голос комментирует все, что происходит вокруг человека с нарушениями зрения, помогая ему ориентироваться в мире

Дипфейки можно применять в образовании. WPP – британский международный холдинг в области коммуникаций, рекламы, связей с общественностью, технологий и торговли. Во время пандемии COVID-19 этой компании понадобилась программа для корпоративного обучения. Это было как раз в разгар локдауна, поэтому сделать видео с реальными спикерами было невозможно.

WPP обратилась к Synthesia, компании, специализирующейся на AI, и те создали для них обучающую программу, где в качестве лекторов выступают deepfake-аватары.

Дипфейки используются и в искусстве. Специалисты из Сколково и Samsung «оживили» Мону Лизу:

Сальвадора Дали тоже оживили, и он может не только двигаться, но даже отвечать на вопросы и делать селфи с желающими.

Дипфейки могут стать и частью индустрии развлечений. Уже есть десятки приложений, которые позволяют заменить одно лицо на другое и даже поместить себя в клип или фильм:

Я попала в супергеройскую команду благодаря Reface. Прекрасно и жутко одновременно

Кстати, при создании «Форсаж-7» тоже использовались deepfake-технологии. Получается, в теории они могут помочь решить проблему с дублерами и удешевить производство видеоконтента.

Представьте, как много рекламного и промо-контента можно генерировать даже без участия реальных знаменитостей. Может, в будущем они будут просто продавать свои образы, а студии получат возможность делать невероятный, но очень реалистичный контент. Меньше времени на съемку, возможность участвовать сразу в нескольких проектах одновременно вообще не выходя из дома. Все это – потенциально огромные рекламные контракты.

Применение в маркетинге и рекламе

Можно ли применять deepfake-технологии в рекламе? Да! Ниже – несколько успешных кейсов, которые могут послужить референсами для ваших рекламных кампаний.

Vivienne Sabo

Бренд косметики – один из российских пионеров применения deepfake-технологий. В 2020 году компания запустила рекламный видеопроект с использованием технологии замены лиц.

Deepfake-промо тонального крема Cabaret

На сцене кабаре мог оказаться каждый. Достаточно было загрузить свое фото на специальном лендинге или в приложении на базе Vk Mini Apps и получить видео. Кампания уже завершена, так что сделать видео больше нельзя.

Технология дополненной реальности позволяет покупателю примерить одежду, обувь, бижутерию, попробовать макияж виртуально. Deepfake-технология способна сделать то же самое. В отличие от AR, она показывает не просто то, подходит ли вещь, а как сам человек выглядит с ней со стороны.

Clarins

Этот бренд косметики тоже предлагает примерить макияж не выходя из дома. Нужно всего лишь перейти на страницу средства в интернет-магазине и нажать кнопку «Макияж онлайн». Можно загрузить фото из галереи телефона или снять новое. Примерять можно средства для лица, глаз и губ.

Похожие инициативы есть у Maybelline New York, NYX, Armani, Mary Kay, L’Oreal Paris (там даже можно «примерить» цвет волос и определиться с краской) – в общем, у многих марок косметики.

L’Oreal Paris

Кстати, о L’Oreal. У компании есть не только примерка макияжа онлайн. Skin Genius от L’Oreal – это digital-инструмент, который анализирует качество кожи в реальном времени с помощью AI. Программа сравнивает кожу с 10 000 реальных снимков от экспертов-дерматологов и на основе анализа рекомендует активные ингредиенты и конкретные советы и продукты по уходу за кожей.

С помощью deepfake-технологий «Сбер» «вернул к жизни» Жоржа Милославского, героя фильма «Иван Васильевич меняет профессию».

Вы наверняка помните, как он советовал хранить деньги в сберегательной кассе?

Герой предновогодней рекламы оказался в 2020 году, прокатился на «Ситимобиле», воспользовался приложением «Сбер.Онлайн», послушал музыку в «Сбер.Звуке», оплатил покупки телефоном, получил доставку из «Сбер.Маркета» и попал на концерт NILETTO.

Для воссоздания голоса героя была использована технология text-to-speech и реальные записи речи актера (Леонида Куравлева) общей длиной около 4-х минут. Несмотря на то, что это очень мало, специалистам «Группы ЦРТ» удалось синтезировать голос Милославского.

ESPN & Netflix

ESPN, американский кабельный канал, запустил рекламу документального сериала о Майкле Джордане («The Last Dance»). В рекламе спортивный ведущий Кенни Мэйн в 1998 году делает предсказания о том, что в 2020 ESPN снимет шоу о звезде баскетбола, а еще что «джинсы будут очень узкими», в целом делая отсылки к тому, каким будет будущее. Конечно, это не настоящий Кенни Мэйн, а его deepfake-версия.

Дипфейки удешевляют производство рекламы и любого видеоконтента. Недавно HBO сняла рекламу своего спортивного канала, в котором должны были принять участие звезды NBA. Из-за карантина путешествия и личные встречи со спортсменами были ограничены, поэтому создатели ролика сняли актеров с похожей внешностью, а потом с помощью технологии наложили лица реальных спортсменов.

Чтобы сделать видео, присутствие знаменитости на съемочной площадке вовсе не обязательно, а значит и гонорар звезды может быть значительно меньше.

Malaria No More

Еще один хороший пример – Дэвид Бэкхем, говорящий на 9 языках в рекламе компании Malaria No More.

Социальная реклама, призывающая обратить внимание и помочь остановить эпидемию малярии

Если компания работает на несколько рынков, снимать каждый раз новый ролик для каждого языка нет необходимости. Алгоритмы могут настроить движения лица модели и речь под необходимую языковую аудиторию.

Deepfake-технологии могут помочь брендам привлечь клиентов с помощью целенаправленных и персонализированных сообщений. Инфлюенсерам и селебрити дипфейки помогут больше и лучше взаимодействовать с аудиторией. Например, знаменитость может выступить в рамках модной рекламной кампании, даже не приходя на фотосессию.

Deepfake помогает повысить вовлечннность. К примеру, в 2020 году приложение Reface AI позволило пользователям виртуально примерить одежду Gucci.

В ретейле есть перспективы персонализировать обслуживание клиентов, используя deepfake-помощника, который обрабатывает онлайн-запросы, разговаривая с клиентом на одном языке. Так покупатели могут разговаривать с «настоящим» лицом, что повышает доверие к сервису.

Онлайн-примерочная

Русскоязычный разработчик Алексей Чаплыгин создал технологию, которая позволяет виртуально изменять параметры тела. Автор разрабатывал технологию для виртуальных примерочных, чтобы люди при просмотре одежды в интернет-магазине могли видеть вещи на себе, а не на моделях.

Видео с канала Алексея, на котором показано, как это работает

Бизнесу можно и нужно использовать дипфейки, если соблюдены два условия: на это есть колоссальные бюджеты, и остальные способы персонализации взаимодействия с аудиторией уже испробованы.

Раньше обращение телевизионной картинки прямо к конкретному зрителю было лишь сюжетом фантастических фильмов. Но теперь один и тот же рекламный ролик может быть настроен, например, под имя конкретного пользователя или сегмент целевой аудитории, которые не смогут понять, что движениями губ управляют алгоритмы, а не человек.

Скорее всего, технология станет привычным инструментом типа Photoshop. Ее можно будет использовать как в хороших целях – удешевление стоимости видеопродакшена с дорогими актерами, так и в сомнительных – для создания фейковых видео с известными личностями.

Что думаете о развитии дипфейков? Видите в них качественный рекламный инструмент или пока не готовы использовать в работе?

Розыгрыш 3 мест до 24.08. Остальным участникам розыгрыша – скидка 50 %

DeepFake-туториал: создаем собственный дипфейк в DeepFaceLab

Библиотека программиста

DeepFake – технология синтеза изображения, основанная на искусственном интеллекте и используемая для замены элементов изображения на желаемые образы. Если вы не слышали о дипфейках, посмотрите приведенный ниже видеоролик. В нём актёр Джим Мескимен читает стихотворение «Пожалейте бедного пародиста» в двадцати лицах знаменитостей.