зачем запрещать индексацию сайта

Зачем запрещать индексацию страниц благодарности в поисковиках?

Индексация страниц сайта в поисковиках – основа SEO. Чем больше страниц проиндексировано, тем больше релевантного трафика, все верно; тем не менее существуют страницы, которые нежелательно показывать пользователям, не прошедшим воронку конверсии на вашем ресурсе или на автономных целевых страницах.

Как следует из заголовка поста, речь сегодня пойдет о запрете индексации страниц благодарности или Tnank You Pages.

Итак, предположим, вы направляете посетителя на посадочную страницу в воронку конверсии, в качестве «добавочной приманки» обещая ему некий дополнительный приз, ожидающий его на странице благодарности после завершения процесса конвертации – «получите в подарок книгу в формате PDF!». Однако, оставляя страницу Tnank You Page в SERP (ранжирование результатов поиска), вы увеличиваете вероятность перехода пользователя на страницу благодарности «через черный ход».

Мы, как маркетологи, хотим избегать таких вот случайных «попаданий в цель» по двум причинам:

Эти страницы благодарности вполне могут занимать верхние позиции рейтинга по низкочастотным запросам и генерировать какой-либо трафик. В любом случае, мы рекомендуем закрыть автономные лендинги и страницы вашего ресурса от индексации.

Как запретить индексацию Tnank You Page, пользуясь редактором LPgenerator

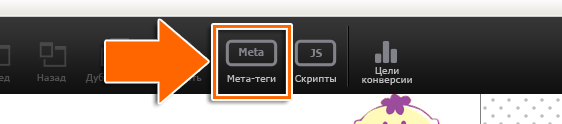

Выберите инструмент «Мета-теги» в основном меню редактора:

Для запрета индексации страницы поставьте галочки в соответствующие чек-боксы «Robots noindex» и «Robots nofollow»:

Как запретить индексацию страниц своего сайта

Существуют также 2 способа запрета индексации страниц «вручную».

Вариант 1: через файл robots.txt

Первый способ заключается в добавлении файла robots.txt на ваш сайт. Преимуществом данного метода является возможность получить максимальный уровень контроля над тем, что вы позволяете (или не позволяете) индексировать поисковым ботам. В файле robots.txt вы можете указать, хотите ли вы блокировать ботам доступ к одной отдельной странице, целому каталогу сайта или же к одному-единственному изображению или файлу. О тонкостях создания и настройки файла robots.txt можно узнать здесь.

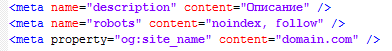

Вариант 2: через метатег «noindex»

Использование метатега noindex – самый простой и эффективный способ удаления страницы из результатов поиска (SERP). При использовании на вашем сайте той или иной системы управления контентом (CMS), от вас потребуется лишь минимальное владение «искусством копипасты» (copy/paste). Итак, вот как это делается.

Для начала скопируйте этот тег:

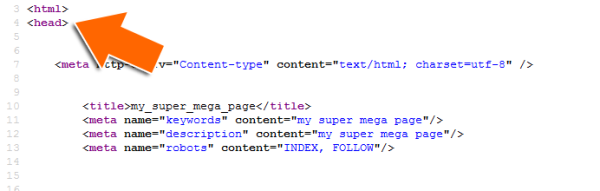

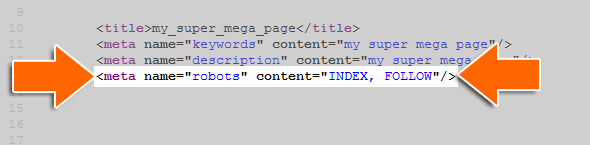

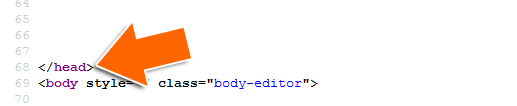

Затем вставьте его в начало новой строки в разделе HTML-верстки вашей страницы (этот раздел называется header, хедер). На скриншотах ниже представлено, как это выглядит на практике.

Вот здесь начинается хедер:

Вот метатег noindex в хедере:

А здесь хедер заканчивается:

Вот и все! Теперь метатег «прикажет» поисковым роботам «развернуться и уйти», удалив тем самым страницу из результатов поиска.

Нужно только помнить вот о чем: результат запрета индексирования проявится не мгновенно. Изменения станут заметны только тогда, когда поисковые машины в очередной раз проиндексируют ваш сайт.

Какие страницы следует закрывать от индексации

Индексирование сайта – это процесс, с помощью которого поисковые системы, подобные Google и Yandex, анализируют страницы веб-ресурса и вносят их в свою базу данных. Индексация выполняется специальным ботом, который заносит всю необходимую информацию о сайте в систему – веб-страницы, картинки, видеофайлы, текстовый контент и прочее. Корректное индексирование сайта помогает потенциальным клиентам легко найти нужный сайт в поисковой выдаче, поэтому важно знать обо всех тонкостях данного процесса.

В сегодняшней статье я рассмотрю, как правильно настроить индексацию, какие страницы нужно открывать для роботов, а какие нет.

Почему важно ограничивать индексацию страниц

Заинтересованность в индексации есть не только у собственника веб-ресурса, но и у поисковой системы – ей необходимо предоставить релевантную и, главное, ценную информацию для пользователя. Чтобы удовлетворить обе стороны, требуется проиндексировать только те страницы, которые будут интересны и целевой аудитории, и поисковику.

Прежде чем переходить к списку ненужных страниц для индексации, давайте рассмотрим причины, из-за которых стоит запрещать их выдачу. Вот некоторые из них:

В краулинговый бюджет входят: взломанные страницы, файлы CSS и JS, дубли, цепочки редиректов, страницы со спамом и прочее.

Что нужно скрывать от поисковиков

В первую очередь стоит ограничить индексирование всего сайта, который еще находится на стадии разработки. Именно так можно уберечь базу данных поисковых систем от некорректной информации. Если ваш веб-ресурс давно функционирует, но вы не знаете, какой контент стоит исключить из поисковой выдачи, то рекомендуем ознакомиться с нижеуказанными инструкциями.

PDF и прочие документы

Часто на сайтах выкладываются различные документы, относящиеся к контенту определенной страницы (такие файлы могут содержать и важную информацию, например, политику конфиденциальности).

Рекомендуется отслеживать поисковую выдачу: если заголовки PDF-файлов отображаются выше в рейтинге, чем страницы со схожим запросом, то их лучше скрыть, чтобы открыть доступ к наиболее релевантной информации. Отключить индексацию PDF и других документов вы можете в файле robots.txt.

Разрабатываемые страницы

Стоит всегда избегать индексации разрабатываемых страниц, чтобы рейтинг сайта не снизился. Используйте только те страницы, которые оптимизированы и наполнены уникальным контентом. Настроить их отображение можно в файле robots.txt.

Копии сайта

Если вам потребовалось создать копию веб-ресурса, то в этом случае также необходимо все правильно настроить. В первую очередь укажите корректное зеркало с помощью 301 редиректа. Это позволит оставить прежний рейтинг у исходного сайта: поисковая система будет понимать, где оригинал, а где копия. Если же вы решитесь использовать копию как оригинал, то делать это не рекомендуется, так как возраст сайта будет обнулен, а вместе с ним и вся репутация.

Веб-страницы для печати

Иногда контент сайта требует уникальных функций, которые могут быть полезны для клиентов. Одной из таких является «Печать», позволяющая распечатать необходимые страницы на принтере. Создание такой версии страницы выполняется через дублирование, поэтому поисковые роботы могут с легкостью установить копию как приоритетную. Чтобы правильно оптимизировать такой контент, необходимо отключить индексацию веб-страниц для печати. Сделать это можно с использованием AJAX, метатегом либо в файле robots.txt.

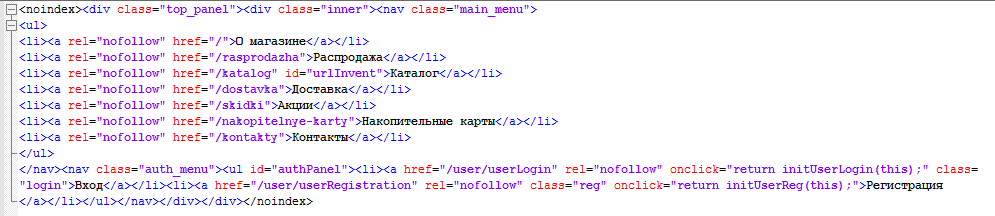

Формы и прочие элементы сайта

Большинство сайтов сейчас невозможно представить без таких элементов, как личный кабинет, корзина пользователя, форма обратной связи или регистрации. Несомненно, это важная часть структуры веб-ресурса, но в то же время она совсем бесполезна для поисковых запросов. Подобные типы страниц необходимо скрывать от любых поисковиков.

Страницы служебного пользования

Формы авторизации в панель управления и другие страницы, используемые администратором сайта, не несут никакой важной информации для обычного пользователя. Поэтому все служебные страницы следует исключить из индексации.

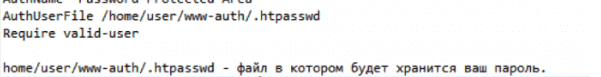

Личные данные пользователя

Вся персональная информация должна быть надежно защищена – позаботиться о ее исключении из поисковой выдачи нужно незамедлительно. Это относится к данным о платежах, контактам и прочей информации, идентифицирующей конкретного пользователя.

Страницы с результатами поиска по сайту

Как и в случае со страницами, содержащими личные данные пользователей, индексация такого контента не нужна: веб-страницы результатов полезны для клиента, но не для поисковых систем, так как содержат неуникальное содержание.

Сортировочные страницы

Контент на таких веб-страницах обычно дублируется, хоть и частично. Однако индексация таких страниц посчитается поисковыми системами как дублирование. Чтобы снизить риск возникновения таких проблем, рекомендуется отказаться от подобного контента в поисковой выдаче.

Пагинация на сайте

Пагинация – без нее сложно представить существование любого крупного веб-сайта. Чтобы понять ее назначение, приведу небольшой пример: до появления типичных книг использовались свитки, на которых прописывался текст. Прочитать его можно было путем развертывания (что не очень удобно). На таком длинном холсте сложно найти нужную информацию, нежели в обычной книге. Без использования пагинации отыскать подходящий раздел или товар также проблематично.

Пагинация позволяет разделить большой массив данных на отдельные страницы для удобства использования. Отключать индексирование для такого типа контента нежелательно, требуется только настроить атрибуты rel=»canonical», rel=»prev» и rel=»next». Для Google нужно указать, какие параметры разбивают страницы – сделать это можно в Google Search Console в разделе «Параметры URL».

Помимо всего вышесказанного, рекомендуется закрывать такие типы страниц, как лендинги для контекстной рекламы, страницы с результатами поиска по сайту и поиск по сайту в целом, страницы с UTM-метками.

Какие страницы нужно индексировать

Ограничение страниц для поисковых систем зачастую становится проблемой – владельцы сайтов начинают с этим затягивать или случайно перекрывают важный контент. Чтобы избежать таких ошибок, рекомендуем ознакомиться с нижеуказанным списком страниц, которые нужно оставлять во время настройки индексации сайта.

Соблюдение индексации таких страниц может значительно улучшить поисковую выдачу, если ранее оптимизация не проводилась.

Как закрыть страницы от индексации

Мы детально рассмотрели список всех страниц, которые следует закрывать от поисковых роботов, но о том, как это сделать, прошлись лишь вскользь – давайте это исправлять. Выполнить это можно несколькими способами: с помощью файла robots.txt, добавления специальных метатегов, кода, сервисов для вебмастеров, а также с использованием дополнительных плагинов. Рассмотрим каждый метод более детально.

Способ 1: Файл robots.txt

Данный текстовый документ – это файл, который первым делом посещают поисковики. Он предоставляет им информацию о том, какие страницы и файлы на сайте можно обрабатывать, а какие нет. Его основная функция – сократить количество запросов к сайту и снизить на него нагрузку. Он должен удовлетворять следующим критериям:

Прежде чем переходить к редактированию файла, рекомендую обратить внимание на ограничивающие факторы.

Файл robots.txt включает в себя такие параметры, как:

Теперь давайте рассмотрим, как можно отключить индексацию определенных страниц или всего сайта. Все пути в примерах – условные.

Пропишите, чтобы исключить индексацию сайта для всех роботов:

Как закрыть сайт от индексации поисковых систем: 5 проверенных способов

Очень часто требуется закрыть сайт от индексации, например при его разработке, чтобы ненужная информация не попала в индекс поисковых систем или по другим причинам. При этом есть множество способов, как это можно сделать, все их мы и рассмотрим в этой статье.

Зачем сайт закрывают для индекса?

Есть несколько причин, которые заставляют вебмастеров скрывать свои проекты от поисковых роботов. Зачастую к такой процедуре они прибегают в двух случаях:

Не думайте, что если ваш ресурс только появился на свет и вы не отправили поисковикам ссылки для его индексации, то они его не заметят. Роботы помимо ссылок учитывают еще и ваши посещения через браузер.

Какие есть способы запрета индексации сайта?

1. Закрытие индексации через WordPress

Если сайт создан на базе WordPress, это ваш вариант. Скрыть проект от ботов таким образом проще и быстрее всего:

Благодаря встроенной функции, движок автоматически изменит robots.txt, откорректировав правила и отключив тем самым индексацию ресурса.

На заметку. Следует отметить, что окончательное решение, включать сайт в индекс или нет, остается за поисковиками, и ниже можно увидеть это предупреждение. Как показывает практика, с Яндексом проблем не возникает, а вот Google может продолжить индексировать документы.

2. Посредством файла robots.txt

Если у вас нет возможности проделать эту операцию в WordPress или у вас стоит другой движок сайта, удалить веб-сайт из поисковиков можно вручную. Это также реализуется несложно. Создайте обычный текстовый документ, разумеется, в формате txt, и назовите его robots.

Затем скиньте его в корневую папку своего портала, чтобы этот файл мог открываться по такому пути site.ru/robots.txt

Но сейчас он у вас пустой, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его элементы. Рассмотрим все варианты, которые вам могут пригодиться.

Закрыть сайта полностью для всех поисковых систем

Укажите в robots.txt команду:

Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt. Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы скинули файл не туда.

Отдельную папку

Так вы скроете все файлы, находящиеся в указанной папке.

Только в Яндексе

Чтобы перепроверить, получилось ли у вас удалить свой блог из Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в соответствующий раздел по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки URL вставьте несколько ссылок на документы ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах будет написано «Запрещено правилом /*?*».

Только для Google

Проверить, получилось ли сделать запрет, или нет, можно аналогичным способом, что и для Яндекса, только вам нужно будет посетить панель вебмастера Google Search Console. Если документ закрыт от поисковика, то напротив ссылки будет написано «Заблокировано по строке», и вы увидите ту самую строку, которая дала команду ботам не индексировать его.

Но с большой вероятностью вы можете увидеть «Разрешено». Здесь два варианта: либо вы что-то сделали неправильно, либо Google продолжает индексировать запрещенные в документе robots страницы. Я уже упоминал об этом выше, что для поисковых машин данный документ несет лишь рекомендационный характер, и окончательное решение по индексированию остается за ними.

Для других поисковиков

Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды. Представляем вашему вниманию самые распространенные (кроме Яндекса и Google):

Список имен всех ботов вы с легкостью найдете в интернете.

Скрыть изображения

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

Закрыть поддомен

Любой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

3. С применением тега name=”robots”

4. В настройках сервера

5. С помощью HTTP заголовка X-Robots-Tag

Мы подробно расписали как этот способ настроить и использовать в нашей статье.

Как проверить индексацию сайта и страниц?

Заключение

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.

Оцените эту статью. Чтобы мы могли делать лучший контент! Напишите в комментариях, что вам понравилось и не понравилось!

Рейтинг статьи: 5 / 5. Кол-во оценок: 10

Пока нет голосов! Будьте первым, кто оценит эту статью.

Руководство: как закрыть сайт от индексации в поисковых системах? Работа с файлом robots.txt

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же файле robots.txt с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

User-agent: Yandex

Disallow: /folder/file.php

Как проверить, в индексе документ или нет? #

Проще всего осуществить проверку в рамках сервиса «Пиксель Тулс», бесплатный инструмент «Определение возраста документа в Яндексе» позволяет ввести URL списком. Если документ отсутствует в индексе, то в таблице будет выведено соответствующее значение.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в robots.txt:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как закрыть поддомен? #

У каждого поддомена на сайте, в общем случае, имеется свой файл robots.txt. Обычно он располагается в папке, которая является корневой для поддомена. Требуется скорректировать содержимое файла с указанием закрываемых разделов с использованием директории Disallow. Если файл отсутствует — его требуется создать.

При использовании CDN-версии #

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в файле robots.txt. Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /catalog/books.php

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько. Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://pixelplus.ru/sitemap.xml

Закрыть страницу и сайт с помощью meta-тега name=»robots» #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации внутри зоны документа устанавливается следующий код:

Или (полная альтернатива):

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=»robots» имя робота, а именно:

Для паука Google:

Или для Яндекса:

Что необходимо закрывать от индексации на сайте

Что такое индексация сайта

Индексация – это процесс сканирования сайта поисковыми роботами и внесение полученной информации в базу данных поисковика. Для получения статуса проиндексированного ресурсу необходимо, чтобы на него зашёл поисковый бот. Такие боты заносят в систему информацию и о сайте, и обо всех его страницах, и о материалах (видео, тексты, картинки), доступных для поиска.

В интересах владельца сайта, чтобы его целевая аудитория могла быстро найти конкретный веб-ресурс в выдаче. Цель же поисковой системы – предоставление пользователю ценной и релевантной информации. А значит, чтобы выполнялись и цели владельца сайта, и цели поисковика, стоит позаботиться о корректной индексации. А для этого открываются только те данные, которые будут полезны и уместны в результатах поиска.

Причины, по которым запрещается сканирование страницы или отдельной информации на ней:

В то же время важно убедиться, что страницы с уникальной, важной и полезной для пользователя информацией открыты для индексации.

Что следует закрывать на сайте

Скрыть от поискового бота можно как часть контента, так и полную информацию на странице или весь сайт. Разберёмся, какие из данных можно закрыть:

Рассмотрим коротко каждый из пунктов.

Размещённый контент

Нередко данные, размещаемые на сайте, дублируются на разных страницах. Например, это может быть дополнительное меню или блок текста, или ссылка на другие ресурсы. Иногда для оптимизации сайта такую информацию стоит закрыть от поисковиков, но делать это мы рекомендуем только в исключительных случаях либо не делать вовсе.

Страницы

Здесь подразумеваются страницы разного типа. В перечень таковых включаются:

Весь сайт

Например, если ресурс находится в процессе разработки, лучше скрыть его на этапе создания и наполнения, чтобы в поисковую базу не попала некорректная информация о сайте.

Какие данные закрывать не стоит

Увлёкшись закрытием информации, владельцы сайтов нередко «перегибают палку». Так, есть ряд данных, сокрытие которых может больше навредить, чем принести пользу в поисковой выдаче. К таковым относятся:

Другими словами, надо тщательно рассмотреть вопрос распределения открытых и скрытых от индексации страниц. Разобравшись с этим, переходим к инструментам для выполнения задачи.

Как закрывать от индексации контент, страницу или весь сайт

Обсудим набор инструментов для корректного закрытия данных сайта от поискового бота. К ним относятся:

Рассмотрим, как работать с каждым из них.

Файл robots.txt

Robots.txt представляет собой служебный файл текстового типа, содержащий набор рекомендаций для работы ботов-поисковиков. Расположен в корневой папке сайта и именно с него начинается изучение ресурса поисковой системой. В документ включён перечень директив, за счёт которых ограничивается доступность определённых частей сайта для роботов.

Так, добавив к тегу Disallow наименование раздела или папки, получится закрыть их от сканирования. Подробнее о настройке файла robots.txt можно прочитать здесь.

При этом важно проверить отсутствие внешних ссылок, ведущих к этому участку сайта.

Способ отличается удобством, скоростью выполнения и простотой применения. Но использование только этого инструмента не гарантирует отсутствия индексирования по выбранным страницам.

Применение тега Noindex и метатега Robots

Метатег Robots используется для задания детальных настроек на уровне страницы. От такой настройки зависит и индексация страницы, и её отображение в результатах поиска. В разделе страницы следует размещать метатег robots.

Тегом noindex запрещается демонстрация поисковиками страницы в результатах поиска. Значение robots, задаваемое для атрибута name, говорит о том, что директива касается каждого поискового робота. Если нужно закрыть доступ только одному из ботов, вместо robots указывается другое значение атрибута name – наименование определённого робота.

Отдельных поисковых ботов также называют агентами пользователя (роботом используется агент пользователя при запросе страницы). Для примера: агентом пользователя стандартного поискового робота Google называется Googlebot. Запрет сканирования страницы только им оформляется изменением тега таким образом:

Этот инструмент почти со 100% гарантией выполняет поставленную задачу.

Тег noindex используют также в HTML-коде страницы для закрытия части контента страницы от индексации. Однако тег не гарантирует того, что контент не будет проиндексирован.

Можно также использовать JavaScript для этой цели, так как тег noindex игнорируется ботами Google (он распознается только Яндексом). При использовании данного метода текст, блок, код, ссылка или любой другой контент кодируется в Javascript, а далее скрипт закрывается от индексации при помощи Robots.txt. Но следует помнить, поисковики настаивают на том, чтобы информация для пользователей и для роботов была идентичной.

Таким способом полностью закрывается доступ поисковикам к контенту сайта. Однако наличие пароля делает сайт труднодоступным для сканирования на наличие ошибок. Это происходит из-за того, что не у всех сервисов проверки есть опция ввода пароля.

С помощью JavaScript

Например с помощью скрипта Ajax можно не столько скрывать дублирующие и «мусорные» страницы, сколько исключить сам факт их создания. То есть содержание страницы меняется без изменения в URL, даже когда пользователь вводит при помощи фильтра определённые параметры товаров интернет-магазина.

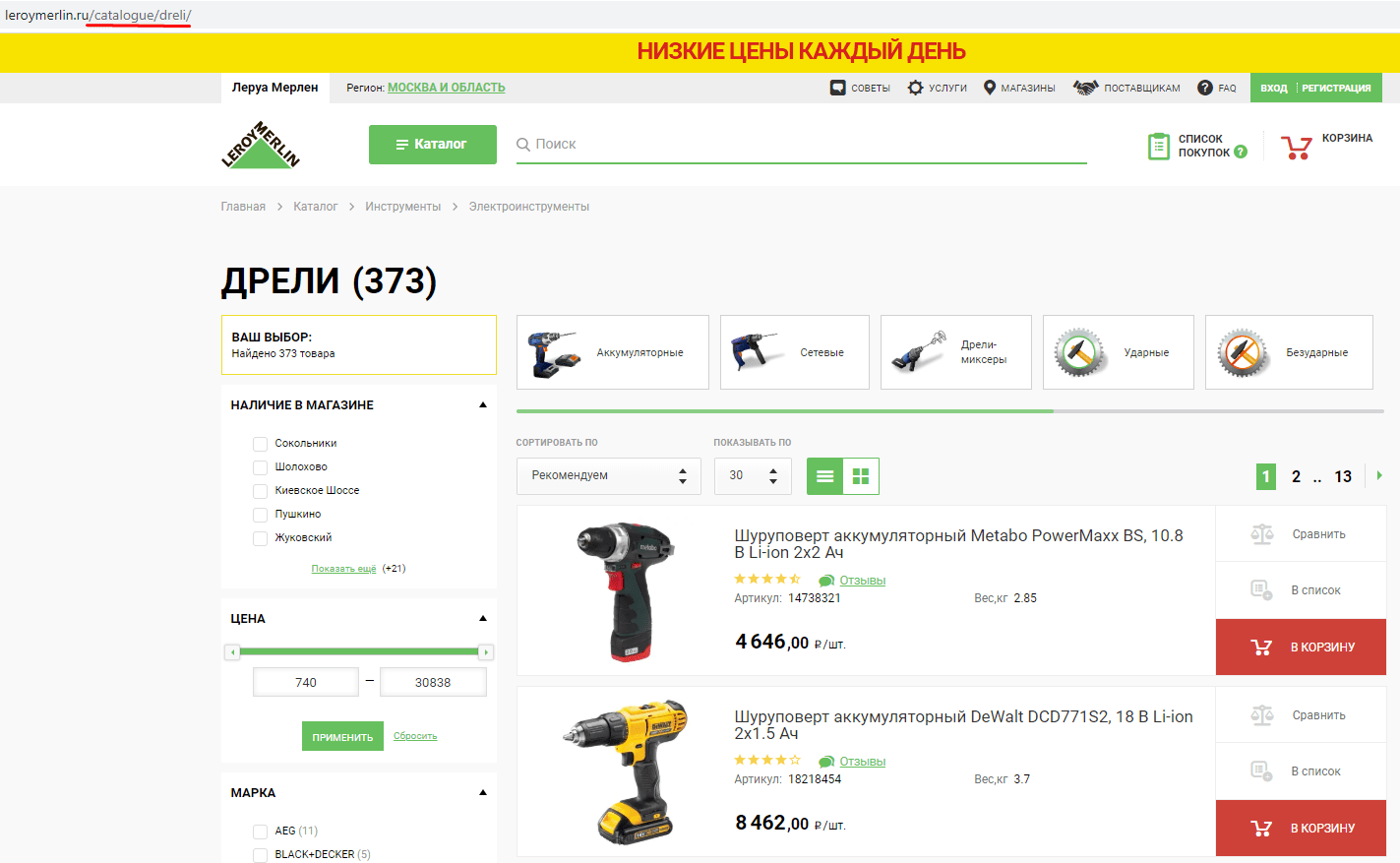

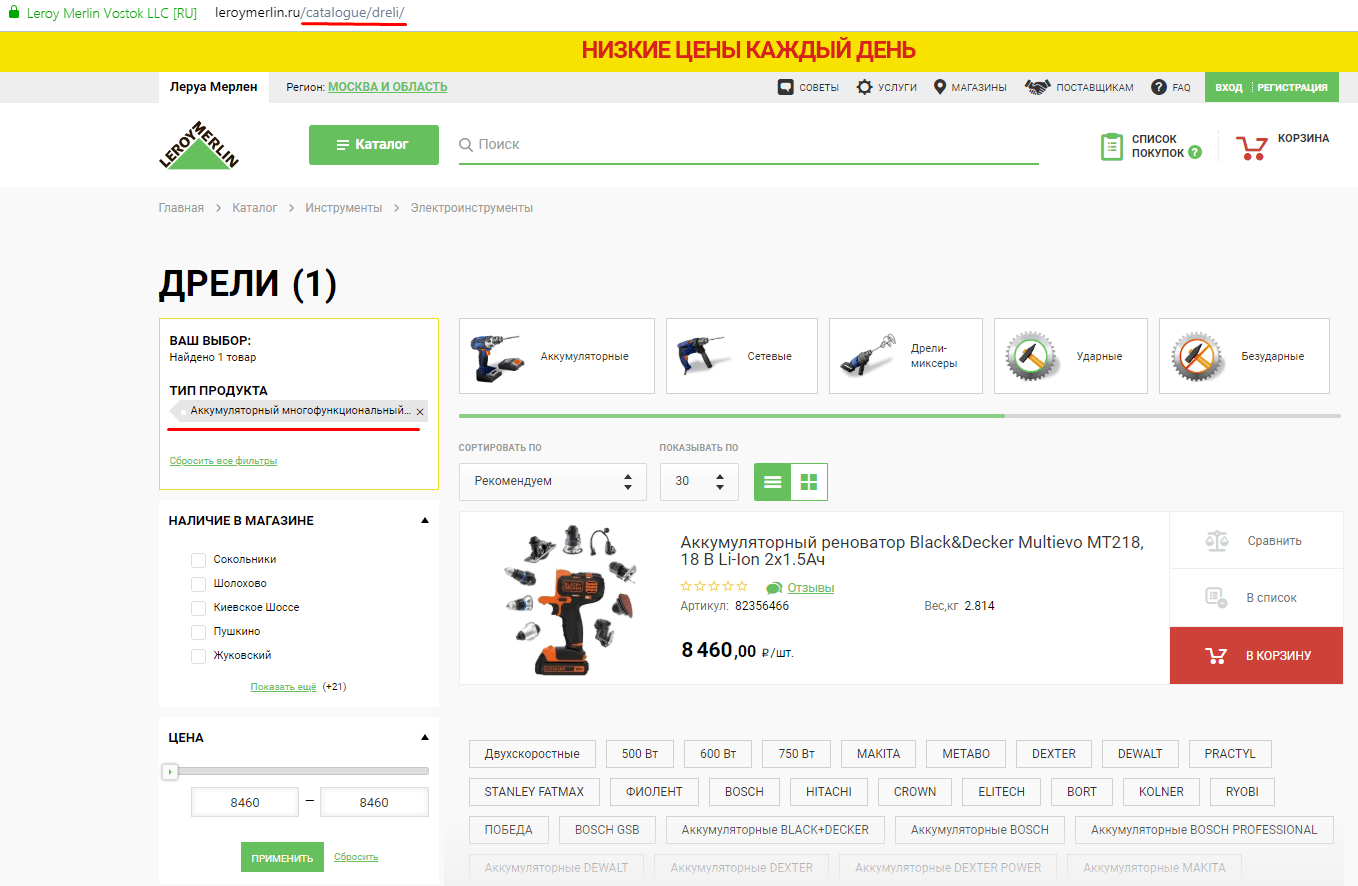

Разберём на примере. Вот страница без фильтра:

Вот та же страница с выбранным фильтром:

Как видим, в последнем примере были выбраны фильтры, подгружены товары, однако URL страницы не поменялся.

Метод эффективный, но трудоёмкий. К тому же его не получится применить ко всем параметрам сайта, которые необходимо скрыть от индексации.

Инструменты удаления страниц из индекса

Иногда «ненужным страницам» всё же удаётся обойти запреты и попасть в индекс. Их оперативное устранение улучшит положение сайта в рейтинге поисковой системы.

Это актуально как для Google, так и для Яндекса.

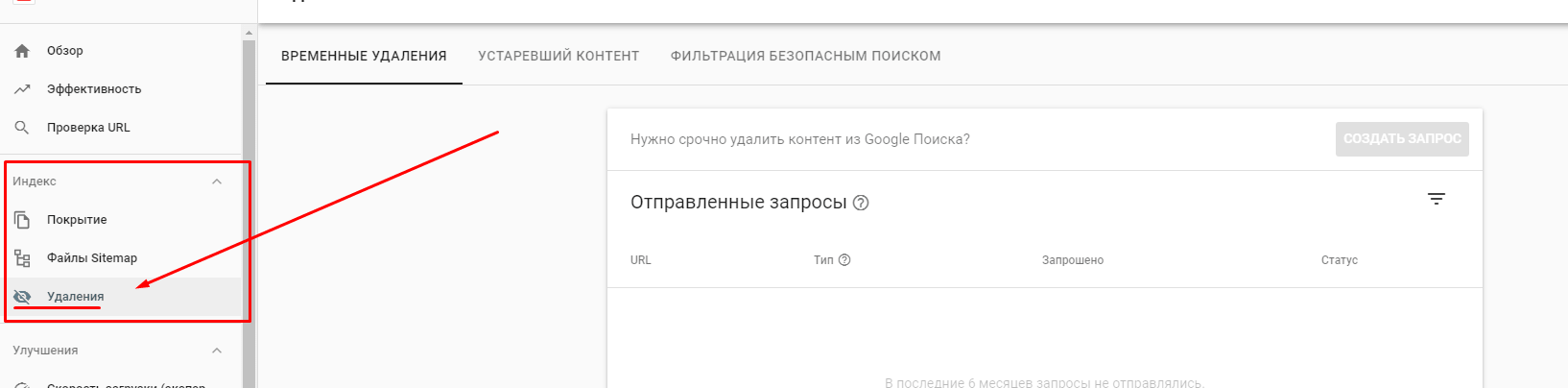

При помощи опций Google Search Console устраняются страницы из списка поисковой выдачи. Для этого вводится URL раздела в специальную форму сервиса, а также указывается причина, по которой его нужно удалить. Найти эту функцию можно в разделе «Индекс». Стоит понимать, что процесс обработки запроса займёт определённое время.

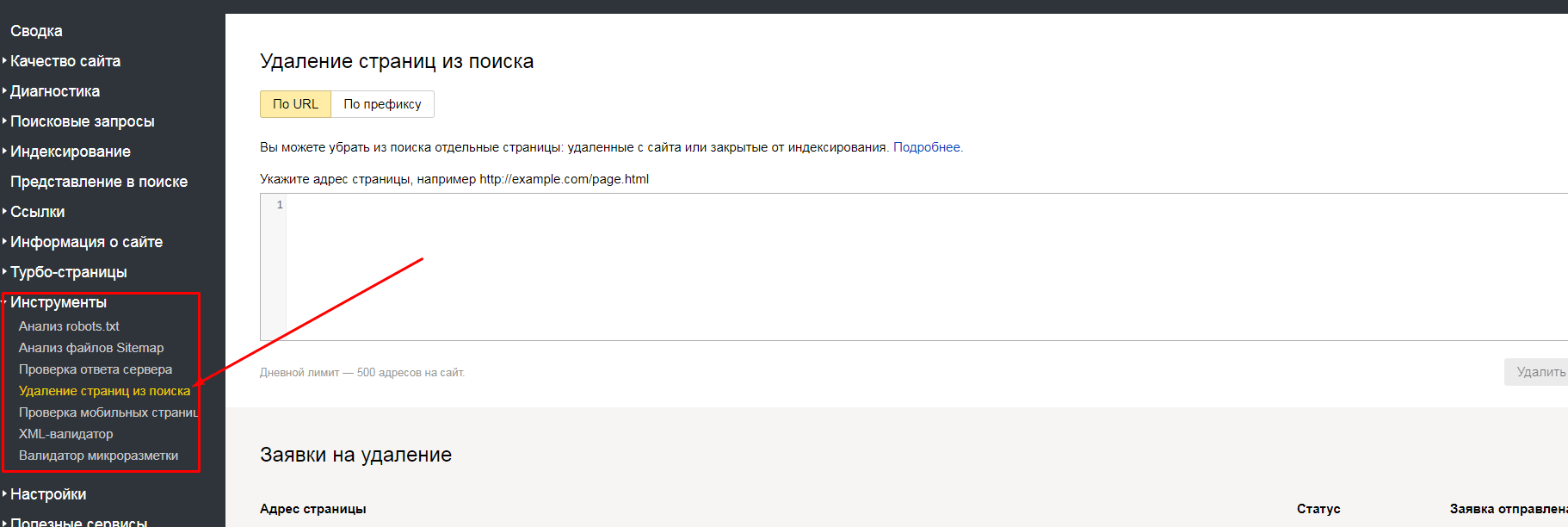

Яндекс.Вебмастер также предлагает исключения страниц: по URL и по префиксу. Найти эти способы можно в разделе «Инструменты».

Применение методики «удаление по URL» подразумевает под собой указание в специальном окне Вебмастера списка страничек, помеченных на удаление. Если же выбран формат удаления «по префиксу», появляется возможность для закрытия всех страниц, относящихся к определённому подразделу сайта. Метод актуален для страниц, содержащих выбранный параметр.

Разберём пример: для оптимизации ресурса https://site.ru удалению должны подвергнуться все странички, относящиеся к разделу catalogue. Чтобы это обеспечить, в Яндекс.Вебмастере открывается вкладка по префиксу и указывается УРЛ https://site.ru/catalogue/. Всё: каждая из страниц, относящихся к подразделу, будет удалена из индекса.

Подводя итог

Ситуации, когда нужно закрыть элементы сайта от индексации, случаются часто. Важность закрытия некоторых частей сайта от индексирования поисковиками неоспорима. Ведь за счёт ограничения доступов к некоторым страницам и документам происходит экономия ресурсов поисковых систем и ускорение индексации ресурса. При этом стоит подойти к удалению страниц из поля зрения ботов-поисковиков с умом. Ведь некорректно проведённая работа принесёт вред позициям ресурса в поисковой выдаче.

Возникли проблемы с индексацией сайта — обращайтесь к нам!