запрет индексации страницы html

Когда и как нужно закрывать сайт от индексации

Индексация сайта поисковыми роботами — процесс сканирования и обработки данных этого сайта и добавления его в специальную базу для последующего ранжирования в выдаче. Именно благодаря индексации сайты попадают в поле видимости потенциальных клиентов. Однако иногда сайты или их отдельные страницы нужно закрывать от индексации. В этой статье рассмотрим, в каких случаях требуется это сделать, разберем способы скрытия ресурсов от поисковых краулеров и покажем, как узнать, закрыт ли сайт от индексации или нет.

Что нужно закрывать от индексации

Важно, чтобы в поисковой выдаче были исключительно целевые страницы, соответствующие запросам пользователей. Поэтому от индексации в обязательном порядке нужно закрывать:

1. Бесполезные для посетителей страницы или контент, который не нужно индексировать. В зависимости от CMS, это могут быть:

Способы закрытия сайта от индексации

Закрыть сайт или страницы сайта от поисковых краулеров можно следующими способами:

С помощью robots.txt

Robots.txt — текстовый файл, который поисковые краулеры посещают в первую очередь. Здесь для них прописываются указания — так называемые директивы.

Этот файл должен соответствовать следующим требованиям:

В robots.txt прописываются такие директивы:

Полный запрет сайта на индексацию в robots.txt

Вы можете запретить индексировать сайт как всем роботам поисковой системы, так и отдельно взятым. Например, чтобы закрыть весь сайт от робота Яндекса, который сканирует изображения, нужно прописать в файле следующее:

Чтобы закрыть для всех роботов:

Чтобы закрыть для всех, кроме указанного:

В данном случае, как видите, индексация доступна для роботов Яндекса.

Запрет на индексацию отдельных страниц и разделов сайта

Для запрета на индексацию одной страницы достаточно прописать ее URL-адрес (домен не указывается) в директиве файла:

Чтобы закрыть раздел или категорию:

Чтобы закрыть все, кроме указанной категории:

Чтобы закрыть все категории, кроме указанной подкатегории:

В качестве подкатегории здесь выступает «main».

Запрет на индексацию прочих данных

Чтобы скрыть директории, в файле нужно указать:

Чтобы скрыть всю директорию, за исключением указанного файла:

Чтобы скрыть UTM-метки:

Чтобы скрыть скриптовые файлы, нужно указать следующее:

По такому же принципу скрываются файлы определенного формата:

Через HTML-код

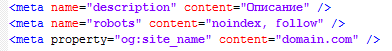

Запретить индексировать страницу можно также с помощью метатегов в блоке в HTML-коде.

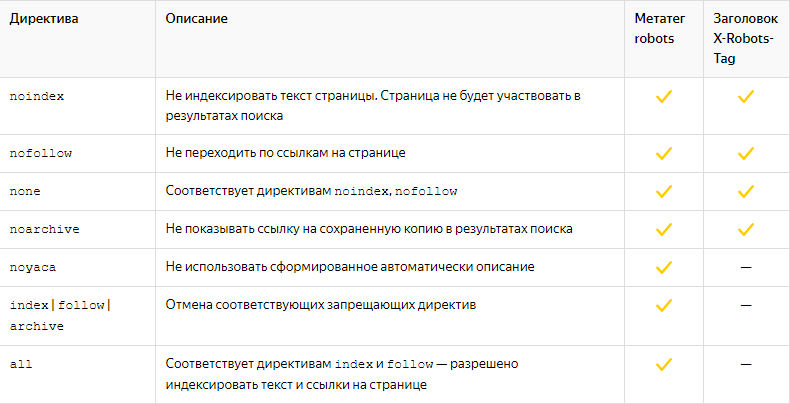

Атрибут «content» здесь может содержать следующие значения:

Открывать и закрывать страницу и ее контент можно для краулеров определенной ПС. Для этого в атрибуте «name» нужно указать название робота:

Чтобы запретить индексировать страницу краулерам Google, нужно ввести:

Чтобы сделать то же самое в Яндексе:

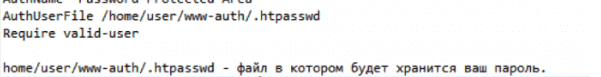

На уровне сервера

Для краулеров Яндекса таким:

На WordPress

В процессе создания сайта на готовой CMS нужно закрывать его от индексации. Здесь мы разберем, как сделать это в популярной CMS WordPress.

Закрываем весь сайт

Закрыть весь сайт от краулеров можно в панели администратора: «Настройки» => «Чтение». Выберите пункт «Попросить поисковые системы не индексировать сайт». Далее система сама отредактирует файл robots.txt нужным образом.

Закрытие сайта от индексации через панель администратора в WordPress

Закрываем отдельные страницы с помощью плагина Yoast SEO

Чтобы закрыть от индексации как весь сайт, так и его отдельные страницы или файлы, установите плагин Yoast SEO.

Для запрета на индексацию вам нужно:

Закрытие от индексации с помощью плагина Yoast SEO

Настройка режима индексации

Запретить индексацию сайта на WordPress можно также через файл robots.txt. Отметим, что в этом случае требуется особый подход к редактированию данного файла, так как необходимо закрыть различные служебные элементы: страницы рассылок, панели администратора, шаблоны и т.д. Если этого не сделать, в поисковой выдаче могут появиться нежелательные материалы, что негативно скажется на ранжировании всего сайта.

Как узнать, закрыт ли сайт от индексации

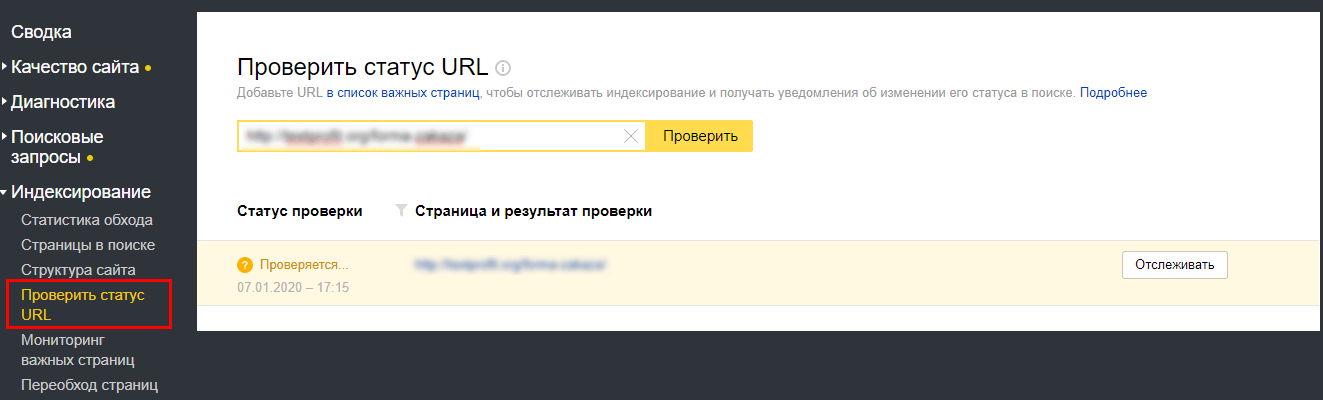

В Яндекс.Вебмастере

Для проверки вам нужно пройти верификацию в Яндексе, зайти в Вебмастер, в правом верхнем углу найти кнопку «Инструменты», нажать и выбрать «Проверка ответа сервера».

Проверка возможности индексации страницы в Яндекс.Вебмастере

В специальное поле на открывшейся странице вставляем URL интересующей страницы. Если страница закрыта от индексации, то появится соответствующее уведомление.

Так выглядит уведомление о запрете на индексацию страницы

Таким образом можно проверить корректность работы файла robots.txt или плагина для CMS.

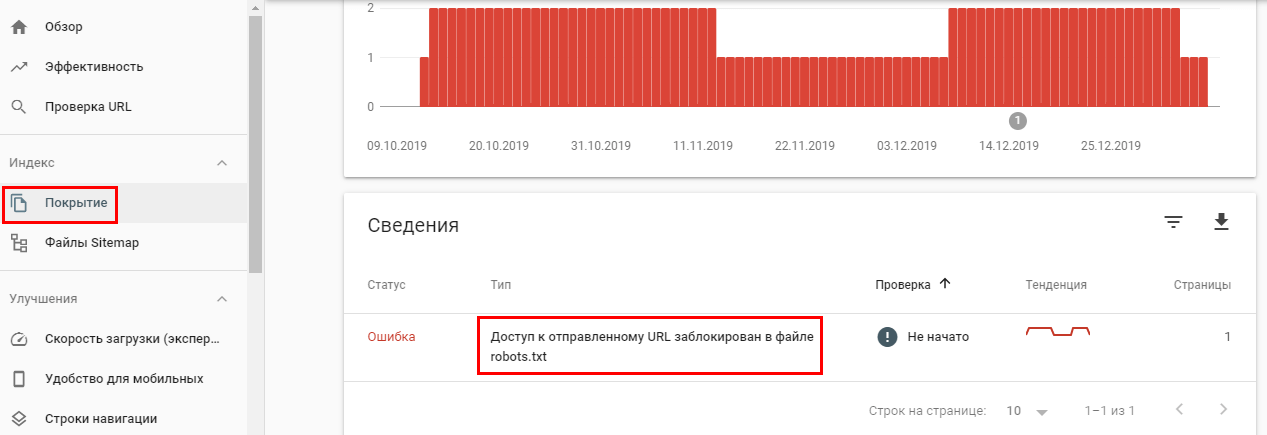

В Google Search Console

Проверка возможности индексации в Google Search Console

С помощью поискового оператора

Введите в поисковую строку следующее: site:https:// + URL интересующего сайта/страницы. В результатах вы увидите количество проиндексированных страниц и так поймете, индексируется ли сайт поисковой системой или нет.

Проверка индексации сайта в Яндексе с помощью специального оператора

Проверка индексации отдельной страницы

С помощью такого же оператора проверить индексацию можно и в Google.

С помощью плагинов для браузера

Мы рекомендуем использовать RDS Bar. Он позволяет увидеть множество SEO-показателей сайта, в том числе статус индексации страницы в основных поисковых системах.

Плагин RDS Bar

Итак, теперь вы знаете, когда сайт или его отдельные страницы/элементы нужно закрывать от индексации, как именно это можно сделать и как проводить проверку, и можете смело применять новые знания на практике.

Какие страницы следует закрывать от индексации

Индексирование сайта – это процесс, с помощью которого поисковые системы, подобные Google и Yandex, анализируют страницы веб-ресурса и вносят их в свою базу данных. Индексация выполняется специальным ботом, который заносит всю необходимую информацию о сайте в систему – веб-страницы, картинки, видеофайлы, текстовый контент и прочее. Корректное индексирование сайта помогает потенциальным клиентам легко найти нужный сайт в поисковой выдаче, поэтому важно знать обо всех тонкостях данного процесса.

В сегодняшней статье я рассмотрю, как правильно настроить индексацию, какие страницы нужно открывать для роботов, а какие нет.

Почему важно ограничивать индексацию страниц

Заинтересованность в индексации есть не только у собственника веб-ресурса, но и у поисковой системы – ей необходимо предоставить релевантную и, главное, ценную информацию для пользователя. Чтобы удовлетворить обе стороны, требуется проиндексировать только те страницы, которые будут интересны и целевой аудитории, и поисковику.

Прежде чем переходить к списку ненужных страниц для индексации, давайте рассмотрим причины, из-за которых стоит запрещать их выдачу. Вот некоторые из них:

В краулинговый бюджет входят: взломанные страницы, файлы CSS и JS, дубли, цепочки редиректов, страницы со спамом и прочее.

Что нужно скрывать от поисковиков

В первую очередь стоит ограничить индексирование всего сайта, который еще находится на стадии разработки. Именно так можно уберечь базу данных поисковых систем от некорректной информации. Если ваш веб-ресурс давно функционирует, но вы не знаете, какой контент стоит исключить из поисковой выдачи, то рекомендуем ознакомиться с нижеуказанными инструкциями.

PDF и прочие документы

Часто на сайтах выкладываются различные документы, относящиеся к контенту определенной страницы (такие файлы могут содержать и важную информацию, например, политику конфиденциальности).

Рекомендуется отслеживать поисковую выдачу: если заголовки PDF-файлов отображаются выше в рейтинге, чем страницы со схожим запросом, то их лучше скрыть, чтобы открыть доступ к наиболее релевантной информации. Отключить индексацию PDF и других документов вы можете в файле robots.txt.

Разрабатываемые страницы

Стоит всегда избегать индексации разрабатываемых страниц, чтобы рейтинг сайта не снизился. Используйте только те страницы, которые оптимизированы и наполнены уникальным контентом. Настроить их отображение можно в файле robots.txt.

Копии сайта

Если вам потребовалось создать копию веб-ресурса, то в этом случае также необходимо все правильно настроить. В первую очередь укажите корректное зеркало с помощью 301 редиректа. Это позволит оставить прежний рейтинг у исходного сайта: поисковая система будет понимать, где оригинал, а где копия. Если же вы решитесь использовать копию как оригинал, то делать это не рекомендуется, так как возраст сайта будет обнулен, а вместе с ним и вся репутация.

Веб-страницы для печати

Иногда контент сайта требует уникальных функций, которые могут быть полезны для клиентов. Одной из таких является «Печать», позволяющая распечатать необходимые страницы на принтере. Создание такой версии страницы выполняется через дублирование, поэтому поисковые роботы могут с легкостью установить копию как приоритетную. Чтобы правильно оптимизировать такой контент, необходимо отключить индексацию веб-страниц для печати. Сделать это можно с использованием AJAX, метатегом либо в файле robots.txt.

Формы и прочие элементы сайта

Большинство сайтов сейчас невозможно представить без таких элементов, как личный кабинет, корзина пользователя, форма обратной связи или регистрации. Несомненно, это важная часть структуры веб-ресурса, но в то же время она совсем бесполезна для поисковых запросов. Подобные типы страниц необходимо скрывать от любых поисковиков.

Страницы служебного пользования

Формы авторизации в панель управления и другие страницы, используемые администратором сайта, не несут никакой важной информации для обычного пользователя. Поэтому все служебные страницы следует исключить из индексации.

Личные данные пользователя

Вся персональная информация должна быть надежно защищена – позаботиться о ее исключении из поисковой выдачи нужно незамедлительно. Это относится к данным о платежах, контактам и прочей информации, идентифицирующей конкретного пользователя.

Страницы с результатами поиска по сайту

Как и в случае со страницами, содержащими личные данные пользователей, индексация такого контента не нужна: веб-страницы результатов полезны для клиента, но не для поисковых систем, так как содержат неуникальное содержание.

Сортировочные страницы

Контент на таких веб-страницах обычно дублируется, хоть и частично. Однако индексация таких страниц посчитается поисковыми системами как дублирование. Чтобы снизить риск возникновения таких проблем, рекомендуется отказаться от подобного контента в поисковой выдаче.

Пагинация на сайте

Пагинация – без нее сложно представить существование любого крупного веб-сайта. Чтобы понять ее назначение, приведу небольшой пример: до появления типичных книг использовались свитки, на которых прописывался текст. Прочитать его можно было путем развертывания (что не очень удобно). На таком длинном холсте сложно найти нужную информацию, нежели в обычной книге. Без использования пагинации отыскать подходящий раздел или товар также проблематично.

Пагинация позволяет разделить большой массив данных на отдельные страницы для удобства использования. Отключать индексирование для такого типа контента нежелательно, требуется только настроить атрибуты rel=»canonical», rel=»prev» и rel=»next». Для Google нужно указать, какие параметры разбивают страницы – сделать это можно в Google Search Console в разделе «Параметры URL».

Помимо всего вышесказанного, рекомендуется закрывать такие типы страниц, как лендинги для контекстной рекламы, страницы с результатами поиска по сайту и поиск по сайту в целом, страницы с UTM-метками.

Какие страницы нужно индексировать

Ограничение страниц для поисковых систем зачастую становится проблемой – владельцы сайтов начинают с этим затягивать или случайно перекрывают важный контент. Чтобы избежать таких ошибок, рекомендуем ознакомиться с нижеуказанным списком страниц, которые нужно оставлять во время настройки индексации сайта.

Соблюдение индексации таких страниц может значительно улучшить поисковую выдачу, если ранее оптимизация не проводилась.

Как закрыть страницы от индексации

Мы детально рассмотрели список всех страниц, которые следует закрывать от поисковых роботов, но о том, как это сделать, прошлись лишь вскользь – давайте это исправлять. Выполнить это можно несколькими способами: с помощью файла robots.txt, добавления специальных метатегов, кода, сервисов для вебмастеров, а также с использованием дополнительных плагинов. Рассмотрим каждый метод более детально.

Способ 1: Файл robots.txt

Данный текстовый документ – это файл, который первым делом посещают поисковики. Он предоставляет им информацию о том, какие страницы и файлы на сайте можно обрабатывать, а какие нет. Его основная функция – сократить количество запросов к сайту и снизить на него нагрузку. Он должен удовлетворять следующим критериям:

Прежде чем переходить к редактированию файла, рекомендую обратить внимание на ограничивающие факторы.

Файл robots.txt включает в себя такие параметры, как:

Теперь давайте рассмотрим, как можно отключить индексацию определенных страниц или всего сайта. Все пути в примерах – условные.

Пропишите, чтобы исключить индексацию сайта для всех роботов:

Блокировка индексирования при помощи директивы noindex

Вы можете заблокировать показ страницы в Google Поиске или других ресурсах, добавив на нее метатег noindex или заголовок noindex в HTTP-ответ. Робот Googlebot проигнорирует страницу, обнаружив такой метатег или заголовок во время ее сканирования, даже если на эту страницу ссылаются другие сайты.

Директива noindex позволяет управлять доступом к отдельным страницам сайта. Это может быть полезно, если у вас нет доступа к корневому каталогу на сервере.

Как применять директиву noindex

Применить директиву noindex можно двумя способами: как метатег или как заголовок HTTP-ответа. Они работают одинаково, поэтому выбор подходящего способа будет зависеть от вашего сайта и типа контента, расположенного на нем.

» l10n-translatable-tag-attribute-2-data-text=» tag»>Тег

Чтобы запретить большинству поисковых роботов индексировать определенную страницу вашего сайта, добавьте в ее раздел следующий метатег:

Если вы хотите закрыть доступ к странице только роботам Google, используйте такой код:

Учитывайте, что некоторые поисковые системы могут иначе интерпретировать директиву noindex и показывать в результатах поиска страницу, на которой она используется.

Заголовок HTTP-ответа

Как помочь роботам Googlebot обнаруживать метатеги

Чтобы обнаружить метатеги и HTTP-заголовки, мы должны просканировать вашу страницу. Если страница продолжает появляться в результатах поиска, вероятно, мы ещё не просканировали ее после добавления тега. Воспользуйтесь инструментом проверки URL, чтобы запросить повторное сканирование страницы роботом Google. Другая возможная причина: файл robots.txt запрещает роботу Googlebot доступ к URL и не дает ему обнаружить метатег. Чтобы предоставить роботам Google доступ к вашей странице, вам необходимо изменить файл robots.txt. Это можно сделать с помощью специального инструмента.

Except as otherwise noted, the content of this page is licensed under the Creative Commons Attribution 4.0 License, and code samples are licensed under the Apache 2.0 License. For details, see the Google Developers Site Policies. Java is a registered trademark of Oracle and/or its affiliates.

Как закрыть сайт от индексации

Поделиться этим постом

Закрывать сайт от индексации нужно, например, при проведении технических работ. Это можно сделать несколькими способами: через robots.txt, метатег robots или заголовок X-Robots-Tag. Вебмастера иногда сталкиваются с ситуацией, когда запрет не срабатывает, и страницы сайта все равно индексируются поисковиками. В посте расскажем о том, как запретить индексацию сайта и убедиться в корректности этого запрета.

1. Зачем закрывать сайт или страницу от индексации

После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть сайт от поисковиков. В каких ещё ситуациях нужен запрет на индексацию:

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

2. Как закрыть сайт от индексации

Я уже упомянула, что полностью запретить индексацию сайта можно тремя способами. Теперь предлагаю рассмотреть каждый из них отдельно.

2.1. Robots.txt

Файл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

Для обращения к конкретному роботу вместо «*» используйте его название. Например, если нужно закрыть сайт от Яндекс, впишите в robots.txt:

Если требуется закрыть от индексации всеми роботами определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву. Пример:

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

Для проверки в Яндекс.Вебмастер перейдите в раздел «Индексирование».

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, используйте следующий метод.

2.2. Метатег Robots

Этим способом можно предотвратить сканирование роботами контента. С его помощью можно также закрыть текст от индексации. Это необходимо, когда страницу нужно проиндексировать за исключением отрывка текста. Для этого добавьте в раздел страницы строку кода:

Чтобы скрыть ссылку от поисковиков, используйте nofollow:

Если и этот вариант не помогает, используйте метод серверного заголовка, описанный в следующем пункте.

2.3. X-Robots-Tag

С помощью X-Robots-Tag можно закрыть от индексации медиа-контент, скрипты и другие файлы. Для этого нужно указать их формат после директивы FilesMatch в первой строке заголовка.

Большинство директив, которые можно использовать в X-Robots-Tag, совпадают с директивами Robots.

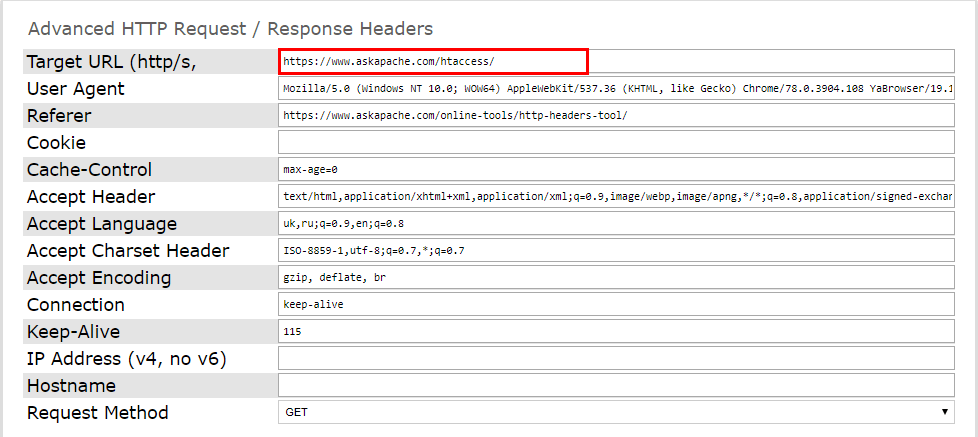

И проверьте работоспособность серверного заголовка. Это можно сделать при помощи онлайн-инструментов. Например, Askapache. Введите нужную страницу и запустите проверку.

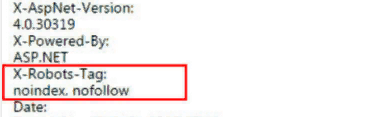

Подключённый заголовок выглядит так:

Проверить код ответа сервера можно и через Яндекс.Вебмастер. Активный X-Robots-Tag отобразится в списке всех заголовков ответа сервера.

Что необходимо закрывать от индексации на сайте

Что такое индексация сайта

Индексация – это процесс сканирования сайта поисковыми роботами и внесение полученной информации в базу данных поисковика. Для получения статуса проиндексированного ресурсу необходимо, чтобы на него зашёл поисковый бот. Такие боты заносят в систему информацию и о сайте, и обо всех его страницах, и о материалах (видео, тексты, картинки), доступных для поиска.

В интересах владельца сайта, чтобы его целевая аудитория могла быстро найти конкретный веб-ресурс в выдаче. Цель же поисковой системы – предоставление пользователю ценной и релевантной информации. А значит, чтобы выполнялись и цели владельца сайта, и цели поисковика, стоит позаботиться о корректной индексации. А для этого открываются только те данные, которые будут полезны и уместны в результатах поиска.

Причины, по которым запрещается сканирование страницы или отдельной информации на ней:

В то же время важно убедиться, что страницы с уникальной, важной и полезной для пользователя информацией открыты для индексации.

Что следует закрывать на сайте

Скрыть от поискового бота можно как часть контента, так и полную информацию на странице или весь сайт. Разберёмся, какие из данных можно закрыть:

Рассмотрим коротко каждый из пунктов.

Размещённый контент

Нередко данные, размещаемые на сайте, дублируются на разных страницах. Например, это может быть дополнительное меню или блок текста, или ссылка на другие ресурсы. Иногда для оптимизации сайта такую информацию стоит закрыть от поисковиков, но делать это мы рекомендуем только в исключительных случаях либо не делать вовсе.

Страницы

Здесь подразумеваются страницы разного типа. В перечень таковых включаются:

Весь сайт

Например, если ресурс находится в процессе разработки, лучше скрыть его на этапе создания и наполнения, чтобы в поисковую базу не попала некорректная информация о сайте.

Какие данные закрывать не стоит

Увлёкшись закрытием информации, владельцы сайтов нередко «перегибают палку». Так, есть ряд данных, сокрытие которых может больше навредить, чем принести пользу в поисковой выдаче. К таковым относятся:

Другими словами, надо тщательно рассмотреть вопрос распределения открытых и скрытых от индексации страниц. Разобравшись с этим, переходим к инструментам для выполнения задачи.

Как закрывать от индексации контент, страницу или весь сайт

Обсудим набор инструментов для корректного закрытия данных сайта от поискового бота. К ним относятся:

Рассмотрим, как работать с каждым из них.

Файл robots.txt

Robots.txt представляет собой служебный файл текстового типа, содержащий набор рекомендаций для работы ботов-поисковиков. Расположен в корневой папке сайта и именно с него начинается изучение ресурса поисковой системой. В документ включён перечень директив, за счёт которых ограничивается доступность определённых частей сайта для роботов.

Так, добавив к тегу Disallow наименование раздела или папки, получится закрыть их от сканирования. Подробнее о настройке файла robots.txt можно прочитать здесь.

При этом важно проверить отсутствие внешних ссылок, ведущих к этому участку сайта.

Способ отличается удобством, скоростью выполнения и простотой применения. Но использование только этого инструмента не гарантирует отсутствия индексирования по выбранным страницам.

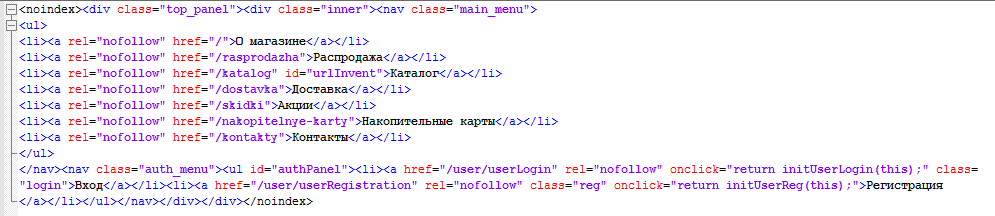

Применение тега Noindex и метатега Robots

Метатег Robots используется для задания детальных настроек на уровне страницы. От такой настройки зависит и индексация страницы, и её отображение в результатах поиска. В разделе страницы следует размещать метатег robots.

Тегом noindex запрещается демонстрация поисковиками страницы в результатах поиска. Значение robots, задаваемое для атрибута name, говорит о том, что директива касается каждого поискового робота. Если нужно закрыть доступ только одному из ботов, вместо robots указывается другое значение атрибута name – наименование определённого робота.

Отдельных поисковых ботов также называют агентами пользователя (роботом используется агент пользователя при запросе страницы). Для примера: агентом пользователя стандартного поискового робота Google называется Googlebot. Запрет сканирования страницы только им оформляется изменением тега таким образом:

Этот инструмент почти со 100% гарантией выполняет поставленную задачу.

Тег noindex используют также в HTML-коде страницы для закрытия части контента страницы от индексации. Однако тег не гарантирует того, что контент не будет проиндексирован.

Можно также использовать JavaScript для этой цели, так как тег noindex игнорируется ботами Google (он распознается только Яндексом). При использовании данного метода текст, блок, код, ссылка или любой другой контент кодируется в Javascript, а далее скрипт закрывается от индексации при помощи Robots.txt. Но следует помнить, поисковики настаивают на том, чтобы информация для пользователей и для роботов была идентичной.

Таким способом полностью закрывается доступ поисковикам к контенту сайта. Однако наличие пароля делает сайт труднодоступным для сканирования на наличие ошибок. Это происходит из-за того, что не у всех сервисов проверки есть опция ввода пароля.

С помощью JavaScript

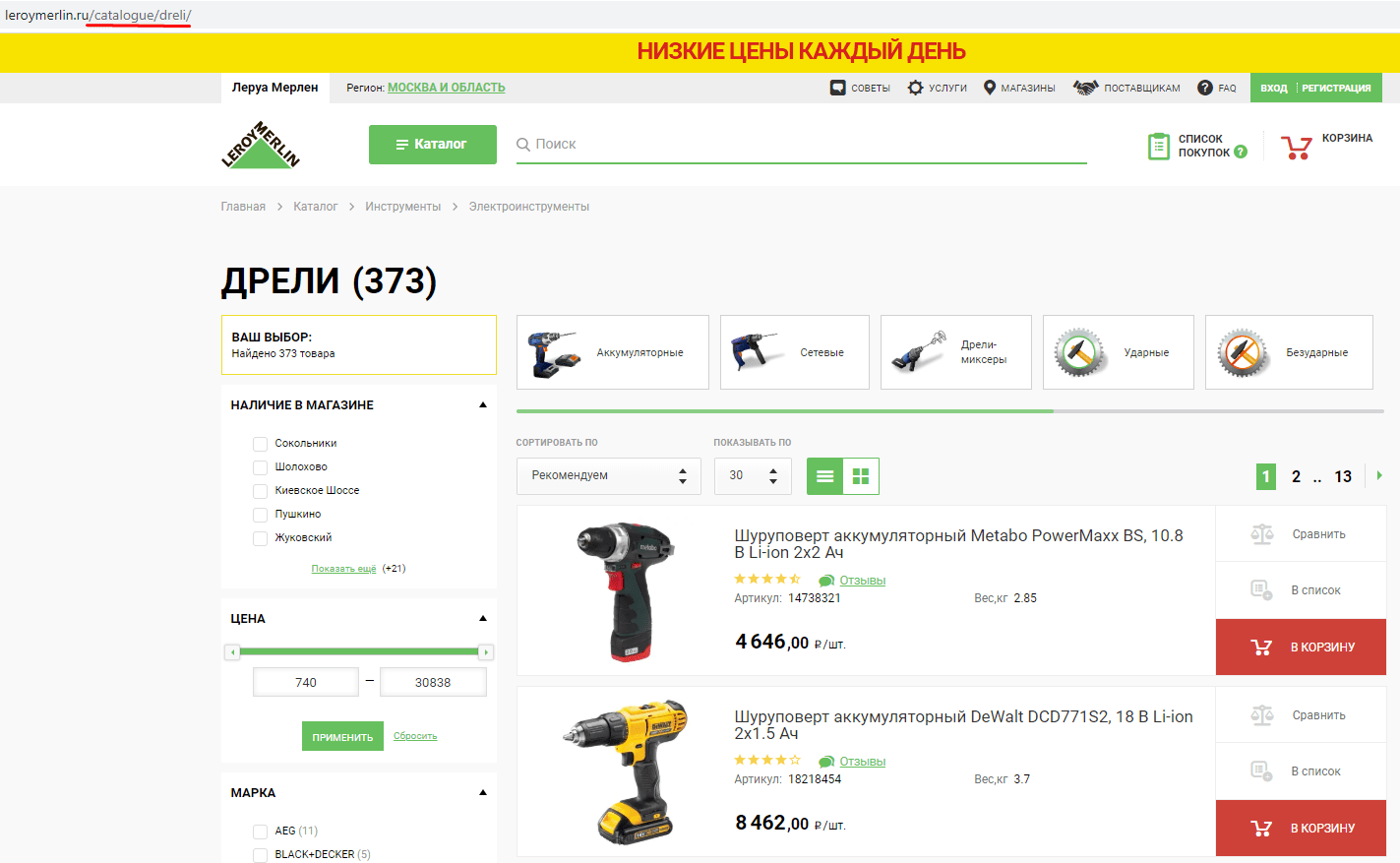

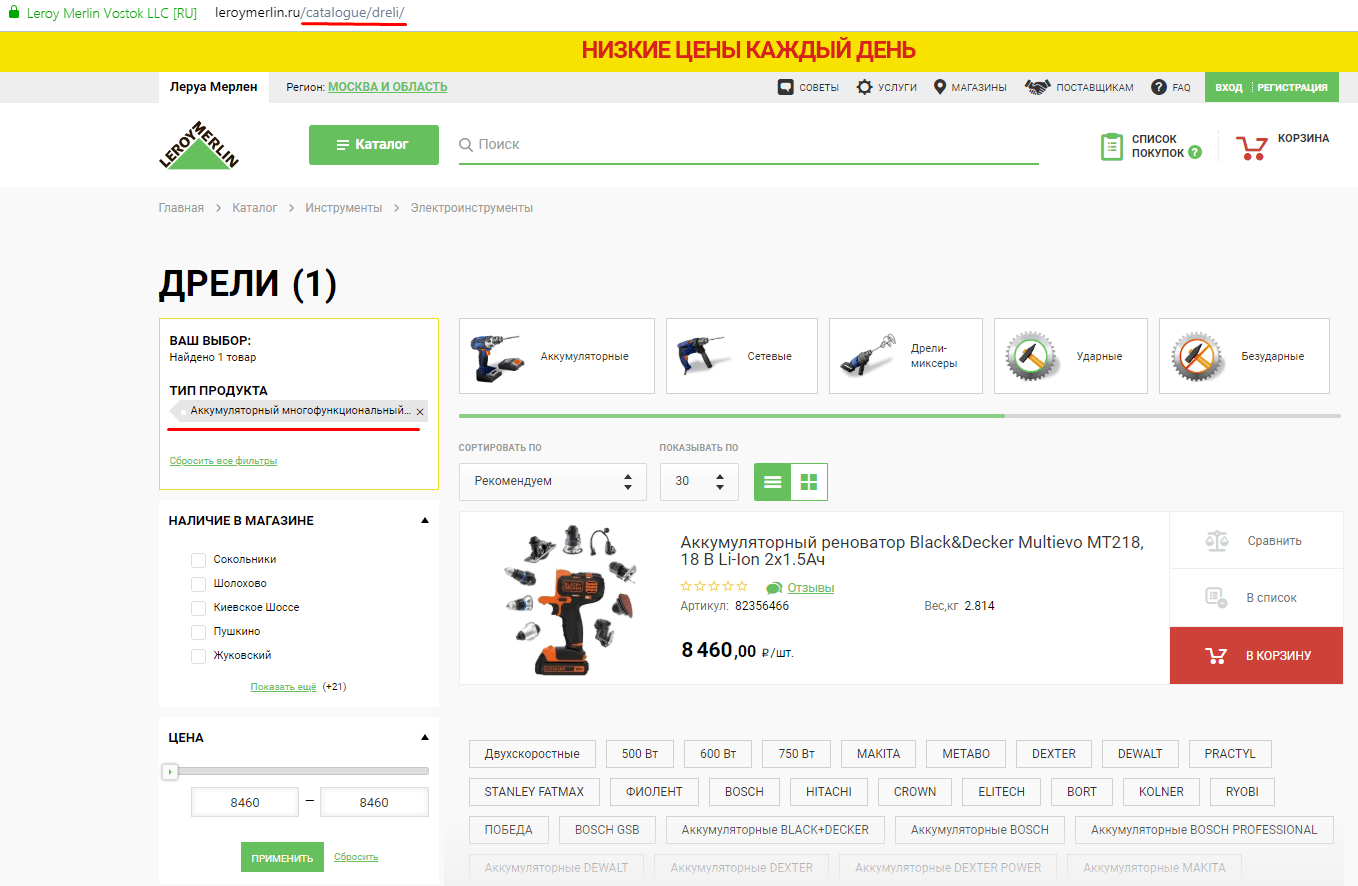

Например с помощью скрипта Ajax можно не столько скрывать дублирующие и «мусорные» страницы, сколько исключить сам факт их создания. То есть содержание страницы меняется без изменения в URL, даже когда пользователь вводит при помощи фильтра определённые параметры товаров интернет-магазина.

Разберём на примере. Вот страница без фильтра:

Вот та же страница с выбранным фильтром:

Как видим, в последнем примере были выбраны фильтры, подгружены товары, однако URL страницы не поменялся.

Метод эффективный, но трудоёмкий. К тому же его не получится применить ко всем параметрам сайта, которые необходимо скрыть от индексации.

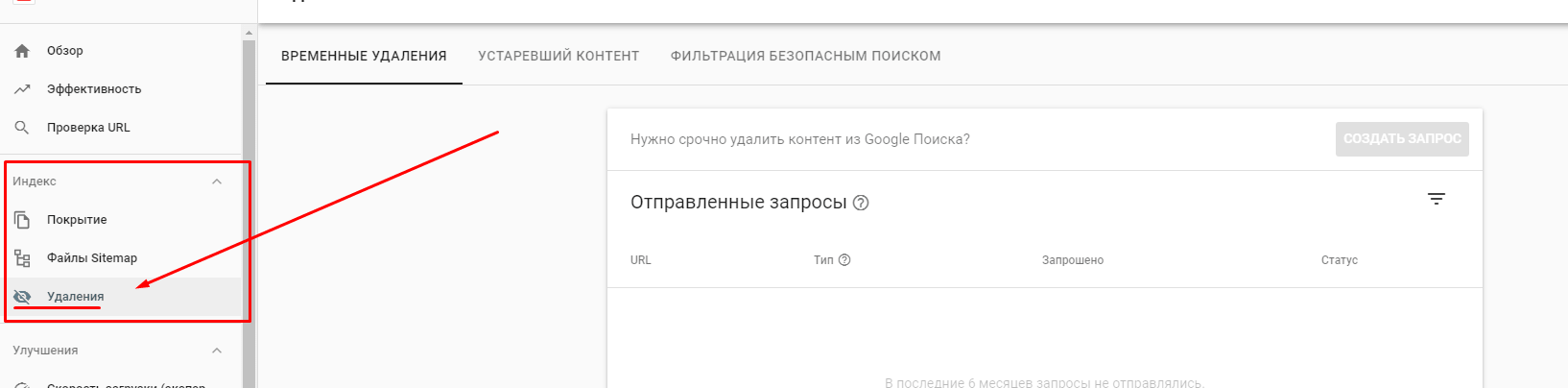

Инструменты удаления страниц из индекса

Иногда «ненужным страницам» всё же удаётся обойти запреты и попасть в индекс. Их оперативное устранение улучшит положение сайта в рейтинге поисковой системы.

Это актуально как для Google, так и для Яндекса.

При помощи опций Google Search Console устраняются страницы из списка поисковой выдачи. Для этого вводится URL раздела в специальную форму сервиса, а также указывается причина, по которой его нужно удалить. Найти эту функцию можно в разделе «Индекс». Стоит понимать, что процесс обработки запроса займёт определённое время.

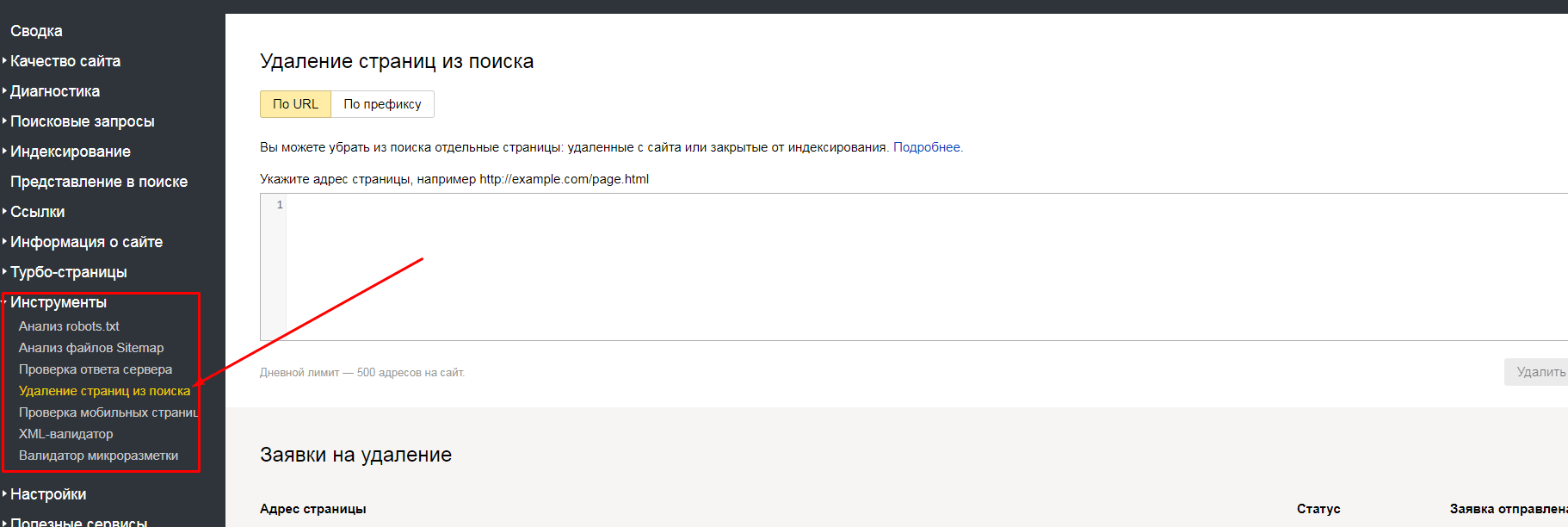

Яндекс.Вебмастер также предлагает исключения страниц: по URL и по префиксу. Найти эти способы можно в разделе «Инструменты».

Применение методики «удаление по URL» подразумевает под собой указание в специальном окне Вебмастера списка страничек, помеченных на удаление. Если же выбран формат удаления «по префиксу», появляется возможность для закрытия всех страниц, относящихся к определённому подразделу сайта. Метод актуален для страниц, содержащих выбранный параметр.

Разберём пример: для оптимизации ресурса https://site.ru удалению должны подвергнуться все странички, относящиеся к разделу catalogue. Чтобы это обеспечить, в Яндекс.Вебмастере открывается вкладка по префиксу и указывается УРЛ https://site.ru/catalogue/. Всё: каждая из страниц, относящихся к подразделу, будет удалена из индекса.

Подводя итог

Ситуации, когда нужно закрыть элементы сайта от индексации, случаются часто. Важность закрытия некоторых частей сайта от индексирования поисковиками неоспорима. Ведь за счёт ограничения доступов к некоторым страницам и документам происходит экономия ресурсов поисковых систем и ускорение индексации ресурса. При этом стоит подойти к удалению страниц из поля зрения ботов-поисковиков с умом. Ведь некорректно проведённая работа принесёт вред позициям ресурса в поисковой выдаче.

Возникли проблемы с индексацией сайта — обращайтесь к нам!